Kredit:Tautkutè &Trzcinski

Forskare vid den polsk-japanska akademin för informationsteknologi och Warszawas tekniska universitet har utvecklat en DAN-modell (deep alignment network) för att klassificera och visualisera känslor. Deras metod visade sig överträffa de senaste känsloklassificeringsmetoderna på två benchmark-datauppsättningar.

Att utveckla modeller som kan känna igen och klassificera mänskliga känslor är en nyckelutmaning inom området maskininlärning och datorseende. De flesta befintliga verktyg för känsloigenkänning använder flerskiktiga faltningsnätverk, som inte uttryckligen härleder ansiktsdrag i klassificeringsfasen.

Ivona Tautkute och Tomasz Trzcinski, forskarna som genomförde den senaste studien, arbetade från början på ett system för en Kalifornien-baserad start som kunde integreras i autonoma bilar. Detta system kunde räkna passagerare baserat på data som extraherades från en enda videokamera monterad inuti bilen.

I ett senare skede, de två forskarna började utforska modeller som kunde göra mer än detta, skapa bredare statistik om passagerare genom att uppskatta deras ålder och kön. En uppenbar förlängning av detta system var att det kunde upptäcka ansiktsuttryck och känslor, också.

"Eftersom systemet skulle användas med äldre passagerare, det var viktigt att fånga negativa och positiva känslor förknippade med förarens urkoppling, " Tautkute förklarade. "Befintliga metoder för att känna igen känslor är långt ifrån perfekta, så vi började titta på intressanta nya sätt att förbättra. En idé kom till oss efter en diskussion med en kollega datorseende forskare, Marek Kowalski, som arbetade med ansiktsjustering med djupjusteringsnätverk (DAN). Placeringen av landmärken i ansiktet är direkt relaterat till uttryckta känslor, så vi var nyfikna på om vi kunde bygga ett system som skulle kombinera dessa två uppgifter."

EmotionalDAN, modellen utarbetad av Tautkute och Trzcinski, är en anpassning av Kowalskis DAN-modell, som inkluderar en term relaterad till ansiktsdrag. Tack vare denna modifiering, deras modell lär sig samtidigt platsen för både ansiktets landmärken och uttryckta känslor.

Kredit:Tautkutè &Trzcinski

Kredit:Tautkutè &Trzcinski

Kredit:Tautkutè &Trzcinski

Kredit:Tautkutè &Trzcinski

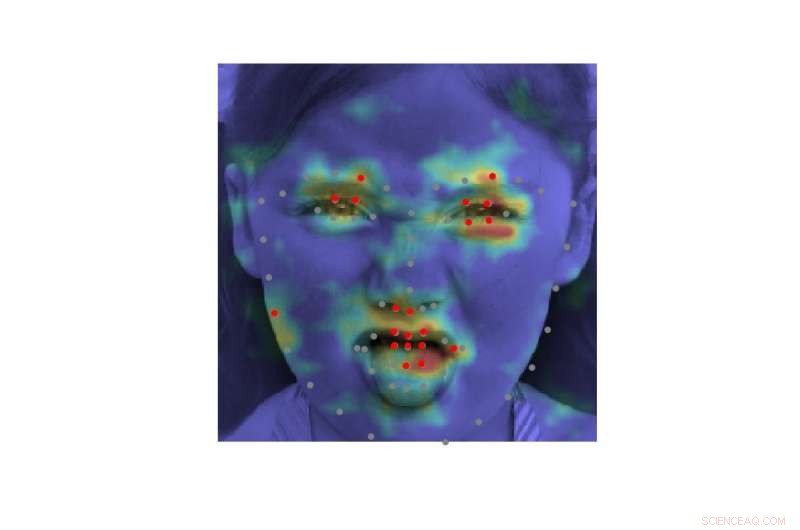

"Vi uppnådde detta genom att utöka förlustfunktionen för den ursprungliga DAN med en term som ansvarar för känsloklassificering, " Tautkute sade. "Det neurala nätverket tränas i på varandra följande stadier som möjliggör förfining av ansikts landmärken och inlärda känslor. Det sker också överföring av information mellan steg, som håller reda på den normaliserade ansiktsinmatningen, funktionskarta och landmärkens värmekarta."

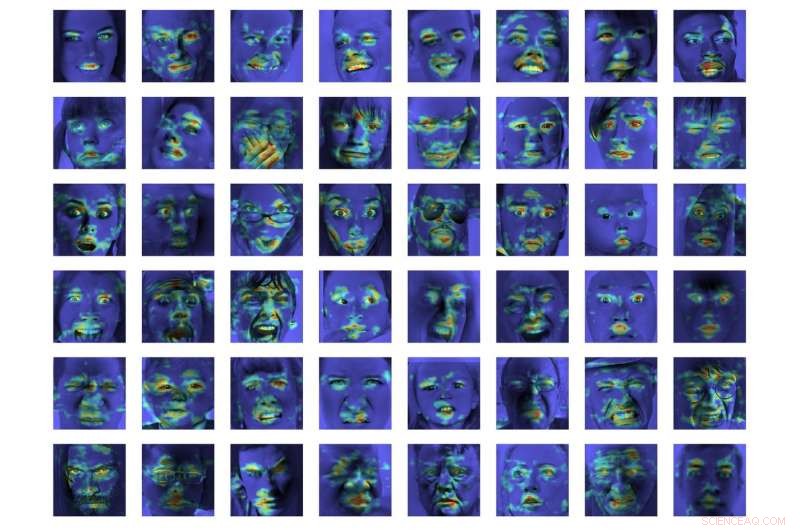

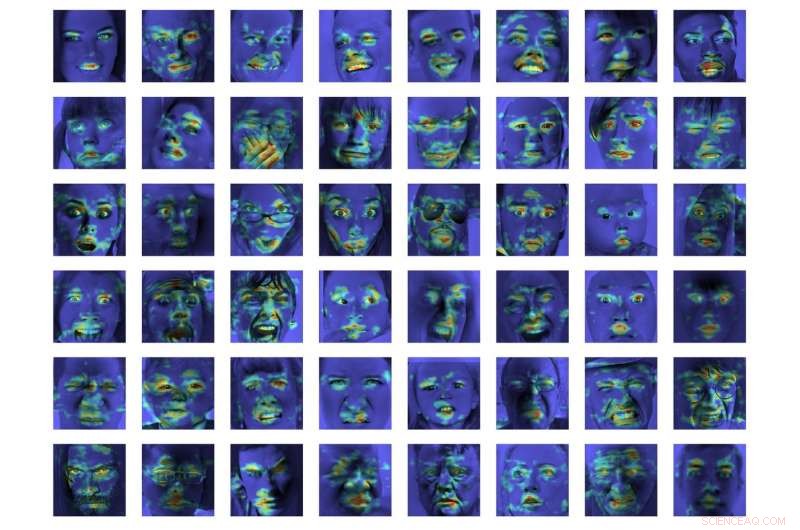

I en första utvärdering, EmotionalDAN överträffade de senaste klassificeringsmetoderna med 5 procent på två benchmark-datauppsättningar, nämligen CK+ och ISED. Forskarna kunde också visualisera bildregioner som analyserats av deras modell när de fattade ett beslut. Deras observationer avslöjade att EmotionalDAN korrekt kunde identifiera landmärken i ansiktet associerade med uttryck av känslor hos människor.

"Det som verkligen är intressant med vår studie är att även om vi inte matar någon emotionell rumslig information till nätverket, modellen kan själv lära sig vilka ansiktsregioner man bör titta på när man försöker förstå ansiktsuttryck, ", sa Tautkute. "Vi människor tittar intuitivt på en persons ögon och mun för att lägga märke till leenden eller sorg, men det neurala nätverket ser bara en matris av pixlar. Att verifiera vilka bildregioner som är aktiverade för ett givet klassificeringsbeslut tar oss ett steg närmare att förstå modellen och hur den fattar beslut."

Kredit:Tautkutè &Trzcinski.

Trots de mycket lovande resultaten som uppnåtts av EmotionalDAN och andra verktyg för emotionsigenkänning, Att förstå mänskliga känslor är fortfarande en mycket komplex uppgift. Medan befintliga system har uppnått anmärkningsvärda resultat, de har i första hand kunnat göra det när känslor uttrycks i betydande grad.

I verkliga situationer, dock, de känslomässiga signaler som uttrycks av människor är ofta mycket subtilare. Till exempel, en persons lycka kanske inte alltid förmedlas genom att visa alla tänder i ett brett leende, men kan bara innebära en liten rörelse av läpphörnen.

"Det skulle vara riktigt intressant att förstå mer subjektiva aspekter av känslor och hur deras uttryck skiljer sig mellan individer, " sa Tautkute. "För att gå längre, man skulle kunna försöka skilja falska känslor från äkta. Till exempel, neurologer uppger att olika ansiktsmuskler är inblandade i verkliga och falska leenden. Särskilt, ögonmusklerna drar sig inte ihop i det påtvingade uttrycket. Det skulle vara intressant att upptäcka liknande samband med hjälp av information från data."

© 2018 Science X Network