En ny upptäckt av forskare vid University of Chicago lovar att förbättra hastigheten och tillförlitligheten hos nuvarande och nästa generations kvantdatorer med så mycket som tio gånger. Genom att kombinera principer från fysik och datavetenskap, forskarna utvecklade en ny skalbar kompilator som gör programvara medveten om den underliggande kvanthårdvaran, erbjuder betydande prestandafördelar när forskare tävlar om att bygga de första praktiska kvantdatorerna.

UChicagos forskargrupp består av datavetare och fysiker från samarbetet EPiQC (Enabling Practical-scale Quantum Computation), en NSF Expedition in Computing som startade 2018. EPiQC syftar till att överbrygga gapet från befintliga teoretiska algoritmer till praktiska kvantberäkningsarkitekturer på enheter på kort sikt.

Sammanfogande tillvägagångssätt från datavetenskap och fysik

Kärntekniken bakom EPiQC-teamets papper anpassar kvantoptimal kontroll, ett tillvägagångssätt utvecklat av fysiker långt innan kvantberäkning var möjlig. Kvantoptimal kontroll finjusterar kontrollrattarna för kvantsystem för att kontinuerligt driva partiklar till önskade kvanttillstånd – eller i ett datorsammanhang, implementera ett önskat program.

Om anpassningen lyckas, kvantoptimal kontroll skulle tillåta kvantdatorer att köra program med högsta möjliga effektivitet...men det kommer med en prestandaavvägning.

"Fysiker har faktiskt använt kvantoptimal kontroll för att manipulera små system i många år, men problemet är att deras tillvägagångssätt inte skalas, " sa forskaren Yunong Shi.

Även med banbrytande hårdvara, det tar flera timmar att köra kvantoptimal kontroll riktad till en maskin med bara 10 kvantbitar (qubits). Dessutom, denna löptid skalar exponentiellt, vilket gör kvantoptimal kontroll ohållbar för de 20-100 qubit-maskiner som förväntas under det kommande året.

Under tiden, datavetare har utvecklat sina egna metoder för att kompilera kvantprogram ner till kvanthårdvarans kontrollrattar. Det datavetenskapliga tillvägagångssättet har fördelen av skalbarhet – kompilatorer kan enkelt kompilera program för maskiner med tusentals qubits. Dock, dessa kompilatorer är i stort sett omedvetna om den underliggande kvanthårdvaran. Ofta, det finns en allvarlig obalans mellan de kvantoperationer som programvaran hanterar kontra de som hårdvaran utför. Som ett resultat, de sammanställda programmen är ineffektiva.

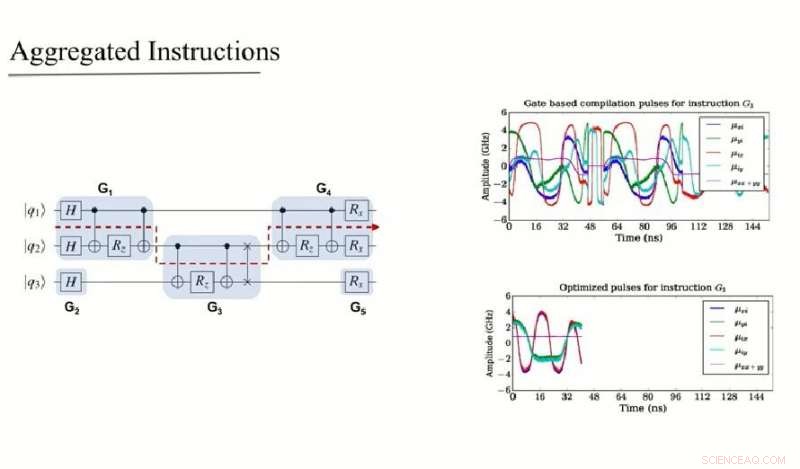

EPiQC-teamets arbete kombinerar datavetenskap och fysik genom att intelligent dela upp stora kvantprogram i underprogram. Varje underprogram är tillräckligt litet för att det kan hanteras av fysikmetoden kvantoptimal kontroll, utan att stöta på prestandaproblem. Detta tillvägagångssätt realiserar både skalbarheten på programnivå hos traditionella kompilatorer från datavetenskapsvärlden och effektivitetsvinsterna på underprogramnivå med kvantoptimal kontroll.

Den intelligenta genereringen av underprogram drivs av en algoritm för att utnyttja kommutativitet – ett fenomen där kvantoperationer kan omordnas i valfri ordning. Över ett brett utbud av kvantalgoritmer, relevant både på kort och lång sikt, EPiQC-teamets kompilator uppnår två till tio gånger exekveringshastigheter över baslinjen. Men på grund av qubitarnas bräcklighet, snabbheterna i körning av kvantprogram leder till exponentiellt högre framgångsfrekvenser för den ultimata beräkningen. Som Shi betonar, "på kvantdatorer, Att påskynda din avrättningstid är att göra-eller-dö."

Bryter abstraktionsbarriärer

Denna nya kompilatorteknik är en betydande avvikelse från tidigare arbete. "Tidigare kompilatorer för kvantprogram har modellerats efter kompilatorer för moderna konventionella datorer, sa Fred Chong, Seymour Goodman professor i datavetenskap vid UChicago och ledande PI för EPiQC. Men till skillnad från vanliga datorer, kvantdatorer är notoriskt ömtåliga och bullriga, så tekniker optimerade för konventionella datorer fungerar inte bra till kvantdatorer. "Vår nya kompilator är till skillnad från den tidigare uppsättningen klassiskt inspirerade kompilatorer eftersom den bryter abstraktionsbarriären mellan kvantalgoritmer och kvanthårdvara, vilket leder till större effektivitet till priset av att ha en mer komplex kompilator."

Medan teamets forskning kretsar kring att göra kompilatorprogramvaran medveten om den underliggande hårdvaran, det är agnostiskt för den specifika typen av underliggande hårdvara. Detta är viktigt eftersom det finns flera olika typer av kvantdatorer under utveckling, såsom de med supraledande qubits och fångade jon-qubits.

Teamet förväntar sig att se experimentella förverkliganden av deras tillvägagångssätt inom de kommande månaderna, särskilt nu när en öppen industristandard, OpenPulse, har definierats. Denna standard kommer att möjliggöra drift av kvantdatorer på lägsta möjliga nivå, efter behov för kvantoptimala kontrolltekniker. IBMs kvantfärdplan framhäver OpenPulse-stöd som ett nyckelmål för 2019, och andra företag förväntas också tillkännage liknande planer.

Teamets fullständiga papper, "Optimized Compilation of Aggregated Instructions for Realistic Quantum Computers" publiceras nu på arXiv och kommer att presenteras på ASPLOS datorarkitekturkonferens på Rhode Island den 17 april. Förutom Shi och Chong, medförfattare inkluderar Nelson Leung, Pranav Gokhale, Zane Rossi, David I. Schuster, och Henry Hoffman, allt vid University of Chicago.