Utvecklingen av en ny teori är vanligtvis förknippad med fysikens storheter. Du kanske tänker på Isaac Newton eller Albert Einstein, till exempel. Många Nobelpriser har redan delats ut för nya teorier.

Forskare vid Forschungszentrum Jülich har nu programmerat en artificiell intelligens som också bemästrat denna bedrift. Deras AI kan känna igen mönster i komplexa datamängder och formulera dem i en fysikalisk teori. Resultaten publiceras i tidskriften Physical Review X .

I följande intervju förklarar Prof. Moritz Helias från Forschungszentrum Jülichs Institute for Advanced Simulation (IAS-6) vad "Fysik av AI" handlar om och i vilken utsträckning den skiljer sig från konventionella metoder.

Man börjar vanligtvis med observationer av systemet innan man försöker föreslå hur de olika systemkomponenterna interagerar med varandra för att förklara det observerade beteendet. Nya förutsägelser härleds sedan från detta och sätts på prov.

Ett välkänt exempel är Isaac Newtons gravitationslag. Den beskriver inte bara gravitationskraften på jorden, utan den kan också användas för att förutsäga rörelser hos planeter, månar och kometer – såväl som banorna för moderna satelliter – ganska exakt.

Sättet på vilket sådana hypoteser uppnås skiljer sig dock alltid åt. Du kan börja med fysikens allmänna principer och grundläggande ekvationer och härleda hypotesen från dem, eller så kan du välja ett fenomenologiskt tillvägagångssätt som begränsar dig till att beskriva observationer så noggrant som möjligt utan att förklara deras orsaker. Svårigheten ligger i att välja ett bra tillvägagångssätt bland de många möjliga tillvägagångssätten, anpassa det vid behov och förenkla det.

I allmänhet innebär det ett tillvägagångssätt som kallas "fysik för maskininlärning." I vår arbetsgrupp använder vi fysikmetoder för att analysera och förstå den komplexa funktionen hos en AI.

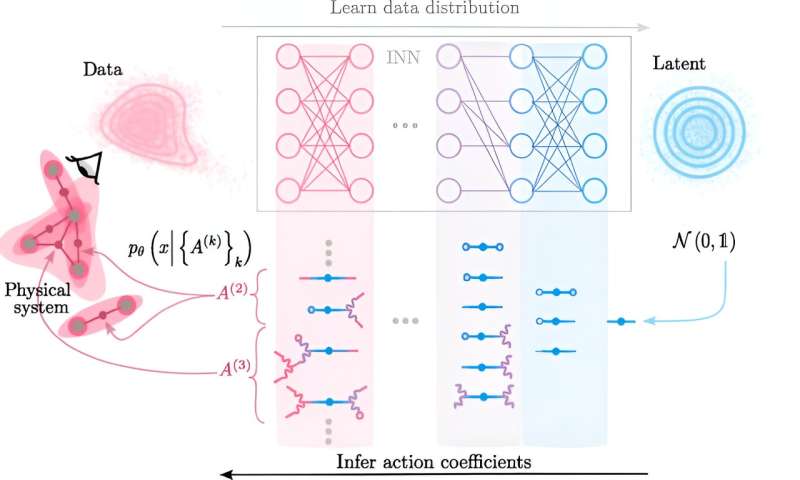

Den avgörande nya idén som utvecklades av Claudia Merger från vår forskargrupp var att först använda ett neuralt nätverk som lär sig att exakt kartlägga det observerade komplexa beteendet till ett enklare system. Med andra ord syftar AI till att förenkla alla komplexa interaktioner vi observerar mellan systemkomponenter. Vi använder sedan det förenklade systemet och skapar en omvänd mappning med den tränade AI:n. Återvänder vi från det förenklade systemet till det komplexa och utvecklar sedan den nya teorin.

På vägen tillbaka byggs de komplexa interaktionerna upp bit för bit från de förenklade. I slutändan är tillvägagångssättet därför inte så annorlunda än en fysiker, med skillnaden är att sättet på vilket interaktionerna är sammansatta nu läses från parametrarna för AI. Detta perspektiv på världen – som förklarar den från interaktioner mellan dess olika delar som följer vissa lagar – är grunden för fysiken, därav termen "AI:s fysik."

Vi använde till exempel en datamängd av svartvita bilder med handskrivna siffror, som ofta används i forskning när man arbetar med neurala nätverk. Som en del av sin doktorsavhandling undersökte Claudia Merger hur små understrukturer i bilderna, som kanterna på siffrorna, är uppbyggda av interaktioner mellan pixlar. Grupper av pixlar hittas som tenderar att bli ljusare tillsammans och därmed bidrar till formen på talets kant.

Användningen av AI är ett knep som gör beräkningarna möjliga i första hand. Du når mycket snabbt ett mycket stort antal möjliga interaktioner. Utan att använda detta trick kan du bara titta på mycket små system. Ändå är beräkningsansträngningen fortfarande hög, vilket beror på att det finns många möjliga interaktioner även i system med många komponenter.

Vi kan dock effektivt parametrisera dessa interaktioner så att vi nu kan se system med cirka 1 000 interagerande komponenter, det vill säga bildområden med upp till 1 000 pixlar. I framtiden bör även mycket större system vara möjliga genom ytterligare optimering.

Många AI:er strävar efter att lära sig en teori om vilken data som används för att träna AI. Men teorierna som AI:erna lär sig kan vanligtvis inte tolkas. Istället är de implicit dolda i parametrarna för den tränade AI:n. Däremot extraherar vårt tillvägagångssätt den inlärda teorin och formulerar den på språket för interaktioner mellan systemkomponenter, vilket ligger till grund för fysiken.

Den tillhör alltså området för förklarabar AI, närmare bestämt "AI:s fysik", eftersom vi använder fysikens språk för att förklara vad AI:n har lärt sig. Vi kan använda interaktionsspråket för att bygga en bro mellan AI:s komplexa inre funktion och teorier som människor kan förstå.

Mer information: Claudia Merger et al, Learning Interacting Theories from Data, Physical Review X (2023). DOI:10.1103/PhysRevX.13.041033

Tillhandahålls av Forschungszentrum Juelich