Kredit:Zimmer, Boniface, och Dutech.

Forskare vid University of Lorraine har nyligen utarbetat en ny typ av överföringsinlärning baserad på modellfri djup förstärkningsinlärning med kontinuerlig sensorimotorisk rymdförstoring. Deras tillvägagångssätt, presenteras i ett dokument som publicerades under den åttonde Joint IEEE International Conference on Development and Learning and on Epigenetic Robotics, och fritt tillgänglig på HAL arkiv-ouvertes, är inspirerad av barns utveckling, särskilt genom att det sensomotoriska utrymmet växer fram när ett barn skaffar sig användbara nya strategier.

"Det formella ramverket för förstärkningsinlärning kan användas för att modellera ett brett spektrum av problem, sa Matthieu Zimmer, en av forskarna som genomförde studien. "Inom denna ram, en agent använder en trial-and-error-metod för att långsamt lära sig vilken sekvens av åtgärder som är lämpligast för att nå ett önskat mål. Om vissa krav är uppfyllda, sedan säger teorin oss att vi har algoritmer som agenten kan använda för att hitta den optimala lösningen på problemet, men detta kan ta långa perioder. För att påskynda denna process, vi undersökte sätt för en agent att uppnå goda resultat i färre försök, även när den nästan inte har någon kunskap om uppgiften den måste lösa."

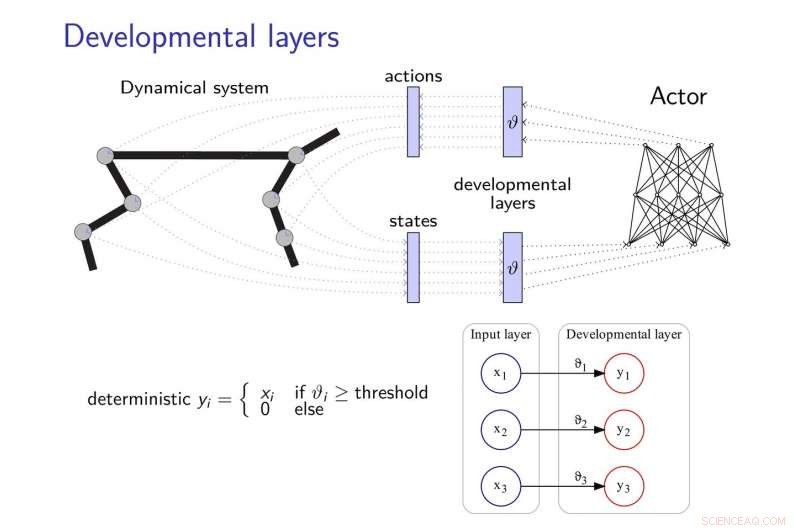

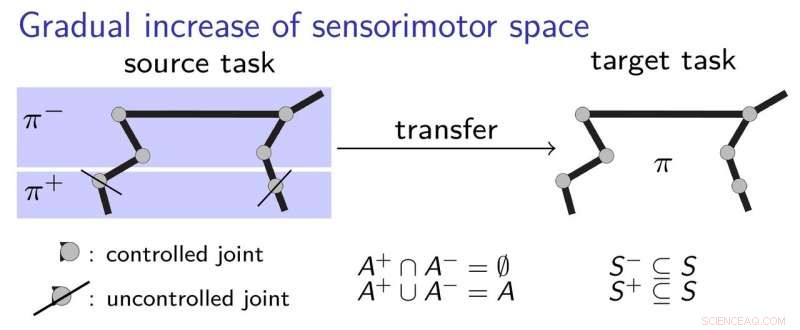

Den överföringsinlärningsmetod som föreslagits av Zimmer och hans kollegor lägger till utvecklingsskikt till neurala nätverk, låta dem utveckla nya strategier för att slutföra uppgifter, speciellt när dessa uppgifter på något sätt är relaterade. Dessa utvecklingslager avslöjar gradvis vissa dimensioner av det sensorimotoriska rummet, efter en inneboende motivationsheuristik.

För att mildra effekterna av "katastrofisk glömska, "en vanlig fråga i utvecklingen av neurala nätverk, forskarna hämtade inspiration från teorin om elastisk viktkonsolidering, använder den för att reglera inlärningen av den neurala styrenheten.

Kredit:Zimmer, Boniface, och Dutech.

"Grundtanken i vårt arbete är att agenten ska börja med mycket begränsade uppfattnings- och handlingsförmåga och sedan utveckla dessa på ett utvecklande sätt, inspirerad av hur ett barn lär sig, " sa Alain Dutech, en annan forskare som genomförde studien. "Urymmet där agenten söker efter en lösning minskar därmed, och denna lösning, om än till ett försämrat problem, kan hittas lättare. Sedan ökar vi agentens kapacitet, dra nytta av den tidigare lösningen."

För att bättre förklara hur deras överföringsinlärningsmetod fungerar, forskarna använder exemplet med ett barn som lär sig att ta en penna. Initialt, barnet kanske bara använder sin armbåge och axel, lära sig att röra pennan. Successivt, hon kanske väljer att börja använda handen och fingrarna, efter att ha förstått grunderna för hur man bäst får den första kontakten med pennan. Detta innebär en gradvis inlärningsprocess, där barnet förvärvar sensomotoriska strategier steg för steg, utan att behöva lära sig för många saker på en gång.

Forskarna validerade sin nya metod med hjälp av två toppmoderna algoritmer för djupinlärning, nämligen DDPG och NFAC, testad på Half-Cheetah och Humanoid, två högdimensionella miljöriktmärken. Deras resultat tyder på att att söka efter en suboptimal lösning i en delmängd av parameterutrymmet innan man överväger hela utrymmet är en användbar teknik för att starta inlärningsalgoritmer, uppnå bättre prestation med kortare träning.

"Inom det mycket aktiva och stimulerande området för djupförstärkt lärande, vi har visat att utvecklingsmetoder som våra, såväl som andra liknande som utforskats av andra forskare, skulle kunna kombineras med metoder för djupinlärning för att tillåta lärande från grunden, med lite förkunskaper, " sa Zimmer.

Trots dess lovande resultat, studien som utfördes av Zimmer och hans kollegor lyfte också fram den klyfta som fortfarande finns mellan förmågan hos djupa neurala nätverk och människor. Faktiskt, även när man använder utvecklingsförstärkande lärande, de flesta befintliga medel är fortfarande mycket mindre mångsidiga och effektiva än människor.

"Ibland, människor kan lära sig i bara ett försök, men även det mest effektiva artificiella lärandet kommer att kräva en komplex kombination av olika algoritmer för att lära sig, uppskatta, memorera, jämföra, och optimera, " sade Zimmer. "Dessutom, några av dessa algoritmer är fortfarande inte klart definierade."

Dutech och hans kollegor utforskar nu nya horisonter inom området AI och djupinlärning. Till exempel, de skulle vilja utveckla nya sätt för en lärande agent att korrekt kategorisera de stimuli den uppfattar.

"Lärande är mycket effektivare när agenten kan tolka vad som är "ser" eller "känner", " Dutech förklarade. "I dag, trenden är att använda djupinlärning och neurala nätverk för att göra detta. Vi undersöker nu andra metoder för att extrahera relevant och användbar information från den råa uppfattningen av artificiella medel, som är mindre beroende av att ha en enorm samling av exempel; såsom oövervakat lärande och självorganisering."

© 2018 Tech Xplore