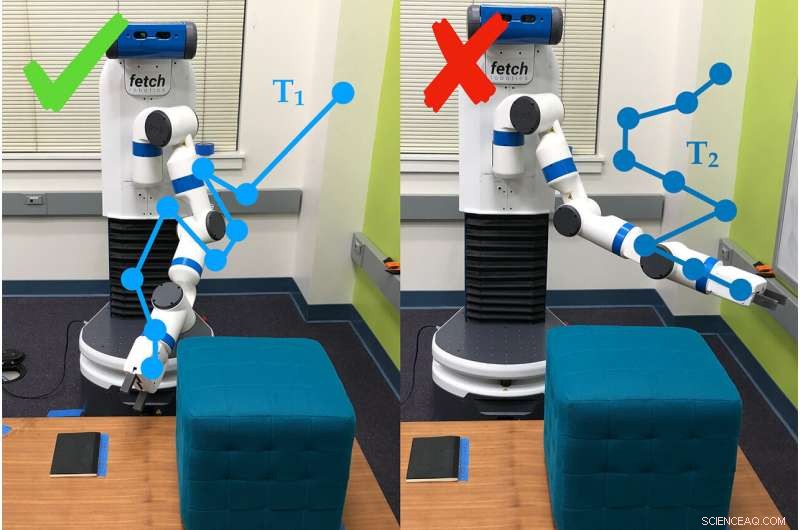

Ett exempel på hur robotarmen använder enkätfrågor för att fastställa preferenser för den person som använder den. I detta fall, personen föredrar bana #1 (T1) framför bana #2. Kredit:Andy Palan och Gleb Shevchuk

Tillsagd att optimera för hastighet när du kör nerför en bana i ett datorspel, en bil trycker på pedalen till metallen ... och fortsätter att snurra i en snäv liten cirkel. Ingenting i instruktionerna sa till bilen att köra rakt, och så improviserade det.

Det här exemplet – roligt i ett datorspel men inte så mycket i livet – är bland dem som motiverade forskare vid Stanford University att bygga ett bättre sätt att sätta upp mål för autonoma system.

Dorsa Sadigh, biträdande professor i datavetenskap och elektroteknik, och hennes labb har kombinerat två olika sätt att sätta mål för robotar i en enda process, som presterade bättre än någon av dess delar ensam i både simuleringar och verkliga experiment. Forskarna presenterade arbetet 24 juni på Robotik:Vetenskap och system konferens.

"I framtiden, Jag förväntar mig fullt ut att det kommer att finnas fler autonoma system i världen och de kommer att behöva ett begrepp om vad som är bra och vad som är dåligt, sa Andy Palan, doktorand i datavetenskap och medförfattare till uppsatsen. "Det är avgörande, om vi vill distribuera dessa autonoma system i framtiden, att vi får rätt."

Teamets nya system för att ge instruktion till robotar – så kallade belöningsfunktioner – kombinerar demonstrationer, där människor visar roboten vad den ska göra, och användarpreferensundersökningar, där människor svarar på frågor om hur de vill att roboten ska bete sig.

"Demonstrationer är informativa men de kan vara bullriga. Å andra sidan, preferenser ger, som mest, en bit information, men är mycket mer exakta, " sa Sadigh. "Vårt mål är att få det bästa av två världar, och kombinera data som kommer från båda dessa källor mer intelligent för att bättre lära dig om människors föredragna belöningsfunktion."

Demonstrationer och undersökningar

I tidigare arbeten, Sadigh hade fokuserat enbart på preferensundersökningar. Dessa ber människor att jämföra scenarier, till exempel två banor för en autonom bil. Denna metod är effektiv, men det kan ta så mycket som tre minuter att generera nästa fråga, vilket fortfarande är långsamt för att skapa instruktioner för komplexa system som en bil.

För att påskynda det, gruppen utvecklade senare ett sätt att skapa flera frågor samtidigt, som kunde besvaras i snabb följd av en person eller fördelas på flera personer. Denna uppdatering påskyndade processen 15 till 50 gånger jämfört med att skapa frågor en i taget.

Det nya kombinationssystemet börjar med att en person visar ett beteende för roboten. Det kan ge autonoma robotar mycket information, men roboten kämpar ofta för att avgöra vilka delar av demonstrationen som är viktiga. Människor vill inte heller alltid att en robot ska bete sig precis som människan som tränade den.

"Vi kan inte alltid ge demonstrationer, och även när vi kan, vi kan ofta inte lita på den information som människor ger, " sade Erdem Biyik, en doktorand i elektroteknik som ledde arbetet med att utveckla flerfrågeundersökningarna. "Till exempel, Tidigare studier har visat att människor vill att autonoma bilar ska köra mindre aggressivt än de själva gör."

Det är där undersökningarna kommer in, ger roboten ett sätt att fråga, till exempel, oavsett om användaren föredrar att flytta armen lågt till marken eller upp mot taket. För denna studie, gruppen använde den långsammare enfrågemetoden, men de planerar att integrera undersökningar med flera frågor i senare arbete.

I tester, teamet fann att det gick snabbare att kombinera demonstrationer och undersökningar än att bara ange inställningar och, jämfört med enbart demonstrationer, cirka 80 procent av människorna föredrog hur roboten betedde sig när de tränades med det kombinerade systemet.

"Detta är ett steg för att bättre förstå vad människor vill ha eller förväntar sig av en robot, ", sa Sadigh. "Vårt arbete gör det enklare och mer effektivt för människor att interagera och lära ut robotar, och jag är glad över att ta det här arbetet vidare, särskilt i att studera hur robotar och människor kan lära av varandra."

Bättre, snabbare, smartare

Personer som använde den kombinerade metoden rapporterade svårigheter att förstå vad systemet menade med några av sina frågor, som ibland bad dem att välja mellan två scenarier som verkade lika eller verkade irrelevanta för uppgiften – ett vanligt problem i preferensbaserat lärande. Forskarna hoppas kunna åtgärda denna brist med enklare undersökningar som också fungerar snabbare.

"När man ser på framtiden, det är inte 100 procent uppenbart för mig vad det rätta sättet att skapa belöningsfunktioner är, men realistiskt sett kommer du att ha någon sorts kombination som kan hantera komplexa situationer med mänsklig input, " sa Palan. "Att kunna designa belöningsfunktioner för autonoma system är en stor, viktigt problem som inte har fått den uppmärksamhet i akademin som det förtjänar."

Teamet är också intresserade av en variant av deras system, som skulle tillåta människor att samtidigt skapa belöningsfunktioner för olika scenarier. Till exempel, en person kanske vill att deras bil ska köra mer konservativt i långsam trafik och mer aggressivt när trafiken är lätt.

När demos misslyckas

Ibland lyckas inte bara demonstrationer förmedla poängen med en uppgift. Till exempel, en demonstration i denna studie fick människor att lära robotarmen att röra sig tills den pekade på en specifik plats på marken, och att göra det samtidigt som man undviker ett hinder och utan att röra sig över en viss höjd.

Efter att en människa kört roboten i dess takt i 30 minuter, roboten försökte utföra uppgiften självständigt. Det pekade helt enkelt rakt upp. Det var så fokuserat på att lära sig att inte träffa hindret, den missade helt det faktiska målet med uppgiften – att peka på platsen – och preferensen för att hålla sig låg.

Handkodning och belöningshackning

Ett annat sätt att lära en robot är att skriva kod som fungerar som instruktioner. Utmaningen är att förklara exakt vad du vill att en robot ska göra, speciellt om uppgiften är komplex. Ett vanligt problem är känt som "reward hacking, " där roboten kommer på ett enklare sätt att nå de angivna målen - som att bilen snurrar i cirklar för att nå målet att gå fort.

Biyik upplevde belöningshackning när han programmerade en robotarm att greppa en cylinder och hålla den i luften.

"Jag sa att handen måste vara stängd, objektet måste ha höjd högre än X och handen ska vara på samma höjd, " beskrev Biyik. "Roboten rullade cylinderobjektet till kanten av bordet, slog den uppåt och gjorde sedan en knytnäve bredvid den i luften."