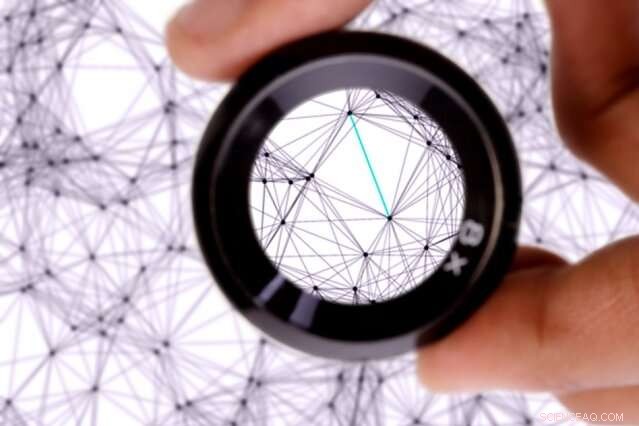

Forskare från MIT och Qatar Computing Research Institute (QCRI) sätter maskininlärningssystem som kallas neurala nätverk under mikroskopet. Kredit:MIT News

Forskare från MIT och Qatar Computing Research Institute (QCRI) sätter maskininlärningssystem som kallas neurala nätverk under mikroskopet.

I en studie som belyser hur dessa system lyckas översätta text från ett språk till ett annat, forskarna utvecklade en metod som pekar ut individuella noder, eller "neuroner, " i nätverken som fångar specifika språkliga egenskaper.

Neurala nätverk lär sig att utföra beräkningsuppgifter genom att bearbeta enorma uppsättningar träningsdata. I maskinöversättning, ett nätverk krossar språkdata som kommenteras av människor, och förmodligen "lär sig" språkliga egenskaper, som ordmorfologi, meningsstruktur, och ordets betydelse. Med tanke på ny text, dessa nätverk matchar dessa inlärda funktioner från ett språk till ett annat, och producera en översättning.

Men, i träning, dessa nätverk justerar i princip interna inställningar och värden på sätt som skaparna inte kan tolka. För maskinöversättning, det betyder att skaparna inte nödvändigtvis vet vilka språkliga egenskaper nätverket fångar.

I ett papper som presenteras vid denna veckas konferens Association for the Advancement of Artificial Intelligence, forskarna beskriver en metod som identifierar vilka neuroner som är mest aktiva vid klassificering av specifika språkliga egenskaper. De designade också en verktygslåda för användare att analysera och manipulera hur deras nätverk översätter text för olika ändamål, som att kompensera för eventuella klassificeringsfördomar i träningsdata.

I deras tidning, forskarna pekar ut neuroner som används för att klassificera, till exempel, könsbundna ord, dåtid och nutid, siffror i början eller mitten av meningar, och plural och singular ord. De visar också hur vissa av dessa uppgifter kräver många neuroner, medan andra bara kräver en eller två.

"Vår forskning syftar till att titta inuti neurala nätverk efter språk och se vilken information de lär sig, " säger medförfattaren Yonatan Belinkov, en postdoc vid Datavetenskap och Artificiell Intelligens Laboratory (CSAIL). "Detta arbete handlar om att få en mer finkornig förståelse av neurala nätverk och ha bättre kontroll över hur dessa modeller beter sig."

Medförfattare på uppsatsen är:seniorforskaren James Glass och doktorand Anthony Bau, av CSAIL; och Hassan Sajjad, Nadir Durrani, och Fahim Dalvi, av QCRI.

Att sätta ett mikroskop på neuroner

Neurala nätverk är strukturerade i lager, där varje lager består av många bearbetningsnoder, var och en ansluten till noder i lager över och under. Data bearbetas först i det lägsta lagret, som skickar en utdata till ovanstående lager, och så vidare. Varje utdata har olika "vikt" för att avgöra hur mycket den räknas in i nästa lagers beräkning. Under träning, dessa vikter justeras ständigt.

Neurala nätverk som används för maskinöversättning tränar på kommenterade språkdata. I träning, varje lager lär sig olika "ordinbäddningar" för ett ord. Ordinbäddningar är i huvudsak tabeller med flera hundra tal kombinerade på ett sätt som motsvarar ett ord och det ordets funktion i en mening. Varje nummer i inbäddningen beräknas av en enda neuron.

I sitt tidigare arbete, forskarna tränade en modell för att analysera de viktade resultaten från varje lager för att avgöra hur lagren klassificerade en given inbäddning. De fann att lägre skikt klassificerade relativt enklare språkliga särdrag - såsom strukturen för ett visst ord - och högre nivåer hjälpte till att klassificera mer komplexa drag, till exempel hur orden kombineras för att bilda mening.

I deras nya arbete, forskarna använder detta tillvägagångssätt för att avgöra hur inlärda ordinbäddningar gör en språklig klassificering. Men de implementerade också en ny teknik, kallad "språklig korrelationsanalys, " som tränar en modell att komma in på de individuella nervcellerna i varje ordinbäddning som var viktigast i klassificeringen.

Den nya tekniken kombinerar alla inbäddningar som fångats från olika lager – som var och en innehåller information om ordets slutliga klassificering – till en enda inbäddning. När nätverket klassificerar ett givet ord, modellen lär sig vikter för varje neuron som aktiverades under varje klassificeringsprocess. Detta ger en vikt till varje neuron i varje ordinbäddning som avfyrades för en specifik del av klassificeringen.

"Tanken är, om denna neuron är viktig, det borde finnas en hög vikt som man lär sig, "Belinkov säger. "Neuronerna med hög vikt är de som är viktigare för att förutsäga den vissa språkliga egenskapen. Du kan tänka på neuronerna som många rattar du behöver vrida på för att få rätt kombination av siffror i inbäddningen. Vissa rattar är viktigare än andra, så tekniken är ett sätt att tilldela dessa rattar betydelse."

Neuronablation, modellmanipulation

Eftersom varje neuron är viktad, den kan rangordnas efter betydelse. För detta ändamål, forskarna designade en verktygslåda, kallas NeuroX, som automatiskt rangordnar alla neuroner i ett neuralt nätverk efter deras betydelse och visualiserar dem i ett webbgränssnitt.

Användare laddar upp ett nätverk som de redan har tränat, samt ny text. Appen visar texten och, bredvid den, en lista över specifika neuroner, var och en med ett identifikationsnummer. När en användare klickar på en neuron, texten kommer att markeras beroende på vilka ord och fraser neuronen aktiveras för. Därifrån, användare kan helt slå ut - eller "ablatera" - neuronerna, eller ändra omfattningen av deras aktivering, för att kontrollera hur nätverket översätts.

Uppgiften med ablation användes för att avgöra om forskarnas metod exakt pekade ut de korrekta högt uppsatta neuronerna. I deras tidning, forskarna använde verktyget för att visa att, genom att ablatera högt rankade neuroner i ett nätverk, dess prestation i att klassificera korrelerade språkliga egenskaper sjönk avsevärt. Alternativt när de ablerade lägre rankade neuroner, prestation lidit, men inte lika dramatiskt.

"När du har fått alla dessa rankningar, du vill se vad som händer när du dödar dessa neuroner och se hur illa det påverkar prestandan, " säger Belinkov. "Det är ett viktigt resultat som bevisar att nervcellerna vi hittar är, faktiskt, viktigt för klassificeringsprocessen."

En intressant applikation för verktygslådan är att hjälpa till att begränsa fördomar i språkdata. Maskinöversättningsmodeller, som Google Translate, kan träna på data med könsbias, vilket kan vara problematiskt för språk med könsbestämda ord. Vissa yrken, till exempel, kan oftare kallas manlig, och andra som kvinnor. När ett nätverk översätter ny text, det kanske bara producerar det inlärda könet för dessa ord. I många online översättningar från engelska till spanska, till exempel, "läkare" översätts ofta till sin maskulina version, medan "sköterska" översätts till sin feminina version.

"Men vi finner att vi kan spåra individuella neuroner som ansvarar för språkliga egenskaper som kön, " säger Belinkov. "Om du kan spåra dem, kanske du kan ingripa på något sätt och påverka översättningen för att översätta dessa ord mer till det motsatta könet ... för att ta bort eller mildra partiskheten."

I preliminära experiment, forskarna modifierade nervceller i ett nätverk för att ändra översatt text från dåtid till nutid med 67 procents noggrannhet. De avbröt för att byta kön på orden med 21 procents noggrannhet. "Det är fortfarande ett arbete som pågår, " säger Belinkov. Ett nästa steg, han lägger till, finjusterar webbapplikationen för att uppnå mer exakt ablation och manipulation.

Den här historien återpubliceras med tillstånd av MIT News (web.mit.edu/newsoffice/), en populär webbplats som täcker nyheter om MIT-forskning, innovation och undervisning.