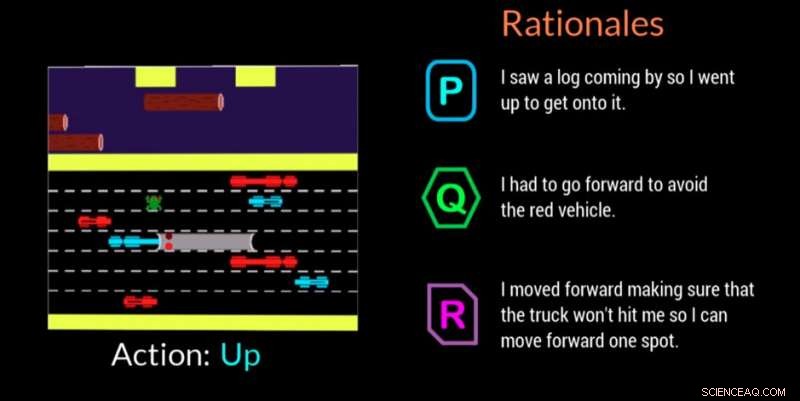

En AI-agent ger sin motivering för att fatta ett beslut i detta videospel. Kredit:Georgia Tech

Georgia Institute of Technology forskare, i samarbete med Cornell University och University of Kentucky, har utvecklat en artificiellt intelligent (AI) agent som automatiskt kan generera naturliga språkförklaringar i realtid för att förmedla motiven bakom dess handlingar. Arbetet är utformat för att ge människor som engagerar sig med AI-agenter eller robotar förtroende för att agenten utför uppgiften korrekt och kan förklara ett misstag eller felaktigt beteende.

Agenten använder också vardagsspråk som icke-experter kan förstå. Förklaringarna, eller "rationaler" som forskarna kallar dem, är designade för att vara relaterbara och inspirera dem som kan vara på arbetsplatsen med AI-maskiner eller interagera med dem i sociala situationer.

"Om kraften hos AI ska demokratiseras, det måste vara tillgängligt för alla oavsett tekniska förmågor, sa Upol Ehsan, Ph.D. student vid School of Interactive Computing vid Georgia Tech och ledande forskare.

"När AI genomsyrar alla aspekter av våra liv, det finns ett tydligt behov av människocentrerad AI-design som gör blackboxade AI-system lättförklarliga för vardagliga användare. Vårt arbete tar ett formativt steg mot att förstå rollen av språkbaserade förklaringar och hur människor uppfattar dem."

Studien stöddes av Office of Naval Research (ONR).

Forskare utvecklade en deltagarestudie för att avgöra om deras AI-agent kunde erbjuda skäl som efterliknade mänskliga svar. Åskådare såg AI-agenten spela videospelet Frogger och rankade sedan tre motiveringar på skärmen i ordning efter hur väl var och en beskrev AI:s spelrörelse.

Av de tre anonymiserade motiveringarna för varje drag - ett mänskligt genererat svar, AI-agentens svar, och ett slumpmässigt genererat svar – deltagarna föredrog de mänskligt genererade skälen först, men de AI-genererade svaren var en nära andra.

Frogger erbjöd forskarna chansen att träna en AI i en "sekventiell beslutsfattande miljö, " vilket är en betydande forskningsutmaning eftersom beslut som agenten redan har fattat påverkar framtida beslut. Därför, att förklara resonemangskedjan för experter är svårt, och ännu mer när du kommunicerar med icke-experter, enligt forskare.

De mänskliga åskådarna förstod målet med Frogger att få grodan säkert hem utan att bli påkörd av rörliga fordon eller drunkna i floden. Den enkla spelmekaniken för att flytta upp, ner, vänster eller höger, lät deltagarna se vad AI gjorde, och för att utvärdera om motiven på skärmen tydligt motiverade flytten.

Åskådarna bedömde motiveringen utifrån:

AI-genererade skäl som rankades högre av deltagarna var de som visade erkännande av miljöförhållanden och anpassningsförmåga, såväl som de som kommunicerade medvetenhet om kommande faror och planerade för dem. Överflödig information som bara angav det uppenbara eller felkaraktäriserade miljön visade sig ha en negativ inverkan.

"Detta projekt handlar mer om att förstå mänskliga uppfattningar och preferenser för dessa AI-system än om att bygga ny teknik, " sade Ehsan. "I hjärtat av förklarabarhet är förnuftsskapande. Vi försöker förstå den mänskliga faktorn."

En andra relaterad studie validerade forskarnas beslut att designa sin AI-agent för att kunna erbjuda en av två distinkta typer av skäl:

I denna andra studie, deltagarna erbjöds bara AI-genererade motiveringar efter att ha sett AI spela Frogger. De ombads välja det svar som de föredrog i ett scenario där en AI gjorde ett misstag eller betedde sig oväntat. De visste inte att skälen var grupperade i de två kategorierna.

Med 3-till-1 marginal, deltagarna gynnade svar som klassificerades i kategorin "komplett bild". Svaren visade att människor uppskattade att AI tänker på framtida steg snarare än bara vad som var i ögonblicket, vilket kan göra dem mer benägna att göra ett nytt misstag. Människor ville också veta mer så att de direkt kunde hjälpa AI:n att fixa det felaktiga beteendet.

"Den situerade förståelsen för uppfattningarna och preferenserna hos människor som arbetar med AI-maskiner ger oss en kraftfull uppsättning handlingsbara insikter som kan hjälpa oss att designa bättre människocentrerad, förnuftsgenererande, autonoma agenter, sa Mark Riedl, professor i interaktiv datoranvändning och ledande fakultetsmedlem i projektet.

En möjlig framtida riktning för forskningen kommer att tillämpa resultaten på autonoma agenter av olika typer, såsom följeslagare, och hur de kan reagera baserat på den aktuella uppgiften. Forskare kommer också att titta på hur agenter kan reagera i olika scenarier, till exempel under en nödsituation eller när du hjälper lärare i klassrummet.

Forskningen presenterades i mars på Association for Computing Machinery's Intelligent User Interfaces 2019 Conference. Uppsatsen har titeln "Automated Rationale Generation:A Technique for Explainable AI and its Effects on Human Perceptions." Ehsan kommer att presentera ett positionsdokument som belyser design- och utvärderingsutmaningarna för människocentrerade Explainable AI-system vid den kommande workshopen Emerging Perspectives in Human-Centered Machine Learning på ACM CHI 2019-konferensen, 4-9 maj, i Glasgow, Skottland.