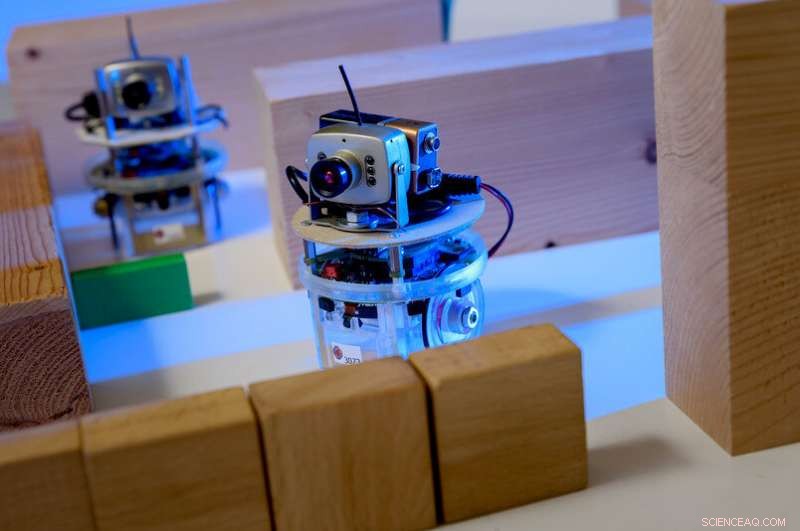

Exempel på en lärande agent i ett datorspel:karaktären styrs av en mänsklig spelare. Ögonen är agenterna. Spelaren är tänkt att vägleda agenterna på ett sådant sätt att de utför en uppgift, till exempel utan att stöta på ett hinder först. Utbildning är baserad på en maskininlärningsprocess; allt spelaren gör är att beskriva grova krav. Kredit:RUB, Institut für Neuroinformatik

Processerna som ligger bakom artificiell intelligens idag är faktiskt ganska dumma. Forskare från Bochum försöker göra dem smartare.

Radikal förändring, rotation, megatrend, kanske till och med en risk:artificiell intelligens har trängt igenom alla industrisegment och håller media sysselsatta. Forskare vid RUB Institute for Neural Computation har studerat det i 25 år. Deras vägledande princip är:för att maskiner ska vara riktigt intelligenta, nya tillvägagångssätt måste först göra maskininlärning mer effektiv och flexibel.

"Det finns två typer av maskininlärning som är framgångsrika idag:djupa neurala nätverk, även känd som Deep Learning, samt förstärkningsinlärning, " förklarar professor Laurenz Wiskott, Ordförande för teori om neuronala system.

Neurala nätverk är kapabla att fatta komplexa beslut. De används ofta i bildigenkänningsapplikationer. "Dom kan, till exempel, berätta från bilder om motivet är en man eller en kvinna, säger Wiskott.

Arkitekturen för sådana nätverk är inspirerad av nätverk av nervceller, eller neuroner, i vår hjärna. Neuroner tar emot signaler via flera ingångskanaler och bestämmer sedan om de skickar signalen i form av en elektrisk puls till nästa neuroner eller inte.

Neurala nätverk tar likaså emot flera insignaler, till exempel pixlar. I ett första steg, många artificiella neuroner beräknar en utsignal från flera insignaler genom att helt enkelt multiplicera insignalerna med olika men konstanta vikter och sedan lägga ihop dem. Var och en av dessa aritmetiska operationer resulterar i ett värde som – för att hålla fast vid exemplet man/kvinna – bidrar lite till beslutet om kvinna eller man. "Resultatet är något förändrat, dock, genom att sätta negativa resultat till noll. Detta, för, kopieras från nervceller och är avgörande för prestanda hos neurala nätverk, " förklarar Laurenz Wiskott.

Samma sak händer igen i nästa lager, tills nätverket kommer fram till ett beslut i slutskedet. Ju fler steg det finns i processen, desto kraftfullare är det – neurala nätverk med mer än 100 stadier är inte ovanliga. Neurala nätverk löser ofta diskrimineringsuppgifter bättre än människor.

Inlärningseffekten av sådana nätverk baseras på valet av rätt viktningsfaktorer, som till en början väljs slumpmässigt. "För att träna ett sådant nätverk, ingångssignalerna samt vad det slutliga beslutet ska vara specificeras från början, ", utarbetar Laurenz Wiskott. Alltså, nätverket kan successivt justera viktningsfaktorerna för att slutligen fatta rätt beslut med största sannolikhet.

Förstärkningsinlärning, å andra sidan, är inspirerad av psykologi. Här, varje beslut som fattas av algoritmen – experter kallar den agenten – antingen belönas eller straffas. "Föreställ dig ett rutnät med agenten i mitten, " illustrerar Laurenz Wiskott. "Dess mål är att nå den övre vänstra rutan på kortast möjliga väg – men det vet den inte." Det enda agenten vill är att få så många belöningar som möjligt, annars är det ingen aning. I början, det kommer att röra sig över linjen slumpmässigt, och varje steg som inte når målet kommer att straffas. Endast steget mot målet resulterar i en belöning.

Vilken väg ska roboten ta? Detta beslut är baserat på otaliga aritmetiska operationer. Kredit:Roberto Schirdewahn

För att lära sig, agenten tilldelar ett värde till varje fält som anger hur många steg som är kvar från den positionen till dess mål. Initialt, dessa värden är slumpmässiga. Ju mer erfarenhet agenten får i sin styrelse, desto bättre kan den anpassa dessa värden till verkliga förhållanden. Efter många körningar, den kan hitta den snabbaste vägen till sitt mål och, följaktligen, till belöningen.

"Problemet med dessa maskininlärningsprocesser är att de är ganska dumma, " säger Laurenz Wiskott. "De underliggande teknikerna går tillbaka till 1980-talet. Den enda anledningen till deras nuvarande framgång är att vi idag har mer datorkapacitet och mer data till vårt förfogande." På grund av detta, det är möjligt att snabbt köra de praktiskt taget ineffektiva inlärningsprocesserna otaliga gånger och mata neurala nätverk med en uppsjö av bilder och bildbeskrivningar för att träna dem.

"Vad vi vill veta är:hur kan vi undvika så länge, meningslös träning? Och framför allt:hur kan vi göra maskininlärning mer flexibel?" som Wiskott kortfattat uttrycker det. Artificiell intelligens kan vara överlägsen människor i exakt den uppgift som den utbildats för, men den kan inte generalisera eller överföra sin kunskap till relaterade uppgifter.

Det är därför som forskarna vid Institute for Neural Computation fokuserar på nya strategier som hjälper maskiner att upptäcka strukturer autonomt. "För detta ändamål, vi använder principen om oövervakat lärande, " säger Laurenz Wiskott. Medan djupa neurala nätverk och förstärkningsinlärning bygger på att presentera det önskade resultatet eller belöna eller bestraffa varje steg, forskarna lämnar inlärningsalgoritmer i stort sett ensamma med sina input.

"En uppgift kan vara till exempel, att bilda kluster, " förklarar Wiskott. För detta ändamål, datorn instrueras att gruppera liknande data. När det gäller punkter i ett tredimensionellt utrymme, detta skulle innebära att gruppera punkter vars koordinater ligger nära varandra. Om avståndet mellan koordinaterna är större, de skulle fördelas på olika grupper.

"Om vi går tillbaka till exemplet med bilder av människor, man skulle kunna titta på resultatet efter grupperingen och skulle förmodligen finna att datorn har satt ihop en grupp med bilder på män och en grupp med bilder på kvinnor, ", utarbetar Laurenz Wiskott. "En stor fördel är att allt som krävs i början är foton, snarare än en bildtext som innehåller lösningen på gåtan i träningssyfte, som det var."

Långsamhetsprincipen

Dessutom, denna metod ger mer flexibilitet, eftersom sådan klusterbildning inte bara är tillämplig för bilder av människor, men även för bilar, växter, hus eller andra föremål.

Ett annat tillvägagångssätt som Wiskott följer är långsamhetsprincipen. Här, det är inte foton som utgör insignalen, men rörliga bilder:om alla funktioner extraheras från en video som förändras mycket långsamt, strukturer uppstår som hjälper till att bygga upp en abstrakt representation av miljön. "Här, för, poängen är att förstrukturera indata, " påpekar Laurenz Wiskott. Så småningom, forskarna kombinerar sådana tillvägagångssätt på ett modulärt sätt med metoderna för övervakat lärande, för att skapa mer flexibla applikationer som ändå är mycket exakta.

"Ökad flexibilitet resulterar naturligtvis i prestationsförlust, " medger forskaren. Men i det långa loppet, flexibilitet är oumbärlig om vi vill utveckla robotar som kan hantera nya situationer."