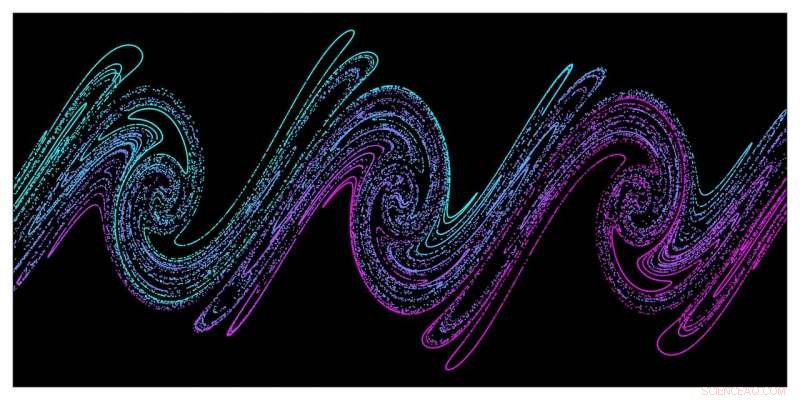

Storskaliga simuleringar visar att kaos är ansvarigt för stokastisk uppvärmning av tät plasma med intensiv laserenergi. Den här bilden visar en ögonblicksbild av elektronfördelningsfasrymden (position/momentum) från den täta plasman taget från PIC-simuleringar, illustrerar den så kallade "stretching and folding"-mekanismen som är ansvarig för uppkomsten av kaos i fysiska system. Kredit:G. Blaclard, CEA Saclay

Ett nytt simuleringsverktyg för 3D-partikel-i-cell (PIC) utvecklat av forskare från Lawrence Berkeley National Laboratory och CEA Saclay möjliggör banbrytande simuleringar av laser/plasma-kopplingsmekanismer som tidigare var utom räckhåll för standard PIC-koder som används i plasmaforskning. Mer detaljerad förståelse av dessa mekanismer är avgörande för utvecklingen av ultrakompakta partikelacceleratorer och ljuskällor som skulle kunna lösa långvariga utmaningar inom medicin, industri, och grundläggande vetenskap mer effektivt och kostnadseffektivt.

I laserplasmaexperiment som de vid Berkeley Lab Laser Accelerator (BELLA) Center och vid CEA Saclay – en internationell forskningsanläggning i Frankrike som är en del av den franska atomenergikommissionen – mycket stora elektriska fält i plasma som accelererar partikelstrålar till hög energi över mycket kortare avstånd jämfört med befintlig acceleratorteknik. Det långsiktiga målet för dessa laserplasmaacceleratorer (LPA) är att en dag bygga kolliderar för högenergiforskning, men många spin-offs utvecklas redan. Till exempel, LPA:er kan snabbt deponera stora mängder energi i fasta material, skapa täta plasma och utsätta detta ämne för extrema temperaturer och tryck. De har också potentialen att driva frielektronlasrar som genererar ljuspulser som bara varar i attosekunder. Sådana extremt korta pulser kan göra det möjligt för forskare att observera interaktioner mellan molekyler, atomer, och även subatomära partiklar på extremt korta tidsskalor.

Superdatorsimuleringar har blivit allt mer kritiska för denna forskning, och Berkeley Labs National Energy Research Scientific Computing Center (NERSC) har blivit en viktig resurs i detta arbete. Genom att ge forskare tillgång till fysiska observerbara föremål som partikelbanor och utstrålade fält som är svåra att få tag på i experiment på extremt små tids- och längdskalor, PIC-simuleringar har spelat en stor roll för att förstå, modellering, och vägleda högintensiva fysikexperiment. Men en brist på PIC-koder som har tillräckligt med beräkningsnoggrannhet för att modellera laser-materia-interaktion vid ultrahöga intensiteter har hindrat utvecklingen av nya partikel- och ljuskällor som produceras av denna interaktion.

Denna utmaning ledde till att Berkeley Lab/CEA Saclay-teamet utvecklade sitt nya simuleringsverktyg, dubbad Warp+PXR, ett försök startade under den första omgången av NERSC Exascale Science Applications Program (NESAP). Koden kombinerar den mycket använda 3-D PIC-koden Warp med det högpresterande biblioteket PICSAR som utvecklats tillsammans av Berkeley Lab och CEA Saclay. Den utnyttjar också en ny typ av massivt parallella pseudospektrala lösare som utvecklats tillsammans av Berkeley Lab och CEA Saclay som dramatiskt förbättrar simuleringarnas noggrannhet jämfört med de lösare som vanligtvis används i plasmaforskning.

Faktiskt, utan detta nya, mycket skalbar lösare, "simuleringarna vi nu gör skulle inte vara möjliga, sade Jean-Luc Vay, en senior fysiker vid Berkeley Lab som leder Accelerator Modeling Program i laboratoriets Applied Physics and Accelerator Technologies Division. "Som vårt team visade i en tidigare studie, denna nya FFT-spektrallösare möjliggör mycket högre precision än vad som kan göras med finita differenstidsdomänlösare (FDTD), så vi kunde nå några parameterutrymmen som inte skulle ha varit tillgängliga med vanliga FDTD-lösare." Denna nya typ av spektrallösare är också kärnan i nästa generations PIC-algoritm med adaptiv mesh-förfining som Vay och kollegor utvecklar i den nya Warp-X-koden som en del av det amerikanska energidepartementets Exascale Computing Project.

2D- och 3D-simuleringar båda kritiska

Vay är också medförfattare till en tidning som publicerades 21 mars i Fysisk granskning X som rapporterar om den första omfattande studien av laser-plasma-kopplingsmekanismerna med Warp+PXR. Den studien kombinerade state-of-the-art experimentella mätningar utförda på UHI100-laseranläggningen vid CEA Saclay med banbrytande 2D- och 3D-simuleringar som kördes på Cori-superdatorn vid NERSC och Mira- och Theta-systemen vid Argonne Leadership Computing Facility vid Argonne National Laboratory. Dessa simuleringar gjorde det möjligt för teamet att bättre förstå kopplingsmekanismerna mellan det ultraintensiva laserljuset och den täta plasman som det skapade, ger nya insikter om hur man optimerar ultrakompakta partikel- och ljuskällor. Benchmarks med Warp+PXR visade att koden är skalbar på upp till 400, 000 kärnor på Cori och 800, 000 kärnor på Mira och kan påskynda tiden till lösning med så mycket som tre storleksordningar på problem relaterade till ultrahögintensiva fysikexperiment.

"Vi kan inte konsekvent upprepa eller reproducera vad som hände i experimentet med 2-D-simuleringar - vi behöver 3-D för detta, sa medförfattaren Henri Vincenti, en vetenskapsman i högintensiv fysikgrupp vid CEA Saclay. Vincenti ledde det teoretiska/simuleringsarbetet för den nya studien och var Marie Curie-postdoktor vid Berkeley Lab i Vays grupp, där han först började arbeta med den nya koden och lösaren. "3D-simuleringarna var också väldigt viktiga för att kunna jämföra noggrannheten med den nya koden mot experiment."

För experimentet som beskrivs i Fysisk granskning X papper, CEA Saclay-forskarna använde en femtosekundlaserstråle med hög effekt (100TW) vid CEA:s UHI100-anläggning fokuserad på ett kiseldioxidmål för att skapa en tät plasma. Dessutom, två diagnostik - en Lanex scintillerande skärm och en extrem ultraviolett spektrometer - användes för att studera laser-plasma-interaktionen under experimentet. De diagnostiska verktygen gav ytterligare utmaningar när det gällde att studera tids- och längdskalor medan experimentet pågick, återigen gör simuleringarna avgörande för forskarnas resultat.

"I den här typen av experiment kan du ofta inte komma åt tids- och längdskalorna som är involverade, speciellt för att du i experimenten har ett mycket intensivt laserfält på ditt mål, så du kan inte placera någon diagnostik nära målet, sa Fabien Quéré, en forskare som leder det experimentella programmet vid CEA och är medförfattare till PRX-uppsatsen. "I den här typen av experiment tittar vi på saker som sänds ut av målet som är långt borta - 10, 20 cm – och händer i realtid, väsentligen, medan fysiken är på mikron eller submikron skala och subfemtosecond skala i tid. Så vi behöver simuleringarna för att dechiffrera vad som händer i experimentet."

"De första principsimuleringarna vi använde för denna forskning gav oss tillgång till den komplexa dynamiken i laserfältsinteraktionen, med det fasta målet på detaljnivån för enskilda partikelbanor, så att vi bättre kan förstå vad som hände i experimentet, " tillade Vincenti.

Dessa mycket stora simuleringar med en spektral FFT-lösare med ultrahög precision var möjliga tack vare ett paradigmskifte som introducerades 2013 av Vay och medarbetare. I en studie publicerad i Journal of Computational Physics, de observerade att, när man löser de tidsberoende Maxwells ekvationer, standardmetoden för FFT-parallellisering (som är global och kräver kommunikation mellan processorer över hela simuleringsdomänen) skulle kunna ersättas med en domännedbrytning med lokala FFT och kommunikation begränsad till angränsande processorer. Förutom att möjliggöra mycket mer fördelaktig stark och svag skalning över ett stort antal datornoder, den nya metoden är också mer energieffektiv eftersom den minskar kommunikationen.

"Med standard FFT-algoritmer behöver du kommunicera över hela maskinen, " Sa Vay. "Men den nya spektrala FFT-lösaren möjliggör besparingar i både datortid och energi, vilket är en stor sak för de nya superdatorarkitekturerna som introduceras."