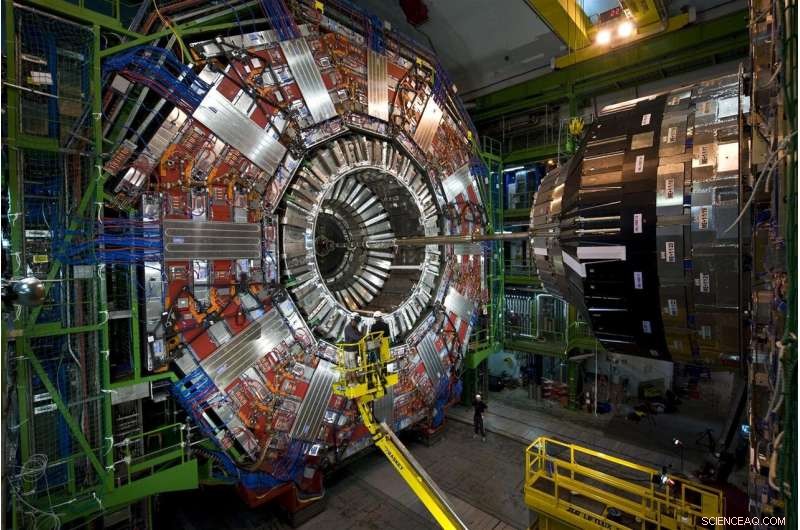

Partiklar som kommer fram från protonkollisioner vid CERN:s Large Hadron Collider färdas genom denna historia höga, instrument i många lager, CMS-detektorn. År 2026, LHC kommer att producera 20 gånger den data den gör för närvarande, och CMS genomgår för närvarande uppgraderingar för att läsa och bearbeta datafloden. Kredit:Maximilien Brice, CERN

Varje protonkollision vid Large Hadron Collider är annorlunda, men bara ett fåtal är speciella. De speciella kollisionerna genererar partiklar i ovanliga mönster – möjliga manifestationer av nya, regelbrytande fysik – eller hjälpa till att fylla i vår ofullständiga bild av universum.

Att hitta dessa kollisioner är svårare än att leta efter nålen i höstacken. Men spelomvandlingshjälp är på väg. Forskare från Fermilab och andra samarbetspartners testade framgångsrikt en prototyp för maskininlärning som snabbar upp bearbetningen med 30 till 175 gånger jämfört med traditionella metoder.

Konfronterar 40 miljoner kollisioner varje sekund, forskare vid LHC använder kraftfulla, smidiga datorer för att plocka ädelstenar – oavsett om det är en Higgspartikel eller antydningar av mörk materia – från den enorma statiken av vanliga kollisioner.

Rifling genom simulerade LHC-kollisionsdata, maskininlärningstekniken lärde sig framgångsrikt att identifiera ett visst postkollisionsmönster – en speciell spray av partiklar som flög genom en detektor – när den bläddrade igenom häpnadsväckande 600 bilder per sekund. Traditionella metoder behandlar mindre än en bild per sekund.

Tekniken skulle till och med kunna erbjudas som en tjänst på externa datorer. Genom att använda denna avlastningsmodell skulle forskare kunna analysera mer data snabbare och lämna mer LHC-beräkningsutrymme tillgängligt för att utföra annat arbete.

Det är en lovande inblick i hur maskininlärningstjänster stöder ett område där redan enorma mängder data bara kommer att bli större.

Utmaningen:mer data, mer datorkraft

Forskare uppgraderar för närvarande LHC för att krossa protoner med fem gånger den nuvarande hastigheten. Senast 2026, den 17 mil långa cirkulära underjordiska maskinen vid det europeiska laboratoriet CERN kommer att producera 20 gånger mer data än den gör nu.

CMS är en av partikeldetektorerna vid Large Hadron Collider, och CMS-samarbetspartners är mitt uppe i några egna uppgraderingar, möjliggör det komplicerade, instrument för att ta mer sofistikerade bilder av LHC:s partikelkollisioner. Fermilab är det ledande amerikanska laboratoriet för CMS-experimentet.

Om LHC-forskare ville spara all rå kollisionsdata de skulle samla in på ett år från High-Luminosity LHC, de måste hitta ett sätt att lagra cirka 1 exabyte (cirka 1 biljon personliga externa hårddiskar), av vilka bara en slinga kan avslöja nya fenomen. LHC-datorer är programmerade att välja denna lilla del, fatta beslut på en del av en sekund om vilken data som är tillräckligt värdefull för att skickas nedströms för vidare studier.

För närvarande, LHC:s datorsystem håller ungefär en av 100, 000 partikelhändelser. Men nuvarande lagringsprotokoll kommer inte att kunna hålla jämna steg med den framtida datafloden, som kommer att ackumuleras under årtionden av datainsamling. Och de bilder med högre upplösning som tas med den uppgraderade CMS-detektorn kommer inte att göra jobbet enklare. Det hela leder till ett behov av mer än 10 gånger så mycket datorresurser som LHC har nu.

Partikelfysiker undersöker användningen av datorer med maskininlärningsfunktioner för att bearbeta bilder av partikelkollisioner vid CMS, lära dem att snabbt identifiera olika kollisionsmönster. Kredit:Eamonn Maguire/Antarctic Design

Det senaste prototyptestet visar att, med framsteg inom maskininlärning och datorhårdvara, forskare förväntar sig att kunna ta del av data som kommer från den kommande High-Luminosity LHC när den kommer online.

"Förhoppningen här är att du kan göra mycket sofistikerade saker med maskininlärning och även göra dem snabbare, sa Nhan Tran, en Fermilab-forskare på CMS-experimentet och en av ledarna i det senaste testet. "Det här är viktigt, eftersom vår data kommer att bli mer och mer komplex med uppgraderade detektorer och mer trafikerade kollisionsmiljöer."

Maskininlärning till undsättning:slutledningsskillnaden

Maskininlärning inom partikelfysik är inte nytt. Fysiker använder maskininlärning för varje steg av databehandling i ett kolliderexperiment.

Men med maskininlärningsteknik som kan tugga igenom LHC-data upp till 175 gånger snabbare än traditionella metoder, partikelfysiker tar sig upp i ett spelförändrande steg på kollisionsberäkningskursen.

De snabba takterna är tack vare smart konstruerad hårdvara i plattformen, Microsofts Azure ML, vilket påskyndar en process som kallas inferens.

För att förstå slutsatser, Tänk på en algoritm som har tränats för att känna igen bilden av en motorcykel:Objektet har två hjul och två handtag som är fästa på en större metallkropp. Algoritmen är smart nog att veta att en skottkärra, som har liknande egenskaper, är inte en motorcykel. När systemet skannar nya bilder av andra tvåhjuliga, föremål med två handtag, den förutspår – eller drar slutsatsen – vilka är motorcyklar. Och när algoritmens prediktionsfel korrigeras, det blir ganska skickligt att identifiera dem. En miljard skanningar senare, det är på sitt slutledningsspel.

De flesta maskininlärningsplattformar är byggda för att förstå hur man klassificerar bilder, men inte fysikspecifika bilder. Fysiker måste lära dem fysikdelen, som att känna igen spår skapade av Higgs-bosonen eller leta efter antydningar av mörk materia.

Forskare vid Fermilab, CERN, MIT, University of Washington och andra medarbetare tränade Azure ML för att identifiera bilder av toppkvarkar – en kortlivad elementarpartikel som är cirka 180 gånger tyngre än en proton – från simulerade CMS-data. Specifikt, Azure skulle leta efter bilder av översta kvarkstrålar, moln av partiklar som drogs ut ur vakuumet av en enda toppkvark som svängde bort från kollisionen.

"Vi skickade bilderna till den, träna den på fysikdata, " sa Fermilab-forskaren Burt Holzman, en ledning i projektet. "Och det uppvisade toppmodern prestanda. Det var väldigt snabbt. Det betyder att vi kan pipeline ett stort antal av dessa saker. I allmänhet, dessa tekniker är ganska bra."

En av teknikerna bakom inferensacceleration är att kombinera traditionella med specialiserade processorer, ett äktenskap som kallas heterogen datorarkitektur.

Data från partikelfysikexperiment lagras på datorgårdar som den här, Grid Computing Center på Fermilab. Utomstående organisationer erbjuder sina datorgårdar som en tjänst för partikelfysikexperiment, göra mer utrymme tillgängligt på experimentens servrar. Kredit:Reidar Hahn

Olika plattformar använder olika arkitekturer. De traditionella processorerna är CPU:er (centrala processorenheter). De mest kända specialiserade processorerna är GPU:er (graphics processing units) och FPGA:er (fältprogrammerbara gate arrays). Azure ML kombinerar CPU:er och FPGA:er.

"Anledningen till att dessa processer måste påskyndas är att det här är stora beräkningar. Du pratar om 25 miljarder operationer, " sa Tran. "Att montera det på en FPGA, kartlägga det, och att göra det inom rimlig tid är en verklig prestation."

Och det börjar erbjudas som en tjänst, för. Testet var första gången någon har visat hur denna typ av heterogen, as-a-service-arkitektur kan användas för grundläggande fysik.

I datorvärlden, att använda något "som en tjänst" har en specifik betydelse. En extern organisation tillhandahåller resurser – maskininlärning eller hårdvara – som en tjänst, och användare – forskare – använder dessa resurser när det behövs. Det liknar hur ditt videostreamingföretag tillhandahåller timmar av binge-tittande på TV som en tjänst. Du behöver inte äga dina egna DVD-skivor och DVD-spelare. Du använder deras bibliotek och gränssnitt istället.

Data från Large Hadron Collider lagras och bearbetas vanligtvis på datorservrar hos CERN och partnerinstitutioner som Fermilab. Med maskininlärning erbjuds lika enkelt som vilken annan webbtjänst som helst, intensiva beräkningar kan utföras var som helst där tjänsten erbjuds – även utanför anläggningen. Detta stärker labbets kapacitet med ytterligare datorkraft och resurser samtidigt som de besparar dem från att behöva tillhandahålla sina egna servrar.

"Idén att göra accelererad datoranvändning har funnits i decennier, men den traditionella modellen var att köpa ett datorkluster med GPU:er och installera det lokalt på labbet, ", sa Holzman. "Idén att lasta av arbetet till en gård utanför anläggningen med specialiserad hårdvara, tillhandahåller maskininlärning som en tjänst – som fungerade som annonserat."

Azure ML-gården ligger i Virginia. Det tar bara 100 millisekunder för datorer på Fermilab nära Chicago, Illinois, för att skicka en bild av en partikelhändelse till Azure-molnet, bearbeta det, och lämna tillbaka den. Det är en 2, 500 kilometer, datatät resa på ett ögonblick.

"VVS som följer med allt detta är en annan prestation, ", sa Tran. "Konceptet att abstrahera den datan som en sak som du bara skickar någon annanstans, och det kommer bara tillbaka, var det mest positivt överraskande med det här projektet. Vi behöver inte byta ut allt i vårt eget datorcenter med en hel massa nya grejer. Vi behåller allt, skicka iväg de hårda beräkningarna och få det att komma tillbaka senare."

Forskare ser fram emot att skala tekniken för att ta itu med andra stora datautmaningar vid LHC. De planerar också att testa andra plattformar, som Amazon AWS, Google Cloud och IBM Cloud, när de utforskar vad mer som kan åstadkommas genom maskininlärning, som har sett en snabb utveckling under de senaste åren.

"De modeller som var state-of-the-art för 2015 är standard idag, " sa Tran.

Som ett verktyg, maskininlärning fortsätter att ge partikelfysik nya sätt att se universum. Det är också imponerande i sig.

"Att vi kan ta något som är tränat för att skilja mellan bilder på djur och människor, gör en liten mängd beräkning, och låt den berätta för mig skillnaden mellan en topp-kvarkjet och bakgrund?" sa Holzman. "Det är något jag får mig att göra i tankarna."