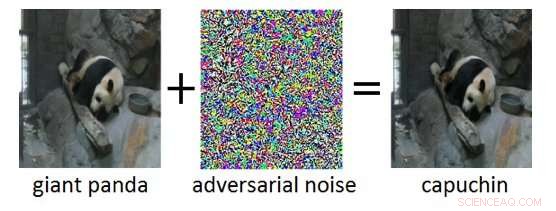

Figur 1:Adversariellt exempel (höger) erhålls genom att lägga till motstridigt brus (mitten) till en ren ingångsbild (vänster). Medan det extra bruset i det kontradiktoriska exemplet är omärkligt för en människa, det leder till att Deep Neural Network felklassificerar bilden som "capuchin" istället för "jättepanda". Kredit:IBM Blog Research

De senaste åren har sett enorma framsteg i utvecklingen av artificiell intelligens (AI). Moderna AI-system uppnår prestanda på mänsklig nivå på kognitiva uppgifter som att känna igen objekt i bilder, kommentera videor, konvertera tal till text, eller översätta mellan olika språk. Många av dessa genombrottsresultat är baserade på Deep Neural Networks (DNN). DNN är komplexa maskininlärningsmodeller som har viss likhet med de sammankopplade neuronerna i den mänskliga hjärnan. DNN:er kan hantera högdimensionella indata (t.ex. miljontals pixlar i högupplösta bilder), representerar mönster i dessa indata på olika abstraktionsnivåer, och relatera dessa representationer till semantiska begrepp på hög nivå.

En spännande egenskap hos DNN är att medan de normalt är mycket exakta, de är sårbara för så kallade motstridiga exempel. Motstridiga exempel är indata (säg, bilder) som avsiktligt har modifierats för att ge ett önskat svar av en DNN. Ett exempel visas i figur 1:här tillägget av en liten mängd motståndsljud till bilden av en jättepanda leder till att DNN felklassificerar denna bild som en kapucin. Ofta, Målet för motstridiga exempel är felklassificering eller en specifik felaktig förutsägelse som skulle gynna en angripare.

Motstridiga attacker utgör ett verkligt hot mot distributionen av AI-system i säkerhetskritiska applikationer. Nästan oupptäckbara ändringar av bilder, video, Tal, och andra data har skapats för att förvirra AI-system. Sådana ändringar kan skapas även om angriparen inte har exakt kunskap om arkitekturen för DNN eller tillgång till dess parametrar. Ännu mer oroande, motstridiga attacker kan lanseras i den fysiska världen:istället för att manipulera pixlarna i en digital bild, motståndare kunde undvika ansiktsigenkänningssystem genom att bära specialdesignade glasögon, eller besegra system för visuell igenkänning i autonoma fordon genom att fästa lappar på trafikskyltar.

IBM Research Ireland släpper Adversarial Robustness Toolbox, ett mjukvarubibliotek med öppen källkod, att stödja både forskare och utvecklare i att försvara DNN:er mot kontradiktoriska attacker och därigenom göra AI-system säkrare. Releasen kommer att tillkännages på RSA-konferensen av Dr. Sridhar Muppidi, IBM Fellow, VP och CTO IBM Security, och Koos Lodewijkx, Vice President och CTO för Security Operations and Response (SOAR), IBM Security.

Adversarial Robustness Toolbox är utformad för att stödja forskare och utvecklare i att skapa nya försvarstekniker, såväl som att distribuera praktiska försvar av verkliga AI-system. Forskare kan använda Adversarial Robustness Toolbox för att jämföra nya försvar mot det senaste. För utvecklare, Biblioteket tillhandahåller gränssnitt som stödjer sammansättningen av heltäckande försvarssystem med individuella metoder som byggstenar.

Biblioteket är skrivet i Python, det vanligaste programmeringsspråket för utveckling, testa och distribuera DNN. Den innehåller toppmoderna algoritmer för att skapa kontradiktoriska exempel samt metoder för att försvara DNN mot dessa. Metoden för att försvara DNN är tredelad:

För att komma igång med Adversarial Robustness Toolbox, kolla in open source-versionen under github.com/IBM/adversarial-robustness-toolbox. Utgåvan innehåller omfattande dokumentation och handledning för att hjälpa forskare och utvecklare att snabbt komma igång. En vitbok som beskriver de metoder som implementerats i biblioteket är under utarbetande.

Denna första version av Adversarial Robustness Toolbox stöder DNN:er implementerade i TensorFlow och Keras djupinlärningsramverk. Framtida utgåvor kommer att utöka stödet till andra populära ramverk som PyTorch eller MXNet. För närvarande, Biblioteket är främst avsett att förbättra motståndskraften hos visuella igenkänningssystem, dock, vi arbetar på framtida utgåvor som kommer att omfatta anpassningar till andra datalägen som tal, text eller tidsserier.

Som ett projekt med öppen källkod, Ambitionen med Adversarial Robustness Toolbox är att skapa ett levande ekosystem av bidragsgivare både från industri och akademi. Den största skillnaden mot liknande pågående insatser är fokus på försvarsmetoder, och om praktiska försvarssystems sammansättning. Vi hoppas att projektet Adversarial Robustness Toolbox kommer att stimulera forskning och utveckling kring kontradiktorisk robusthet hos DNN, och främja implementeringen av säker AI i verkliga applikationer. Dela med oss av din erfarenhet av att arbeta med Adversarial Robustness Toolbox och eventuella förslag på framtida förbättringar.