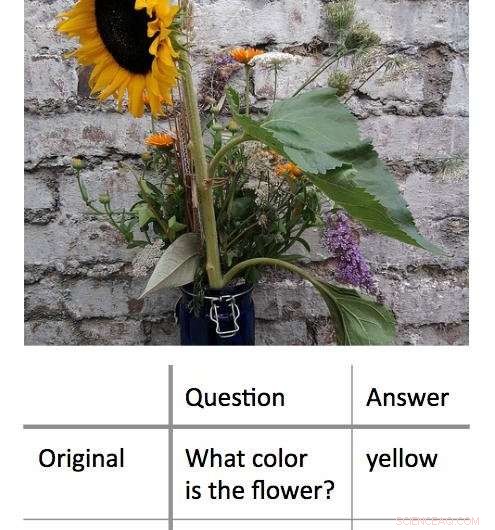

En ny metod för att avkoda de beslutsprocesser som används av "black box" maskininlärningsalgoritmer fungerar genom att hitta den minsta input som fortfarande ger ett korrekt svar. I det här exemplet, forskarna presenterade först en algoritm med ett foto av en solros och frågade "Vilken färg har blomman?" Detta resulterade i rätt svar, 'gul.' Forskarna fann att de kunde få samma rätta svar, med en lika hög grad av självförtroende, genom att ställa en fråga med ett ord till algoritmen:'Blomma?' Kredit:Shi Feng/University of Maryland

Artificiell intelligens – specifikt, maskininlärning – är en del av det dagliga livet för dator- och smartphoneanvändare. Från att automatiskt korrigera stavfel till att rekommendera ny musik, maskininlärningsalgoritmer kan hjälpa till att göra livet enklare. De kan också göra misstag.

Det kan vara en utmaning för datavetare att ta reda på vad som gick fel i sådana fall. Detta beror på att många maskininlärningsalgoritmer lär sig av information och gör sina förutsägelser i en virtuell "svart låda, " lämnar några ledtrådar för forskare att följa.

En grupp datavetare vid University of Maryland har utvecklat ett lovande nytt tillvägagångssätt för att tolka maskininlärningsalgoritmer. Till skillnad från tidigare försök, som vanligtvis försökte "bryta" algoritmerna genom att ta bort nyckelord från inmatningar för att ge fel svar, UMD-gruppen reducerade istället indata till det absoluta minimum som krävs för att ge rätt svar. I genomsnitt, forskarna fick rätt svar med en inmatning på mindre än tre ord.

I vissa fall, forskarnas modellalgoritmer gav rätt svar baserat på ett enda ord. Ofta, inmatningsordet eller frasen verkade ha liten uppenbar koppling till svaret, avslöjar viktiga insikter om hur vissa algoritmer reagerar på ett specifikt språk. Eftersom många algoritmer är programmerade att ge ett svar oavsett vad – även när de uppmanas av en meningslös input – kan resultaten hjälpa datavetare att bygga mer effektiva algoritmer som kan känna igen sina egna begränsningar.

Forskarna presenterar sitt arbete den 4 november, 2018 på 2018 års konferens om empiriska metoder i naturlig språkbehandling.

"Blackbox-modeller verkar fungera bättre än enklare modeller, såsom beslutsträd, men inte ens de som skrev den första koden kan säga exakt vad som händer, sa Jordan Boyd-Graber, studiens seniorförfattare och docent i datavetenskap vid UMD. "När dessa modeller ger felaktiga eller meningslösa svar, det är svårt att förstå varför. Så istället, vi försökte hitta den minimala input som skulle ge rätt resultat. Den genomsnittliga inmatningen var cirka tre ord, men vi kunde få ner det till ett enda ord i vissa fall."

Kredit:CC0 Public Domain

I ett exempel, forskarna skrev in ett foto av en solros och den textbaserade frågan, "Vilken färg har blomman?" som indata i en modellalgoritm. Dessa ingångar gav det korrekta svaret "gult". Efter att ha formulerat om frågan till flera olika kortare kombinationer av ord, forskarna fann att de kunde få samma svar med "blomma?" som den enda textinmatningen för algoritmen.

I en annan, mer komplext exempel, forskarna använde prompten, "År 1899, John Jacob Astor IV investerade 100 dollar, 000 för Tesla för att vidareutveckla och producera ett nytt belysningssystem. Istället, Tesla använde pengarna för att finansiera sina experiment i Colorado Springs."

De frågade sedan algoritmen, "Vad spenderade Tesla Astors pengar på?" och fick rätt svar, "Colorado Springs experiment." Att reducera denna inmatning till det enda ordet "gjorde" gav samma korrekta svar.

Arbetet avslöjar viktiga insikter om de regler som maskininlärningsalgoritmer tillämpar för problemlösning. Många problem i den verkliga världen med algoritmer uppstår när en input som är vettig för människor resulterar i ett meningslöst svar. Genom att visa att motsatsen också är möjlig - att meningslösa inmatningar också kan ge korrekta, förnuftiga svar – Boyd-Graber och hans kollegor visar behovet av algoritmer som kan känna igen när de svarar på en meningslös fråga med en hög grad av tillförsikt.

"Konklusionen är att alla dessa tjusiga maskininlärningsgrejer faktiskt kan vara ganska dumma, sa Boyd-Graber, som också har samarbetsutnämningar vid University of Maryland Institute for Advanced Computer Studies (UMIACS) samt UMD:s College of Information Studies and Language Science Center. "När datavetare tränar dessa modeller, vi visar dem vanligtvis bara riktiga frågor eller riktiga meningar. Vi visar dem inte orimliga fraser eller enstaka ord. Modellerna vet inte att de borde förvirras av dessa exempel."

De flesta algoritmer tvingar sig själva att ge ett svar, även med otillräckliga eller motstridiga data, enligt Boyd-Graber. Detta kan vara kärnan i några av de felaktiga eller meningslösa utdata som genereras av maskininlärningsalgoritmer – i modellalgoritmer som används för forskning, samt verkliga algoritmer som hjälper oss genom att flagga skräppost eller erbjuda alternativa vägbeskrivningar. Att förstå mer om dessa fel kan hjälpa datavetare att hitta lösningar och bygga mer tillförlitliga algoritmer.

"Vi visar att modeller kan tränas för att veta att de borde förväxlas, " sa Boyd-Graber. "Då kan de bara komma ut direkt och säga, "Du har visat mig något jag inte kan förstå."