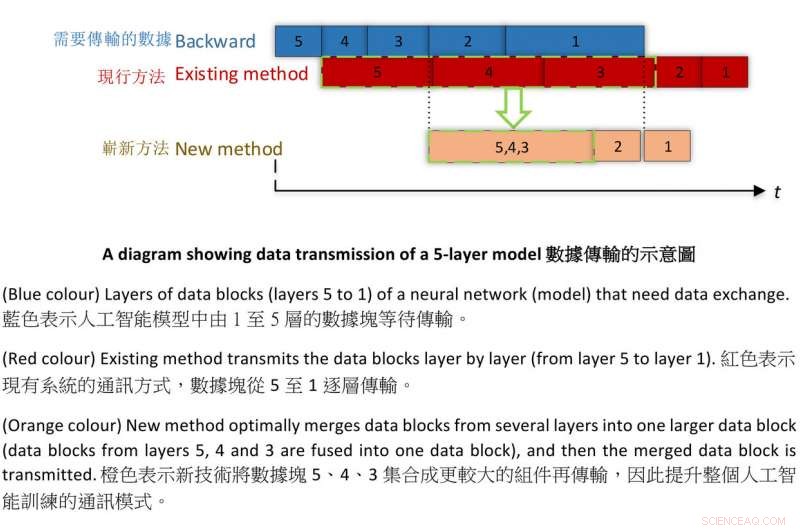

Diagram som visar dataöverföring av en 5-lagers modell. Kredit:HKBU

Forskare vid Hong Kong Baptist University (HKBU) har samarbetat med ett team från Tencent Machine Learning för att skapa en ny teknik för att träna maskiner med artificiell intelligens (AI) snabbare än någonsin med bibehållen noggrannhet.

Under experimentet, teamet tränade två populära djupa neurala nätverk kallade AlexNet och ResNet-50 på bara fyra minuter respektive 6,6 minuter. Tidigare, den snabbaste träningstiden var 11 minuter för AlexNet och 15 minuter för ResNet-50.

AlexNet och ResNet-50 är djupa neurala nätverk byggda på ImageNet, en storskalig datauppsättning för visuell igenkänning. Väl utbildad, systemet kunde känna igen och märka ett objekt i ett givet foto. Resultatet är betydligt snabbare än tidigare rekord och överträffar alla andra befintliga system.

Maskininlärning är en uppsättning matematiska tillvägagångssätt som gör det möjligt för datorer att lära sig av data utan att explicit programmeras av människor. De resulterande algoritmerna kan sedan tillämpas på en mängd olika uppgifter och visuella igenkänningsuppgifter som används i AI.

HKBU-teamet består av professor Chu Xiaowen och Ph.D. student Shi Shaohuai från institutionen för datavetenskap. Professor Chu sa, "Vi har föreslagit en ny optimerad träningsmetod som avsevärt förbättrar det bästa resultatet utan att tappa noggrannhet. I AI-träning, forskare strävar efter att träna sina nätverk snabbare, men detta kan leda till en minskning av noggrannheten. Som ett resultat, Att träna maskininlärningsmodeller i hög hastighet med bibehållen noggrannhet och precision är ett viktigt mål för forskare."

Professor Chu sa att tiden som krävs för att träna AI-maskiner påverkas av både beräkningstid och kommunikationstid. Forskargruppen uppnådde genombrott i båda aspekterna för att skapa denna rekordstora prestation.

Detta inkluderade att anta en enklare beräkningsmetod känd som FP16 för att ersätta den mer traditionella, FP32, gör beräkningen mycket snabbare utan att tappa noggrannhet. Eftersom kommunikationstiden påverkas av storleken på datablock, teamet kom på en kommunikationsteknik som heter "tensorfusion, " som kombinerar mindre bitar av data till större, optimera överföringsmönstret och därigenom förbättra effektiviteten i kommunikationen under AI-träning.

Denna nya teknik kan användas i storskalig bildklassificering, och det kan även appliceras på andra AI-applikationer, inklusive maskinöversättning; naturlig språkbehandling (NLP) för att förbättra interaktionen mellan mänskligt språk och datorer; medicinsk bildanalys; och online-kampspel för flera spelare.