Kredit:Marat Marihal/Shutterstock

Ända sedan företag började utveckla självkörande bilar, människor har frågat hur designers kommer att ta itu med den moraliska frågan om vem en självkörande bil ska döda om en dödsolycka är oundviklig. Ny forskning tyder på att denna fråga kan vara ännu svårare för biltillverkare att svara på än man tidigare trott eftersom de moraliska preferenser människor har varierar så mycket mellan länderna.

Forskarna, baserad på Harvard University och MIT, utvecklat ett onlinespel som simulerar situationer där en dödlig bilolycka var oundviklig. De bad cirka 40 miljoner människor från över 200 länder att välja mellan olika olycksfall, som att döda fotgängare snarare än bilens passagerare.

Resultaten avslöjade tre kulturkluster där det fanns signifikanta skillnader i vilka etiska preferenser människor hade. Till exempel, i det södra klustret (som omfattade större delen av Latinamerika och några tidigare franska kolonier), det fanns en stark preferens för att skona kvinnor framför män. Det östliga klustret (som inkluderade många islamiska länder såväl som Kina, Japan och Korea) hade en lägre preferens för att skona yngre människor framför äldre.

Forskarna avslutade med att säga att denna information borde påverka utvecklare av självkörande bilar. Men är det verkligen så? Även om detta dokument belyser en intressant upptäckt om globala variationer i moraliska preferenser, det belyser också ett ihållande missförstånd om AI, och vad den faktiskt kan göra. Med tanke på den nuvarande AI-tekniken som används i självkörande bilar, idén att ett fordon skulle kunna fatta ett moraliskt beslut är faktiskt omöjligt.

Fantasin om den "moraliska maskinen".

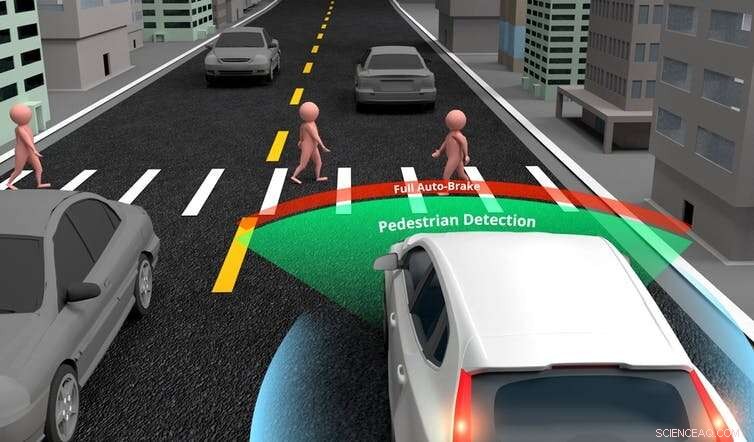

Självkörande bilar är tränade för att fatta beslut om var de ska styra eller när de ska bromsa, med hjälp av specifik (eller svag) AI (artificiell intelligens som är fokuserad på att slutföra en smal uppgift). De är designade med en rad sensorer, kameror och avståndsmätande lasrar (lidar), som ger information till en central dator. Datorn använder sedan AI för att analysera dessa indata och fatta ett beslut.

Även om tekniken för närvarande är relativt enkel, bilar kommer så småningom att överträffa människor i dessa grundläggande köruppgifter. Dock, det är orealistiskt att tro att självkörande bilar också ska kunna fatta ett etiskt beslut som inte ens den mest moraliska av människor skulle hinna fatta i ett olycksscenario. En bil skulle behöva programmeras med allmän AI om den förväntades göra detta.

Specifik AI tillåter självkörande bilar att göra grundläggande bedömningar om föremål i sin omgivning. Kredit:Akarat Phasura/ Shutterstock

Allmän AI är motsvarigheten till det som gör oss till människor. Det är förmågan att konversera, njut av musik, tycker att saker är roliga eller gör moraliska bedömningar. Att producera allmän AI är för närvarande omöjligt på grund av komplexiteten i mänskliga tankar och känslor. Om vi kräver moraliska autonoma fordon kommer vi inte att nå dit på flera decennier, om någonsin.

Ett annat problem med den nya forskningen var att många av de situationer som deltagarna ombads bedöma var orealistiska. I ett scenario som ekar det berömda "vagnproblemet", deltagarna tillfrågades vem bilen skulle döda om dess bromsar misslyckades:dess tre passagerare (en vuxen man, en vuxen kvinna och en pojke) eller tre äldre fotgängare (två män och en kvinna).

Människor kan noga överväga den här typen av problem när de besvarar ett frågeformulär. Men i de flesta verkliga olyckor, en förare skulle inte hinna göra sådana bedömningar på en sekund innan det händer. Det betyder att jämförelsen är ogiltig. Och med tanke på den nuvarande AI-tekniken för självkörande bilar, dessa fordon kommer inte att kunna göra dessa bedömningar heller.

Nuvarande självkörande bilar har sofistikerade avkänningsförmåga och kan skilja fotgängare från andra föremål, såsom lyktstolpar eller vägmärken. Dock, forskningsförfattarna föreslår att självkörande bilar kan, kommer och borde kanske kunna göra mer avancerade distinktioner. Till exempel, de kunde känna igen människor som ansågs vara mer önskvärda för samhället, som läkare eller idrottare, och väljer att spara dem i ett kraschscenario.

Verkligheten är att design av bilar för att göra sådana avancerade bedömningar skulle innebära att producera allmän AI, vilket för närvarande är omöjligt. Det är också frågan om detta ens är önskvärt. Om det någonsin är möjligt att programmera en bil för att bestämma vilket liv som ska räddas, det är inget jag anser att vi bör tillåta. Vi bör inte tillåta de preferenser som identifierats i forskning, hur stor urvalet än är, att bestämma värdet av ett liv.

I sin mest grundläggande form, självkörande bilar designas för att undvika olyckor om de kan, och minimera hastigheten vid kollisionen om de inte kan. Fastän, som människor, de kan inte fatta ett moraliskt beslut innan en oundviklig olycka. Men självkörande bilar kommer att vara säkrare än mänskliga förare, eftersom de är mer uppmärksamma, kan reagera snabbare och kommer att använda bromssystemets kapacitet fullt ut i ett olycksscenario.

För närvarande, den största etiska utmaningen som designers av självkörande bilar står inför är att avgöra när det finns tillräckligt med bevis på säkert beteende från simuleringar och kontrollerade tester på väg för att introducera självkörande bilar på vägen. Men detta betyder inte att de är "moraliska", eller kommer när som helst snart. Att säga det är att blanda ihop den specifika AI som gör köruppgifter med allmän AI, som troligen inte kommer att existera under vår livstid.

I sista hand, självkörande bilar kommer att vara säkrare än människor. De kommer att uppnå detta genom att designa och undvika olyckor där det är möjligt, och minska skador där inte. Dock, bilarna kommer inte att kunna fatta moraliska beslut som inte ens vi kunde. Denna uppfattning förblir en långsökt fantasi, och inte en vi borde hoppas på. Istället, låt oss koncentrera oss på säkerhet:något vi kommer att kunna ha berättigat förtroende för.

Den här artikeln är återpublicerad från The Conversation under en Creative Commons-licens. Läs originalartikeln.