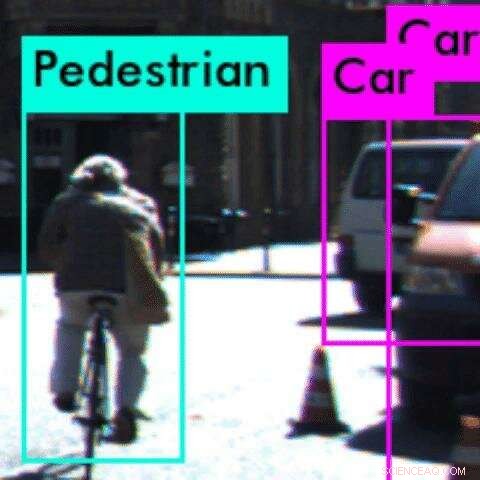

I det här exemplet, en perceptionsalgoritm felklassificerar cyklisten som en fotgängare Kredit:Anand Balakrishnan

Det är en stor fråga för många människor i trafiktäta städer som Los Angeles:När kommer självkörande bilar? Men efter en serie uppmärksammade olyckor i USA, säkerhetsfrågor kan få den autonoma drömmen till ett skrikande stopp.

Vid USC, forskare har publicerat en ny studie som tar itu med ett långvarigt problem för utvecklare av autonoma fordon:testa systemets uppfattningsalgoritmer, som gör att bilen kan "förstå" vad den "ser".

Arbetar med forskare från Arizona State University, teamets nya matematiska metod kan identifiera anomalier eller buggar i systemet innan bilen kör ut på vägen.

Perceptionsalgoritmer är baserade på konvolutionella neurala nätverk, drivs av maskininlärning, en typ av djupinlärning. Dessa algoritmer är notoriskt svåra att testa, eftersom vi inte helt förstår hur de gör sina förutsägelser. Detta kan leda till förödande konsekvenser i säkerhetskritiska system som autonoma fordon.

"Att göra perceptionsalgoritmer robusta är en av de främsta utmaningarna för autonoma system, " sa studiens huvudförfattare Anand Balakrishnan, en USC datavetenskap Ph.D. studerande.

"Med den här metoden, Utvecklare kan komma in på fel i perceptionsalgoritmerna mycket snabbare och använda denna information för att vidareutbilda systemet. På samma sätt som bilar måste gå igenom krocktester för att garantera säkerheten, denna metod erbjuder ett förebyggande test för att fånga upp fel i autonoma system."

Pappret, med titeln Specificera och utvärdera kvalitetsmått för visionsbaserade perceptionssystem, presenterades på Design, Automation and Test in Europe-konferens i Italien, 28 mars.

Att lära sig om världen

Vanligtvis "lär sig" autonoma fordon om världen via maskininlärningssystem, som matas med enorma datauppsättningar av vägbilder innan de kan identifiera objekt på egen hand.

Men systemet kan gå fel. I fallet med en dödsolycka mellan en självkörande bil och en fotgängare i Arizona förra mars, programvaran klassade fotgängaren som en "falsk positiv" och beslutade att den inte behövde stanna.

"Vi trodde, uppenbarligen finns det något problem med hur denna uppfattningsalgoritm har tränats, " sa studiens medförfattare Jyo Deshmukh, en USC-professor i datavetenskap och tidigare forsknings- och utvecklingsingenjör för Toyota, specialiserad på autonom fordonssäkerhet.

"När en människa uppfattar en video, det finns vissa antaganden om uthållighet som vi implicit använder:om vi ser en bil inom en videoram, vi förväntar oss att se en bil på en närliggande plats i nästa videobild. Detta är ett av flera "sanity-villkor" som vi vill att perceptionsalgoritmen ska uppfylla innan implementering."

Till exempel, ett objekt kan inte visas och försvinna från en bildruta till nästa. Om det gör det, det bryter mot ett "förnuftsvillkor, "eller fysikens grundläggande lag, vilket tyder på att det finns en bugg i perceptionssystemet.

Deshmukh och hans Ph.D. student Balakrishnan, tillsammans med USC Ph.D. student Xin Qin och masterstudent Aniruddh Puranic, samarbetade med tre Arizona State University-forskare för att undersöka problemet.

Inget utrymme för fel

Teamet formulerade en ny matematisk logik, kallad Timed Quality Temporal Logic, och använde den för att testa två populära maskininlärningsverktyg – Squeeze Det och YOLO – med hjälp av råa videodatauppsättningar av körscener.

Logiken har framgångsrikt finslipat instanser av maskininlärningsverktyg som bryter mot "sanity conditions" över flera bildrutor i videon. Vanligast, maskininlärningssystemen misslyckades med att upptäcka ett objekt eller felklassificerade ett objekt.

Till exempel, i ett exempel, systemet kunde inte känna igen en cyklist bakifrån, när cykelns däck såg ut som en tunn vertikal linje. Istället, den felklassade cyklisten som fotgängare. I detta fall, systemet kanske misslyckas med att korrekt förutse cyklistens nästa drag, som kan leda till en olycka.

Fantomobjekt – där systemet uppfattar ett objekt när det inte finns något – var också vanliga. Detta kan få bilen att av misstag smälla på rasterna - ett annat potentiellt farligt drag.

Teamets metod skulle kunna användas för att identifiera anomalier eller buggar i perceptionsalgoritmen före driftsättning på vägen och tillåter utvecklare att lokalisera specifika problem.

Tanken är att fånga problem med perceptionsalgoritmen i virtuella tester, gör algoritmerna säkrare och mer tillförlitliga. Avgörande, eftersom metoden förlitar sig på ett bibliotek av "sanity conditions, "det finns inget behov för människor att märka objekt i testdatauppsättningen - en tidskrävande och ofta felaktig process.

I framtiden, teamet hoppas kunna införliva logiken för att träna om perceptionsalgoritmerna när det hittar ett fel. Det kan också utökas till realtidsanvändning, medan bilen kör, som en säkerhetsmonitor i realtid.