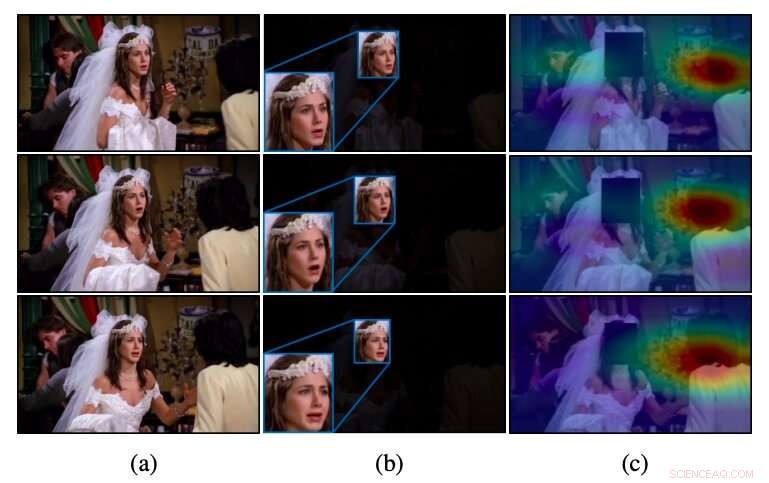

Intuition av CAER-Net för otrimmade videor, som i (a) konventionella metoder som endast utnyttjar ansiktsregionerna, som i (b), ofta misslyckas med att känna igen känslor. Till skillnad från dessa metoder, CAER-Net fokuserar på både ansikts- och uppmärksamma sammanhangsregioner, som framgår av (c). Kredit:Lee et al.

Ett team av forskare vid Yonsei University och École Polytechnique Fédérale de Lausanne (EPFL) har nyligen utvecklat en ny teknik som kan känna igen känslor genom att analysera människors ansikten i bilder tillsammans med kontextuella drag. De presenterade och beskrev sin djupinlärningsbaserade arkitektur, kallas CAER-Net, i en tidning förpublicerad på arXiv.

För några år, Forskare över hela världen har försökt utveckla verktyg för att automatiskt upptäcka mänskliga känslor genom att analysera bilder, videor eller ljudklipp. Dessa verktyg kan ha många tillämpningar, till exempel, förbättra interaktioner mellan robot och människa eller hjälpa läkare att identifiera tecken på psykiska eller neurala störningar (t.ex. , baserat på atypiska talmönster, ansiktsdrag, etc.).

Än så länge, majoriteten av teknikerna för att känna igen känslor i bilder har baserats på analys av människors ansiktsuttryck, i huvudsak antar att dessa uttryck bäst förmedlar människors känslomässiga reaktioner. Som ett resultat, de flesta datamängder för att träna och utvärdera verktyg för känsloigenkänning (t.ex. datauppsättningarna AFEW och FER2013) innehåller endast beskurna bilder av mänskliga ansikten.

En viktig begränsning för konventionella verktyg för känsloigenkänning är att de inte lyckas uppnå tillfredsställande prestanda när känslomässiga signaler i människors ansikten är tvetydiga eller omöjliga att särskilja. I motsats till dessa tillvägagångssätt, människor kan känna igen andras känslor inte bara baserat på deras ansiktsuttryck, men också på kontextuella ledtrådar (t.ex. de åtgärder de utför, deras interaktion med andra, var de är, etc.).

Tidigare studier tyder på att analys av både ansiktsuttryck och kontextrelaterade särdrag avsevärt kan öka prestandan hos verktyg för känsloigenkänning. Inspirerad av dessa fynd, forskarna vid Yonsei och EPFL satte sig för att utveckla en djupinlärningsbaserad arkitektur som kan känna igen människors känslor i bilder baserat på både deras ansiktsuttryck och kontextuell information.

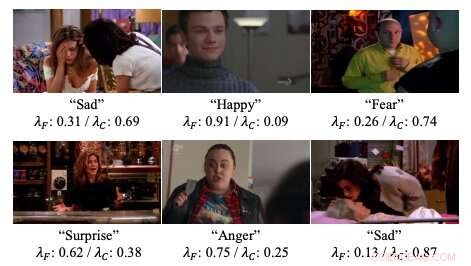

Exempel på uppmärksamhetsvikter i de neurala nätverk som forskarna tagit fram. Kredit:Lee et al.

"Vi presenterar djupa nätverk för kontextmedveten känslorigenkänning, kallas CAER-Net, som inte bara utnyttjar mänskliga ansiktsuttryck, men också kontextinformation, på ett gemensamt och stimulerande sätt, " skrev forskarna i sin uppsats. "Nyckelidén är att dölja mänskliga ansikten i en visuell scen och söka andra sammanhang baserat på en uppmärksamhetsmekanism."

CAER-Net, arkitekturen utvecklad av forskare, består av två viktiga undernätverk och kodare som separat extraherar ansiktsdrag och kontextuella regioner i en bild. Dessa två typer av funktioner kombineras sedan med hjälp av adaptiva fusionsnätverk och analyseras tillsammans för att förutsäga människors känslor i en given bild.

Förutom CAER-Net, forskarna introducerade också en ny datamängd för kontextmedveten känslomässig igenkänning, som de refererar till som CAER. Bilder i denna datauppsättning visar både människors ansikten och deras omgivning/kontext, därför skulle det kunna fungera som ett mer effektivt riktmärke för träning i att utvärdera känsloigenkänningstekniker.

Forskarna utvärderade sin känsloigenkänningsteknik i en serie experiment, använda både datauppsättningen de kompilerade och AFEW-datauppsättningen. Deras resultat tyder på att analys av både ansiktsuttryck och kontextuell information kan avsevärt öka prestandan hos verktyg för känsloigenkänning, enligt tidigare studier.

"Vi hoppas att resultaten av den här studien kommer att underlätta ytterligare framsteg inom sammanhangsmedveten känslomässig igenkänning och dess relaterade uppgifter, " skrev forskarna.

© 2019 Science X Network