Som robotar, självkörande bilar och andra intelligenta maskiner väver AI in i vardagen, ett nytt sätt att designa algoritmer kan hjälpa maskininlärningsutvecklare att bygga in skydd mot specifika, oönskade resultat som ras- och könsfördomar. Upphovsman:Deboki Chakravarti

Konstgjord intelligens har flyttat in i den kommersiella mainstream tack vare den växande förmågan till maskininlärningsalgoritmer som gör det möjligt för datorer att träna sig själva för att köra bil, styra robotar eller automatisera beslutsfattande.

Men när AI börjar hantera känsliga uppgifter, som att hjälpa till att välja vilka fångar som får borgen, beslutsfattare insisterar på att datavetenskapare erbjuder försäkringar om att automatiska system har utformats för att minimera, om inte helt undvika, oönskade resultat som överdriven risk eller ras- och könsfördomar.

Ett team som leds av forskare vid Stanford och University of Massachusetts Amherst publicerade ett papper 22 november Vetenskap föreslår hur man ger sådana försäkringar. Tidningen beskriver en ny teknik som översätter ett suddigt mål, som att undvika könsfördomar, i de exakta matematiska kriterierna som skulle tillåta en maskininlärningsalgoritm att träna en AI-applikation för att undvika det beteendet.

"Vi vill främja AI som respekterar sina mänskliga användares värderingar och motiverar det förtroende vi ger i autonoma system, sa Emma Brunskill, en biträdande professor i datavetenskap vid Stanford och seniorförfattare till tidningen.

Undvik missförhållanden

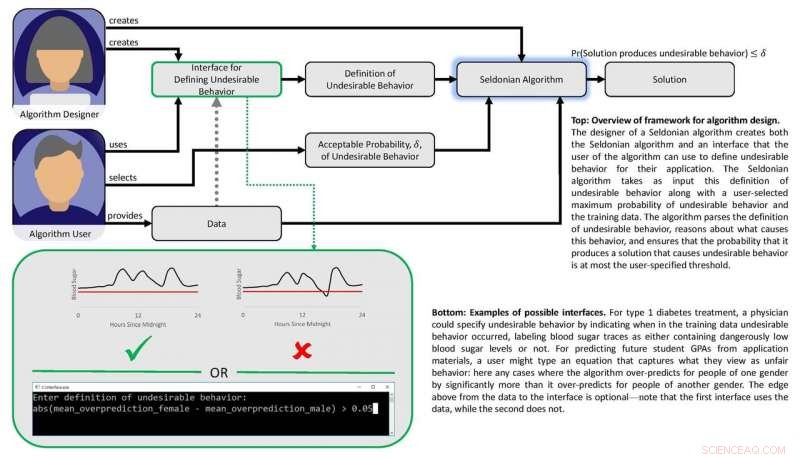

Arbetet bygger på tanken att om "osäkra" eller "orättvisa" resultat eller beteenden kan definieras matematiskt, då borde det vara möjligt att skapa algoritmer som kan lära av data om hur man undviker dessa oönskade resultat med stort förtroende. Forskarna ville också utveckla en uppsättning tekniker som skulle göra det enkelt för användarna att ange vilken typ av oönskat beteende de vill begränsa och göra det möjligt för maskininlärningsdesigners att förutse med säkerhet att ett system som är utbildat i tidigare data kan lita på när det tillämpas under verkliga omständigheter.

"Vi visar hur konstruktörerna för maskininlärningsalgoritmer kan göra det lättare för människor som vill bygga AI i sina produkter och tjänster att beskriva oönskade resultat eller beteenden som AI-systemet med stor sannolikhet kommer att undvika, "sa Philip Thomas, en biträdande professor i datavetenskap vid University of Massachusetts Amherst och första författare till tidningen.

Rättvisa och säkerhet

Forskarna testade deras tillvägagångssätt genom att försöka förbättra rättvisan hos algoritmer som förutsäger högskolestudenters GPAs baserat på examensresultat, en vanlig praxis som kan resultera i könsfördomar. Med hjälp av en experimentell dataset, de gav sin algoritm matematiska instruktioner för att undvika att utveckla en prediktiv metod som systematiskt överskattade eller underskattade GPA för ett kön. Med dessa instruktioner, algoritmen identifierade ett bättre sätt att förutsäga studenters GPA med mycket mindre systematisk könsfördom än befintliga metoder. Tidigare metoder kämpade i detta avseende antingen för att de inte hade något rättvisefilter inbyggt eller för att algoritmer som utvecklats för att uppnå rättvisa var för begränsade.

Gruppen utvecklade en annan algoritm och använde den för att balansera säkerhet och prestanda i en automatiserad insulinpump. Sådana pumpar måste bestämma hur stor eller liten dos insulin som ska ges till en patient vid måltider. Helst, pumpen levererar tillräckligt med insulin för att hålla blodsockernivån stabil. För lite insulin gör att blodsockernivån kan stiga, vilket leder till kortsiktiga besvär som illamående, och förhöjd risk för långsiktiga komplikationer inklusive kardiovaskulär sjukdom. För mycket och blodsockret kraschar - ett potentiellt dödligt resultat.

Diagram som visar papperets ramar. Upphovsman:Philip Thomas

Maskininlärning kan hjälpa till genom att identifiera subtila mönster i individens blodsockersvar på doser, men befintliga metoder gör det inte lätt för läkare att ange resultat som automatiserade doseringsalgoritmer bör undvika, som lågt blodsocker kraschar. Med hjälp av en blodsockersimulator, Brunskill och Thomas visade hur pumpar kunde utbildas för att identifiera dosering skräddarsydd för den personen- undvika komplikationer från över- eller underdosering. Även om gruppen inte är redo att testa denna algoritm på riktiga människor, det pekar på en AI -metod som så småningom kan förbättra livskvaliteten för diabetiker.

I deras Vetenskap papper, Brunskill och Thomas använder termen "Seldonian algoritm" för att definiera deras tillvägagångssätt, en hänvisning till Hari Seldon, en karaktär som uppfanns av science fiction -författaren Isaac Asimov, som en gång förkunnade tre robotiklagar som började med föreläggandet att "En robot får inte skada en människa eller, genom passivitet, låt en människa komma till skada. "

Medan man erkänner att området fortfarande är långt ifrån att garantera de tre lagarna, Thomas sa att detta seldonska ramverk kommer att göra det lättare för maskininlärningsdesigners att bygga instruktioner för att undvika beteende i alla typer av algoritmer, på ett sätt som kan göra det möjligt för dem att bedöma sannolikheten för att utbildade system fungerar korrekt i den verkliga världen.

Brunskill sa att detta föreslagna ramverk bygger på de ansträngningar som många datavetare gör för att hitta en balans mellan att skapa kraftfulla algoritmer och att utveckla metoder för att säkerställa deras tillförlitlighet.

"Att tänka på hur vi kan skapa algoritmer som bäst respekterar värden som säkerhet och rättvisa är viktigt eftersom samhället allt mer förlitar sig på AI, Sa Brunskill.