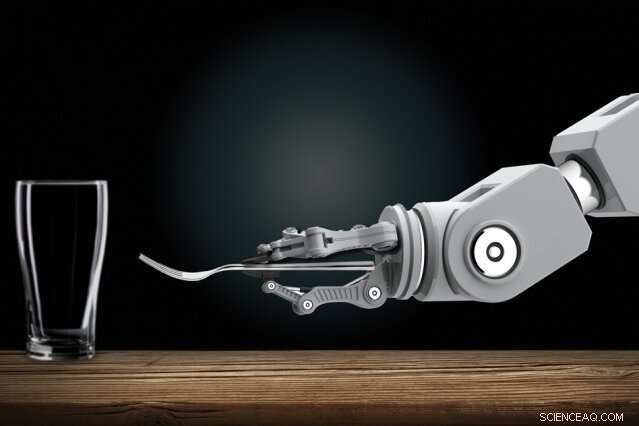

Robotister utvecklar automatiserade robotar som kan lära sig nya uppgifter enbart genom att observera människor. Hemma, du kanske en dag visar en inhemsk robot hur man gör rutinsysslor. Kredit:Christine Daniloff, MIT

Att träna interaktiva robotar kan en dag bli ett enkelt jobb för alla, även de utan programmeringsexpertis. Robotister utvecklar automatiserade robotar som kan lära sig nya uppgifter enbart genom att observera människor. Hemma, du kanske en dag visar en inhemsk robot hur man gör rutinsysslor. På arbetsplatsen, du kan träna robotar som nya anställda, visar dem hur man utför många uppgifter.

Att göra framsteg på den visionen, MIT-forskare har designat ett system som låter dessa typer av robotar lära sig komplicerade uppgifter som annars skulle hindra dem med för många förvirrande regler. En sådan uppgift är att duka middagsbord under vissa förutsättningar.

I dess kärna, forskarnas "Planning with Uncertain Specifications" (PUnS) system ger robotar den mänskliga planeringsförmågan att samtidigt väga många tvetydiga – och potentiellt motsägelsefulla – krav för att nå ett slutmål. Genom att göra så, systemet väljer alltid den mest sannolika åtgärden att vidta, baserat på en "tro" om några troliga specifikationer för uppgiften den ska utföra.

I sitt arbete, forskarna sammanställde en datauppsättning med information om hur åtta föremål – en mugg, glas, sked, gaffel, kniv, middagstallrik, liten tallrik, och skål – kan placeras på ett bord i olika konfigurationer. En robotarm observerade först slumpmässigt utvalda mänskliga demonstrationer av att duka bordet med föremålen. Sedan, forskarna gav armen i uppdrag att automatiskt ställa ett bord i en specifik konfiguration, i verkliga experiment och i simulering, baserat på vad den hade sett.

Att lyckas, roboten var tvungen att väga många möjliga placeringsbeställningar, även när föremål togs bort avsiktligt, staplade, eller dold. I vanliga fall, allt det skulle förvirra robotar för mycket. Men forskarnas robot gjorde inga misstag under flera verkliga experiment, och bara en handfull misstag under tiotusentals simulerade testkörningar.

"Visionen är att lägga programmering i händerna på domänexperter, som kan programmera robotar på intuitiva sätt, istället för att beskriva order till en ingenjör att lägga till i sin kod, " säger första författaren Ankit Shah, en doktorand vid Institutionen för Aeronautics and Astronautics (AeroAstro) och Interactive Robotics Group, som betonar att deras arbete bara är ett steg i att uppfylla den visionen. "På det sättet, robotar kommer inte att behöva utföra förprogrammerade uppgifter längre. Fabriksarbetare kan lära en robot att utföra flera komplexa monteringsuppgifter. Inhemska robotar kan lära sig hur man staplar skåp, ladda diskmaskinen, eller duka av folk hemma."

Med Shah på tidningen är AeroAstro och Interactive Robotics Group-studenten Shen Li och Interactive Robotics Group-ledaren Julie Shah, en docent i AeroAstro och Laboratoriet för datavetenskap och artificiell intelligens.

Bots hedging satsningar

Robotar är bra planerare i uppgifter med tydliga "specifikationer, " som hjälper till att beskriva uppgiften som roboten behöver utföra, med tanke på dess handlingar, miljö, och slutmål. Att lära sig att duka genom att observera demonstrationer, är full av osäkra specifikationer. Föremål måste placeras på vissa ställen, beroende på menyn och var gästerna sitter, och i vissa beställningar, beroende på en varas omedelbara tillgänglighet eller sociala konventioner. Nuvarande tillvägagångssätt för planering är inte kapabla att hantera sådana osäkra specifikationer.

Ett populärt tillvägagångssätt för planering är "förstärkande lärande, " en prova-och-fel-maskininlärningsteknik som belönar och straffar dem för handlingar när de arbetar för att slutföra en uppgift. Men för uppgifter med osäkra specifikationer, det är svårt att definiera tydliga belöningar och straff. Kortfattat, robotar lär sig aldrig helt rätt från fel.

Forskarnas system, kallas PUnS (för planering med osäkra specifikationer), gör det möjligt för en robot att hålla en "tro" över en rad möjliga specifikationer. Själva tron kan sedan användas för att dela ut belöningar och straff. "Roboten säkrar i huvudsak sina insatser i termer av vad som är avsett med en uppgift, och vidtar åtgärder som tillfredsställer dess övertygelse, istället för att vi ger det en tydlig specifikation, " säger Ankit Shah.

Systemet är byggt på "linjär temporal logik" (LTL), ett uttrycksfullt språk som möjliggör robotresonemang om nuvarande och framtida resultat. Forskarna definierade mallar i LTL som modellerar olika tidsbaserade förhållanden, som vad som måste hända nu, måste så småningom hända, och måste hända tills något annat händer. Robotens observationer av 30 mänskliga demonstrationer för att duka tabellen gav en sannolikhetsfördelning över 25 olika LTL-formler. Varje formel kodade en något annorlunda preferens - eller specifikation - för att duka upp tabellen. Den sannolikhetsfördelningen blir dess tro.

"Varje formel kodar något annat, men när roboten överväger olika kombinationer av alla mallar, och försöker tillfredsställa allt tillsammans, det slutar med att det gör rätt till slut, " säger Ankit Shah.

Följande kriterier

Forskarna utvecklade också flera kriterier som styr roboten mot att tillfredsställa hela tron på dessa kandidatformler. Ett, till exempel, uppfyller den mest sannolika formeln, som kasserar allt annat förutom mallen med högst sannolikhet. Andra uppfyller det största antalet unika formler, utan att ta hänsyn till deras totala sannolikhet, eller så uppfyller de flera formler som representerar högsta totala sannolikhet. En annan minimerar helt enkelt fel, så systemet ignorerar formler med hög sannolikhet för misslyckande.

Designers kan välja vilket som helst av de fyra kriterierna att förinställa innan träning och testning. Var och en har sin egen kompromiss mellan flexibilitet och riskaversion. Valet av kriterier beror helt på uppgiften. I säkerhetskritiska situationer, till exempel, a designer may choose to limit possibility of failure. But where consequences of failure are not as severe, designers can choose to give robots greater flexibility to try different approaches.

With the criteria in place, the researchers developed an algorithm to convert the robot's belief—the probability distribution pointing to the desired formula—into an equivalent reinforcement learning problem. This model will ping the robot with a reward or penalty for an action it takes, based on the specification it's decided to follow.

In simulations asking the robot to set the table in different configurations, it only made six mistakes out of 20, 000 tries. In real-world demonstrations, it showed behavior similar to how a human would perform the task. If an item wasn't initially visible, till exempel, the robot would finish setting the rest of the table without the item. Sedan, when the fork was revealed, it would set the fork in the proper place. "That's where flexibility is very important, " Shah says. "Otherwise it would get stuck when it expects to place a fork and not finish the rest of table setup."

Nästa, the researchers hope to modify the system to help robots change their behavior based on verbal instructions, corrections, or a user's assessment of the robot's performance. "Say a person demonstrates to a robot how to set a table at only one spot. The person may say, 'do the same thing for all other spots, ' or, 'place the knife before the fork here instead, '" Shah says. "We want to develop methods for the system to naturally adapt to handle those verbal commands, without needing additional demonstrations."

Den här historien återpubliceras med tillstånd av MIT News (web.mit.edu/newsoffice/), en populär webbplats som täcker nyheter om MIT-forskning, innovation och undervisning.