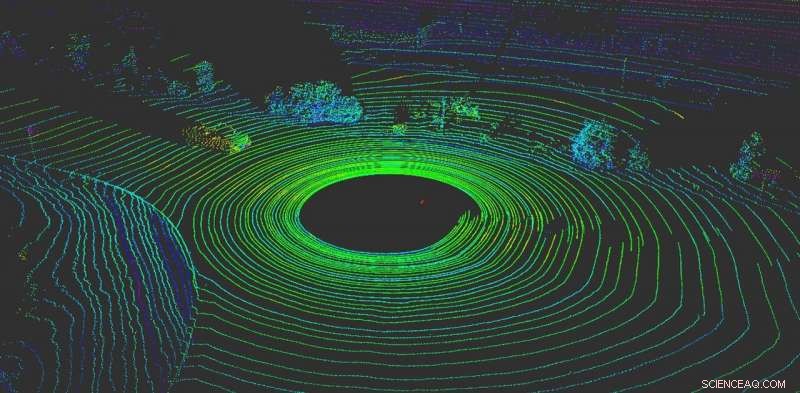

LiDAR hjälper ett autonomt fordon att "visualisera" vad som finns runt det. Kredit:Yulong Can med data från Baidu Apollo, CC BY-ND

Ingenting är viktigare för ett autonomt fordon än att känna av vad som händer runt det. Som mänskliga förare, autonoma fordon behöver förmågan att fatta omedelbara beslut.

I dag, de flesta autonoma fordon är beroende av flera sensorer för att uppfatta världen. De flesta system använder en kombination av kameror, radarsensorer och LiDAR-sensorer (light detection and rangeing). Ombord, datorer smälter samman dessa data för att skapa en heltäckande bild av vad som händer runt bilen. Utan dessa uppgifter, autonoma fordon skulle inte ha något hopp om att säkert navigera i världen. Bilar som använder flera sensorsystem fungerar både bättre och är säkrare – varje system kan fungera som en kontroll på de andra – men inget system är immunt mot attacker.

Tyvärr, dessa system är inte idiotsäkra. Kamerabaserade uppfattningssystem kan luras helt enkelt genom att sätta klistermärken på trafikskyltar för att helt ändra deras betydelse.

Vårt arbete, från RobustNet Research Group vid University of Michigan, har visat att det LiDAR-baserade perceptionssystemet kan innefattas, för. Genom att strategiskt spoofa LiDAR-sensorsignalerna, attacken kan lura fordonets LiDAR-baserade perceptionssystem att "se" ett obefintligt hinder. Om detta händer, ett fordon kan orsaka en krock genom att blockera trafiken eller bromsa brått.

Spoofing LiDAR -signaler

LiDAR-baserade perceptionssystem har två komponenter:sensorn och maskininlärningsmodellen som bearbetar sensorns data. En LiDAR-sensor beräknar avståndet mellan sig själv och sin omgivning genom att avge en ljussignal och mäta hur lång tid det tar för den signalen att studsa av ett föremål och återvända till sensorn. Denna varaktighet av denna fram och tillbaka är också känd som "flygtiden".

En LiDAR-enhet skickar ut tiotusentals ljussignaler per sekund. Sedan använder dess maskininlärningsmodell de returnerade pulserna för att måla en bild av världen runt fordonet. Det liknar hur en fladdermus använder ekolokalisering för att veta var hinder finns på natten.

Problemet är att dessa pulser kan förfalskas. För att lura sensorn, en angripare kan lysa sin egen ljussignal mot sensorn. Det är allt du behöver för att blanda ihop sensorn.

Dock, det är svårare att förfalska LiDAR-sensorn för att "se" ett "fordon" som inte finns där. Att lyckas, angriparen måste exakt tajma signalerna som skjutits mot offret LiDAR. Detta måste ske på nanosekundnivå, eftersom signalerna färdas med ljusets hastighet. Små skillnader kommer att sticka ut när LiDAR beräknar avståndet med hjälp av den uppmätta flygtiden.

Om en angripare lyckas lura LiDAR-sensorn, den måste då också lura maskininlärningsmodellen. Arbete som utförts på OpenAI forskningslabb visar att maskininlärningsmodeller är sårbara för speciellt utformade signaler eller ingångar - så kallade motsatta exempel. Till exempel, specialgenererade klistermärken på trafikskyltar kan lura kamerabaserad uppfattning.

Vi fann att en angripare kunde använda en liknande teknik för att skapa störningar som fungerar mot LiDAR. De skulle inte vara en synlig klistermärke, men förfalskade signaler speciellt skapade för att lura maskininlärningsmodellen att tro att det finns hinder när det faktiskt inte finns några. LiDAR-sensorn matar hackarens falska signaler till maskininlärningsmodellen, som kommer att känna igen dem som ett hinder.

Det kontradiktoriska exemplet – det falska objektet – skulle kunna skapas för att möta förväntningarna på maskininlärningsmodellen. Till exempel, angriparen kan skapa signalen om en lastbil som inte rör sig. Sedan, att genomföra attacken, de kan ställa upp den i en korsning eller placera den på ett fordon som körs framför ett autonomt fordon.

Två möjliga attacker

För att demonstrera den designade attacken, vi valde ett autonomt körsystem som används av många biltillverkare:Baidu Apollo. Denna produkt har över 100 partners och har nått ett massproduktionsavtal med flera tillverkare inklusive Volvo och Ford.

Genom att använda sensordata från verkliga världen som samlats in av Baidu Apollo-teamet, vi demonstrerade två olika attacker. I den första, en "nödbroms attack, "Vi visade hur en angripare plötsligt kan stoppa ett fordon i rörelse genom att lura det att tro att ett hinder dök upp i dess väg. I den andra, en "AV-frysningsattack, "Vi använde ett falskt hinder för att lura ett fordon som hade stoppats vid rött ljus att förbli stoppat efter att ljuset blivit grönt.

Genom att utnyttja sårbarheterna i uppfattningssystem för autonom körning, Vi hoppas kunna utlösa ett larm för team som bygger autonom teknik. Forskning om nya typer av säkerhetsproblem i de autonoma körsystemen har bara börjat, och vi hoppas kunna avslöja fler möjliga problem innan de kan utnyttjas ute på vägen av dåliga aktörer.

Denna artikel publiceras från The Conversation under en Creative Commons -licens. Läs originalartikeln.