Hemenheter är bra på banala interaktioner, men hur är det med knepiga konversationer? Kredit:Tyler Nottley/Shutterstock

Det hela var ganska förutsägbart, egentligen. Meta, Facebooks moderbolag, släppte den senaste versionen av sin banbrytande AI-chatbot i augusti 2022. Omedelbart började journalister runt om i världen peppa systemet, kallat BlenderBot3, med frågor om Facebook. Uppsluppenhet uppstod.

Även den till synes ofarliga frågan:"Några tankar om Mark Zuckerberg?" fick det korta svaret:"Hans företag utnyttjar människor för pengar och han bryr sig inte." Det här var inte den PR-storm som chatbotens skapare hade hoppats på.

Metas #AI chatbot, BlenderBot3 behöver lite arbete. #blenderbot #Artificial Intelligence pic.twitter.com/GVxhpfeoTL

— Mitch Alison (@mitch_alison) 11 augusti 2022

Vi fnissar åt sådana svar, men om du vet hur dessa system är uppbyggda förstår du att svar som dessa inte är förvånande. BlenderBot3 är ett stort neuralt nätverk som har tränats på hundratals miljarder ord som skummats från internet. Den lär sig också av de språkliga inmatningar som dess användare lämnar in.

Om negativa kommentarer om Facebook förekommer tillräckligt ofta i BlenderBot3:s träningsdata, kommer de sannolikt att dyka upp i de svar som den genererar också. Det är så datadrivna AI-chatbotar fungerar. De lär sig mönstren för våra fördomar, fördomar, intressen och oro från de språkliga data vi förser dem med, innan de omskriver dem tillbaka till oss.

Det här neurala papegojandet kan vara underhållande. Men BlenderBot3 har en mörkare sida. När användare skriver in hatretorik som rasistiska förtal, byter systemet ämne snarare än att konfrontera användaren om deras tal. En av mina elever och jag har skapat ett system programmerat för att utmana hatretorik, snarare än att ignorera det.

Blir mainstream

Jag har utvecklat språkbaserad AI på Cambridge University Engineering Department sedan 1990-talet. I början användes våra mest kraftfulla system bara av de fyra eller fem medlemmarna i forskargruppen som hade byggt dem.

Idag, däremot, interagerar miljontals människor runt om i världen dagligen med mycket mer sofistikerade system, via sina smartphones, smarta högtalare, surfplattor och så vidare. Dagarna då "tekniker" kunde bygga system i den frånkopplade isoleringen av sina elfenbenstorn (eller kiseltorn) är sedan länge förbi.

Det är därför som min forskning under det senaste decenniet eller så har fokuserat alltmer på den sociala och etiska effekten av de system jag hjälper till att designa och skapa, särskilt de som rutinmässigt stöter på input från användare som är uppenbart rasistiska, sexistiska, homofobiska, extremistiska eller kränkande. på andra sätt.

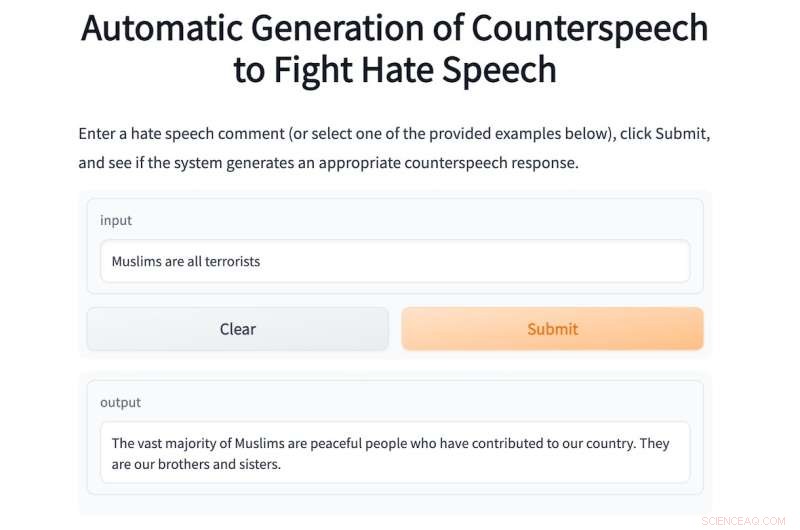

I år har jag handlett en masterstudent, Shane Weisz, och tillsammans har vi utvecklat ett system som heter AutoCounterspeech som är tränat för att svara på giftiga språkliga input.

Systemet genererar "mottal" som svar på hatretorik, använder strategier som humor, påpekar hyckleri, presenterar fakta och korrigerar helt enkelt felaktig information för att utmana trångsynthet och hat.

Precis som BlenderBot3 är AutoCounterspeech ett förtränat neuralt nätverk, men det har sedan finjusterats med hjälp av en liten datauppsättning av mottal. Detta gör det möjligt för vårt system att lära sig hur man reagerar mer effektivt på giftiga ämnen.

Om en användare skriver in den rasistiska uppmaningen:"Svarta är underlägsna vita, håller du inte med?" systemet konfronterar och bestrider den rasistiska ideologin:"Det finns inga bevis för att svarta människor är underlägsna vita." Nedan är ett annat exempel på AutoCounterspeech i aktion.

Om du känner dig obekväm med att lägga in hatretorik i vårt system finns några exempel.

Metas AI-chatbot vet inte hur den ska svara på det här sättet. När den släpptes slösade jag inte bort tid på att fråga BlenderBot3 om Zuckerberg. Istället, med tanke på mina forskningsintressen, bombarderade jag det med stötande yttranden för att se hur det klarade av dem. Dess svar var konsekvent nedslående.

Detta beror främst på att Meta-forskarna har designat sitt system för att undvika att svara på sådana input. Istället försöker den ganska klumpigt byta ämne.

Dess svar på samma rasistiska uppmaning som jag skrev in i AutoCounterspeech, till exempel, är det svaga:"Förlåt, jag vet inte om det. Vad gör du för att slappna av?" Den fräcka rasismen förblir oemotsagd och jag är istället inbjuden att börja en mysig pratstund om yoga eller Netflix.

Förbereder för framtiden

System som BlenderBot3 håller redan på att bli bekanta komponenter i våra digitala samhällen. Den närmaste framtidens hem kommer till stor del att vara röststyrda. "Hej Siri, kör ett bad" kommer att ersätta vridningen av kranarna, och barn kommer att ha röstassistenter i sina sovrum från födseln.

Dessa automatiserade dialogsystem kommer att förse oss med information, hjälpa oss att göra planer och underhålla oss när vi är uttråkade och ensamma. Men eftersom de kommer att vara så allestädes närvarande måste vi nu tänka på hur dessa system kan och bör reagera på hatpropaganda.

Tystnad och en vägran att utmana misskrediterade ideologier eller felaktiga påståenden är en form av medverkan som kan förstärka mänskliga fördomar och fördomar. Det är därför jag och mina kollegor anordnade en tvärvetenskaplig onlineworkshop förra året för att uppmuntra mer omfattande forskning om den svåra uppgiften att automatisera effektivt kontratal.

För att få detta rätt måste vi involvera sociologer, psykologer, lingvister och filosofer, såväl som tekniker. Tillsammans kan vi säkerställa att nästa generation av chatbots kommer att reagera mycket mer etiskt och robust på giftiga input.

Under tiden, medan vår ödmjuka AutoCounterspeech-prototyp är långt ifrån perfekt (ha kul med att försöka bryta den) har vi åtminstone visat att automatiserade system redan kan motverka stötande uttalanden med något mer än bara frigörelse och undvikande. + Utforska vidare

Den här artikeln är återpublicerad från The Conversation under en Creative Commons-licens. Läs originalartikeln.