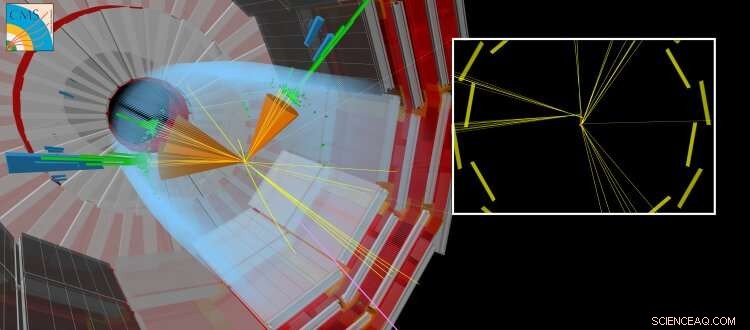

En simulerad CMS-kollision där en långlivad partikel produceras tillsammans med andra "vanliga" jetstrålar. Den långlivade partikeln färdas en kort sträcka innan den sönderfaller, skapar partiklar som verkar förskjutna från den punkt där LHC-strålarna kolliderade. Upphovsman:CERN

Nu för tiden, artificiella neurala nätverk har inverkan på många områden i vårt dagliga liv. De används för en mängd olika komplexa uppgifter, som att köra bil, utföra taligenkänning (t.ex. Siri, Cortana, Alexa), föreslå shoppingartiklar och trender, eller förbättra visuella effekter i filmer (t.ex. animerade karaktärer som Thanos från filmen Oändlighetskrig av Marvel).

Traditionellt, Algoritmer är handgjorda för att lösa komplexa uppgifter. Detta kräver att experter lägger ner betydande tid på att identifiera de optimala strategierna för olika situationer. Artificiella neurala nätverk – inspirerade av sammankopplade neuroner i hjärnan – kan automatiskt lära sig från data en nära optimal lösning för det givna målet. Ofta, den automatiserade inlärningen eller "utbildningen" som krävs för att få dessa lösningar "övervakas" genom användning av kompletterande information från en expert. Andra tillvägagångssätt är "oövervakade" och kan identifiera mönster i data. Den matematiska teorin bakom artificiella neurala nätverk har utvecklats under flera decennier, Ändå har vi först nyligen utvecklat vår förståelse för hur man tränar dem effektivt. De beräkningar som krävs är mycket lika de som utförs av vanliga videografikkort (som innehåller en grafikprocessor eller GPU) vid rendering av tredimensionella scener i videospel. Möjligheten att träna artificiella neurala nätverk på en relativt kort tid möjliggörs genom att utnyttja de massivt parallella beräkningsmöjligheterna för allmänna GPU:er. Den blomstrande videospelsindustrin har drivit utvecklingen av GPU:er. Detta framsteg, tillsammans med de betydande framstegen inom maskininlärningsteori och den ständigt ökande mängden digitaliserad information, har hjälpt till att inleda en tidsålder av artificiell intelligens och "djupinlärning".

Inom området högenergifysik, användningen av maskininlärningstekniker, som enkla neurala nätverk eller beslutsträd, har använts i flera decennier. På senare tid, teorin och experimentella samhällen vänder sig alltmer till de senaste teknikerna, såsom "djupa" neurala nätverksarkitekturer, för att hjälpa oss förstå den grundläggande naturen i vårt universum. Standardmodellen för partikelfysik är en sammanhängande samling fysiska lagar – uttryckta i matematikens språk – som styr de grundläggande partiklarna och krafterna, som i sin tur förklarar arten av vårt synliga universum. På CERN LHC, många vetenskapliga resultat fokuserar på sökandet efter nya "exotiska" partiklar som inte förutsägs av standardmodellen. Dessa hypotetiska partiklar är manifestationer av nya teorier som syftar till att svara på frågor som:varför består universum övervägande av materia snarare än antimateria, eller vad är mörk materias natur?

Figur 1:Schematisk över nätverksarkitekturen. De övre (orange och blå) sektionerna av diagrammet illustrerar komponenterna i nätverket som används för att särskilja strålar som produceras vid sönderfall av långlivade partiklar från strålar som produceras på annat sätt, tränas med simulerade data. Den nedre (gröna) delen av diagrammet visar komponenterna som tränas med hjälp av riktiga kollisionsdata. Upphovsman:CERN

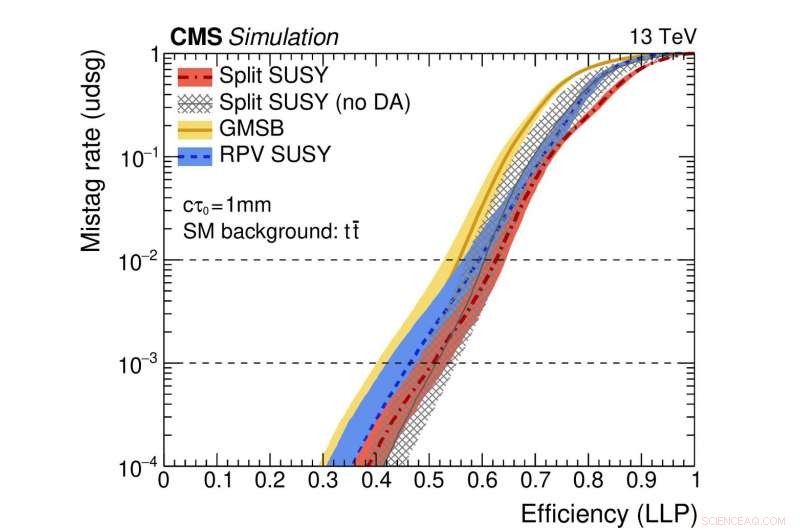

Figur 2:En illustration av nätverkets prestanda. De färgade kurvorna representerar prestanda för olika teoretiska supersymmetriska modeller. Den horisontella axeln ger effektiviteten för att korrekt identifiera en långlivad partikelsönderfall (dvs. den sanna-positiva hastigheten). Den vertikala axeln visar motsvarande falsk-positiva frekvens, vilket är den del av standardjetstrålar som felaktigt identifierats som härrörande från sönderfallet av en långlivad partikel. Som ett exempel, vi använder en punkt i den röda kurvan där fraktionen av äkta långlivade partiklar som är korrekt identifierade är 0,5 (dvs. 50%). Denna metod felidentifierar endast en vanlig jet av tusende av misstag som härrörande från ett långlivat partikelsönderfall. Upphovsman:CERN

Nyligen, sökningar efter nya partiklar som existerar mer än ett flyktigt ögonblick innan de sönderfaller till vanliga partiklar har fått särskild uppmärksamhet. Dessa "långlivade" partiklar kan färdas mätbara avstånd (fraktioner av millimeter eller mer) från proton-protonkollisionspunkten i varje LHC-experiment innan de förfaller. Ofta, teoretiska förutsägelser antar att den långlivade partikeln är oupptäckbar. Isåfall, endast partiklarna från sönderfallet av den oupptäckta partikeln kommer att lämna spår i detektorsystemen, leder till den ganska atypiska experimentella signaturen av partiklar som uppenbarligen dyker upp från ingenstans och förskjuts från kollisionspunkten.

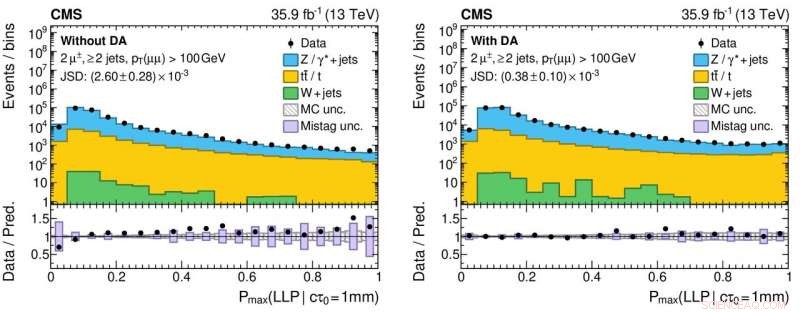

En ny aspekt av denna studie involverar användningen av data från verkliga kollisionshändelser, såväl som simulerade händelser, att träna nätverket. Detta tillvägagångssätt används eftersom simuleringen – även om den är mycket sofistikerad – inte uttömmande återger alla detaljer i de verkliga kollisionsdata. Särskilt, de strålar som härrör från långlivade partikelsönderfall är utmanande att simulera exakt. Effekten av att tillämpa denna teknik, kallad "domänanpassning, " är att informationen från det neurala nätverket överensstämmer med en hög nivå av noggrannhet för både verkliga och simulerade kollisionsdata. Detta beteende är en avgörande egenskap för algoritmer som kommer att användas av sökningar efter sällsynta nyfysikprocesser, eftersom algoritmerna måste visa robusthet och tillförlitlighet när de tillämpas på data.

Figur 3:Histogram av utdatavärdena från det neurala nätverket för verkliga (svarta cirkulära markörer) och simulerade (färgade fyllda histogram) proton-protonkollisionsdata utan (vänster panel) och med (höger panel) tillämpning av domänanpassning. De nedre panelerna visar förhållandet mellan antalet verkliga data och simulerade händelser som erhållits från varje histogramfack. Förhållandena är betydligt närmare enhet för den högra panelen, vilket indikerar en förbättrad förståelse av det neurala nätverkets prestanda för verkliga kollisionsdata, vilket är avgörande för att minska falskt positiva (och falskt negativa!) vetenskapliga resultat när man söker efter exotiska nya partiklar. Upphovsman:CERN

CMS Collaboration kommer att distribuera detta nya verktyg som en del av sitt pågående sökande efter exotiska, långlivade partiklar. Denna studie är en del av en större, samordnade ansträngningar över alla LHC-experiment för att använda modern maskinteknik för att förbättra hur de stora dataproverna registreras av detektorerna och den efterföljande dataanalysen. Till exempel, användningen av domänanpassning kan göra det lättare att distribuera robusta maskininlärda modeller som en del av framtida resultat. Erfarenheterna från dessa typer av studier kommer att öka fysikpotentialen under Run 3, från 2021, och vidare med High Luminosity LHC.