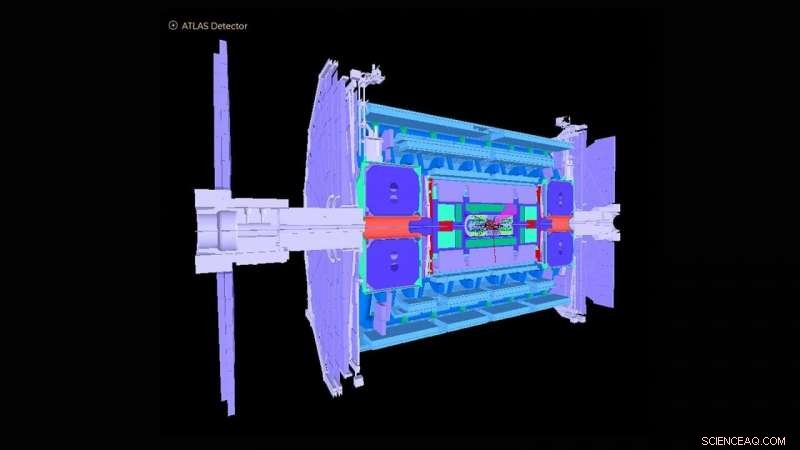

Schemat över ATLAS -detektorn i Large Hadron Collider. Upphovsman:ATLAS Collaboration

The Large Hadron Collider (LHC) nära Genève, Schweiz blev känt runt om i världen 2012 med upptäckten av Higgs boson. Observationen markerade en avgörande bekräftelse på standardmodellen för partikelfysik, som organiserar de subatomära partiklarna i grupper som liknar element i det periodiska systemet från kemi.

US Department of Energy's (DOE) Argonne National Laboratory har gjort många viktiga bidrag till konstruktionen och driften av ATLAS -experimentdetektorn vid LHC och till analysen av signaler som registrerats av detektorn som avslöjar den underliggande fysiken för partikelkollisioner. Argonne spelar nu en ledande roll i uppgraderingen med hög ljusstyrka av ATLAS-detektorn för operationer som planeras att börja 2027. För detta ändamål, ett team av Argonne-fysiker och beräkningsvetare har tagit fram en maskininlärningsbaserad algoritm som approximerar hur den aktuella detektorn skulle reagera på de kraftigt ökade data som förväntas med uppgraderingen.

Som den största fysikmaskinen som någonsin byggts, LHC skjuter två strålar av protoner i motsatta riktningar runt en 17 mil lång ring tills de närmar sig ljusets hastighet, krossar dem och analyserar kollisionsprodukterna med gigantiska detektorer som ATLAS. ATLAS-instrumentet är ungefär lika högt som en sexvåningshus och väger cirka 7, 000 ton. I dag, LHC fortsätter att studera Higgs boson, samt ta upp grundläggande frågor om hur och varför materia i universum är som det är.

"De flesta av forskningsfrågorna på ATLAS handlar om att hitta en nål i en gigantisk höstack, där forskare bara är intresserade av att hitta en händelse som inträffar bland en miljard andra, "sa Walter Hopkins, assisterande fysiker i Argonnes division High Energy Physics (HEP).

Som en del av LHC -uppgraderingen, ansträngningar görs nu för att öka LHC:s ljusstyrka-antalet proton-till-proton-interaktioner per kollision mellan de två protonstrålarna-med en faktor fem. Detta kommer att producera cirka 10 gånger mer data per år än vad som för närvarande förvärvas av LHC -experimenten. Hur väl detektorerna reagerar på denna ökade händelsehastighet måste fortfarande förstås. Detta kräver körning av högpresterande datasimuleringar av detektorerna för att noggrant bedöma kända processer som härrör från LHC-kollisioner. Dessa storskaliga simuleringar är dyra och kräver stora bitar av datortid på världens bästa och mest kraftfulla superdatorer.

Argonne-teamet har skapat en maskininlärningsalgoritm som kommer att köras som en preliminär simulering innan några fullskaliga simuleringar. Denna algoritm approximerar, på mycket snabba och billigare sätt, hur den aktuella detektorn skulle reagera på de kraftigt ökade data som förväntas med uppgraderingen. Det innebär simulering av detektorsvar på ett partikel-kollisionsexperiment och rekonstruktion av objekt från de fysiska processerna. Dessa rekonstruerade föremål inkluderar strålar eller sprayer av partiklar, liksom enskilda partiklar som elektroner och muoner.

"Upptäckten av ny fysik vid LHC och på andra ställen kräver allt mer komplexa metoder för stordataanalyser, "sa Doug Benjamin, en beräkningsvetare inom HEP. "Dessa dagar betyder det vanligtvis att man använder maskininlärning och andra tekniker för artificiell intelligens."

De tidigare använda analysmetoderna för initiala simuleringar har inte använt maskininlärningsalgoritmer och är tidskrävande eftersom de involverar manuell uppdatering av experimentella parametrar när förhållandena vid LHC ändras. Vissa kanske också missar viktiga datakorrelationer för en given uppsättning ingångsvariabler till ett experiment. Den Argonne-utvecklade algoritmen lär sig, i realtid medan ett utbildningsförfarande tillämpas, de olika funktionerna som behöver introduceras genom detaljerade fullständiga simuleringar, och därigenom undviker behovet av att tillverka experimentella parametrar. Metoden kan också fånga komplexa ömsesidiga beroende av variabler som inte tidigare varit möjliga.

"Med vår avskalade simulering, du kan lära dig grunderna till relativt liten beräkningskostnad och tid, då kan du mycket mer effektivt fortsätta med fullständiga simuleringar vid ett senare tillfälle, "sa Hopkins." Vår maskininlärningsalgoritm ger också användare en bättre diskriminerande kraft om var de ska leta efter nya eller sällsynta händelser i ett experiment, " han lade till.

Lagets algoritm kan visa sig vara ovärderlig inte bara för ATLAS, men för de flera experimentella detektorerna vid LHC, liksom andra partikelfysiska experiment som nu utförs runt om i världen.

Den här studien, med titeln "Automatiserad detektorsimulering och parametrisering av rekonstruktion med hjälp av maskininlärning, "dök upp i Journal of Instrumentation .