Kredit:OpenAI

Väl, så mycket för ett antagande som nu låter för lätt att acceptera – att den magnifika mänskliga hjärnan har det över en maskin vilken dag som helst. Verkligen? Tolkar vi världen mer exakt än vad ett "konvolutionellt neuralt nätverk" kan?

Som Even Ackerman påpekade, "när ett CNN [konvolutionellt neuralt nätverk] presenteras med en bild, den tittar på ett statiskt rutnät av rektangulära pixlar."

Vi tittar på bilder och ser dem korrekt, såsom människor och djur; CNN ser på saker mer som datorer.

Ett forskarlag ställer frågor om lätta antaganden, dock. De undersöker vad som händer med motstridiga exempel när det gäller människor.

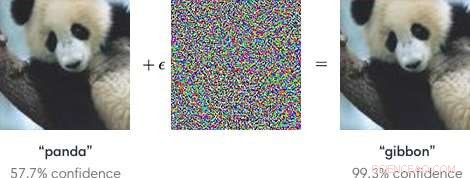

Indata till maskininlärningsmodeller utformade för att få modellerna att göra ett misstag är "motstridiga exempel". Motstridiga exempel, som sådan, kan vara farligt.

Enkelt uttryckt, "Modstridiga exempel är skadliga inmatningar utformade för att lura maskininlärningsmodeller, " enligt en Google Research-sida.

Som ett blogginlägg i OpenAI förklarade, angripare kan rikta in sig på autonoma fordon genom att använda klistermärken eller färg för att skapa en motstridig stoppskylt som fordonet skulle tolka som en "vika" eller annan skylt.

Forskarna, när man talar om maskininlärningsmodeller som sårbara för motstridiga exempel, noterade att små förändringar i bilder kan göra att datorseendemodeller gör misstag, som att identifiera en skolbuss som en struts.

Bloggen från OpenAI hänvisade till motstridiga exempel som representerar ett konkret problem inom AI-säkerhet.

Med det sagt, hur är det med motstridiga exempel som lurar människor? Kan det hända?

Laget, sa Even Ackerman in IEEE spektrum , "beslutade att försöka ta reda på om samma tekniker som lurar artificiella neurala nätverk också kan lura de biologiska neurala nätverken inuti våra huvuden."

Forskningsuppsatsen som beskriver deras arbete är "Motstridiga exempel som lurar både mänskliga och datorseende, " på arXiv.

"Här, vi skapar de första kontradiktoriska exemplen utformade för att lura människor, " skrev de. De fann att "motstridiga exempel som starkt överförs över datorseendemodeller påverkar klassificeringarna som görs av tidsbegränsade mänskliga observatörer." (Ackerman noterade att i studien, människor hade bara mellan 60 och 70 millisekunder på sig att titta på varje bild och fatta ett beslut.)

IEEE spektrum Even Ackerman diskuterade vad de gjorde och presenterade en uppsättning med två bilder från Google Brain för att stödja hans förklaring.

Ackerman visade "en bild på en katt till vänster. Till höger, kan du se om det är en bild på samma katt, eller en bild på en liknande hund? Skillnaden mellan de två bilderna är att den till höger har justerats lite av en algoritm för att göra det svårt för en typ av datormodell som kallas ett konvolutionellt neuralt nätverk (CNN) att kunna säga vad det egentligen är. I detta fall, CNN tror att det tittar på en hund snarare än en katt, men det som är anmärkningsvärt är att de flesta tycker samma sak."

Vad? Hur kan människor göra samma misstag? Ackerman sa att det kan vara möjligt att rikta utvecklingen av en motståndsbild mot människor "genom att välja modeller som matchar det mänskliga visuella systemet så nära som möjligt."

Men vad är det egentligen som bråkar med människans förmåga att vara korrekt? Ackerman sa att forskarna påpekade att "våra motstridiga exempel är utformade för att lura mänsklig uppfattning, så vi bör vara försiktiga med att använda subjektiv mänsklig uppfattning för att förstå hur de fungerar."

Han sa att de var villiga att göra några generaliseringar "om några olika kategorier av ändringar, inklusive "störa objektkanter, speciellt genom mellanfrekvensmodulationer vinkelrätt mot kanten; förbättra kanterna både genom att öka kontrasten och skapa texturgränser; modifierande textur; och dra nytta av mörka områden i bilden, där den perceptuella omfattningen av små störningar kan vara större."

Hur de testade:Försökspersoner med normal eller korrigerad syn deltog i experimentet.

"För varje grupp, en framgångsrik motståndarbild kunde lura människor att välja fel medlem i gruppen, genom att identifiera den som en hund när det faktiskt är en katt, eller tvärtom, sa Ackerman.

Försökspersonerna ombads klassificera bilder som visades på skärmen genom att trycka på knappar på en svarstidsruta, sa författarna.

Ackerman skrev, "Den korta tiden som bilden visades mildrade skillnaden mellan hur CNN uppfattar världen och hur människor gör."

Experimentet involverade tre grupper av bilder:husdjur (katter och hundar), grönsaker (kål och broccoli), och "fara" (spindlar och ormar).

Ackermans kommentar till forskningsresultaten var att "det finns överlappning mellan perceptuell manipulation av CNN och manipulation av människor. Det betyder att maskininlärningstekniker potentiellt kan användas för att subtilt ändra saker som bilder eller videor på ett sätt som kan förändra vår uppfattning om (och reaktion på) dem utan att vi någonsin insåg vad som pågick."

Han tillade att "vi måste vara försiktiga, och kom ihåg att precis som de där datorerna, sometimes we're far too easy to fool."

"Adversarial Examples that Fool both Human and Computer Vision" is by Gamaleldin F. Elsayed, Shreya Shankar, Brian Cheung, Nicolas Papernot, Alex Kurakin, Ian Goodfellow, and Jascha Sohl-Dickstein, on arXiv.

© 2018 Tech Xplore