Upphovsman:Queensland University of Technology

QUT -forskare har utvecklat ett nytt sätt för robotar att se världen ur ett mer mänskligt perspektiv, som har potential att förbättra hur teknik, t.ex. förarlösa bilar och industriella och mobila robotar, fungerar och interagerar med människor.

I det som antas vara en världens första, Ph.D. student Sourav Garg, Dr Niko Suenderhauf och professor Michael Milford från QUT:s vetenskapliga och tekniska fakultet och Australian Center for Robotic Vision, har använt visuell semantik för att möjliggöra högpresterande platsigenkänning från motsatta synpunkter.

Herr Garg sa, medan människor hade en anmärkningsvärd förmåga att känna igen en plats när de kom in igen från motsatt håll, inklusive under omständigheter där det finns extrema variationer i dess utseende, uppgiften hade gett utmaningar för robotar och autonoma fordon.

"Till exempel, om en person kör på en väg och de gör en u-sväng och går tillbaka ner på samma väg, åt motsatt håll, de har förmågan att veta var de är, baserat på den tidigare erfarenheten, eftersom de känner igen viktiga aspekter av miljön. Människor kan också göra det om de reser samma väg på natten, och sedan igen under dagtid, eller under olika årstider, "Sa Garg.

"Tyvärr, det är inte så enkelt för robotar. Nuvarande konstruerade lösningar, som de som används av förarlösa bilar, förlitar sig till stor del på panoramakameror eller 360 graders ljusdetektering och avståndsavkänning (LIDAR). Även om detta är effektivt, det är väldigt annorlunda än hur människor naturligt navigerar.

Upphovsman:neyro2008 / Alexander Zelnitskiy / 123rf.com / författare

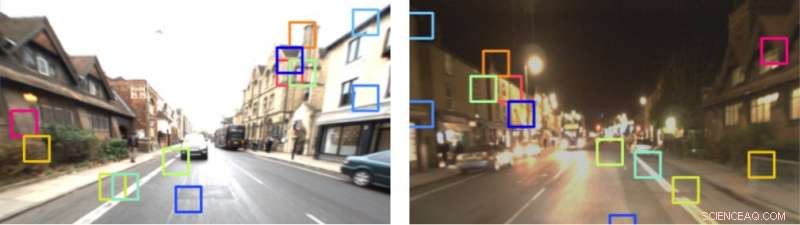

Professor Michael Milford sa att det system som föreslogs av QUT-teamet av forskare använde ett toppmodernt semantiskt segmenteringsnätverk, kallas RefineNet, utbildad på Cityscapes Dataset, att bilda en Local Semantic Tensor (LoST) beskrivningsbild av bilder. Detta användes sedan för att utföra platsigenkänning tillsammans med ytterligare robotvisionstekniker baserade på kontroller av rumslig layout och viktad knapptryckningsmatchning.

"Vi ville replikera processen som används av människor. Visuell semantik fungerar genom att inte bara känna, men förstå var viktiga objekt finns i miljön, och detta möjliggör större förutsägbarhet i de åtgärder som följer, "Sade professor Milford.

"Vårt tillvägagångssätt gör det möjligt för oss att matcha platser från motsatta synpunkter med liten gemensam visuell överlappning och över dag-natt-cykler. Vi utökar nu detta arbete för att hantera både motsatta synpunkter och lateral synvinkeländring, som inträffar, till exempel, när ett fordon byter körfält. Detta ger en extra svårighetsgrad. "

Kredit:1 år, 1000 km:The Oxford RobotCar Dataset

Forskargruppens uppsats har accepterats för publicering i Robotik:Vetenskap och system , den mest selektiva internationella robotkonferensen, som hålls vid Carnegie Mellon University i Pittsburgh den här månaden.