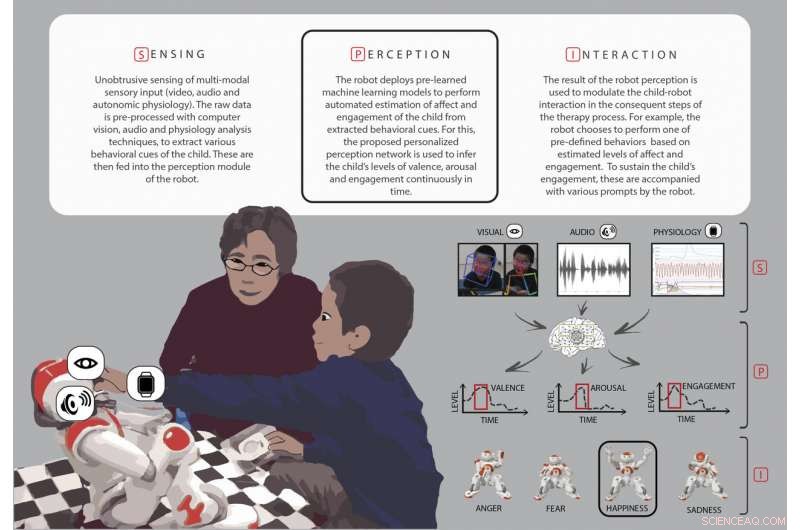

Översikt över nyckelstadierna (avkänning, uppfattning, och interaktion) under robotassisterad autismterapi. Kredit:Rudovic et al., Sci. Robot . 3, eaao6760 (2018)

Barn med autismspektrumtillstånd har ofta problem med att känna igen de känslomässiga tillstånden hos människor runt omkring dem – att skilja ett lyckligt ansikte från ett rädda ansikte, till exempel. För att råda bot på detta, vissa terapeuter använder en barnvänlig robot för att visa dessa känslor och för att engagera barnen i att imitera känslorna och svara på dem på lämpliga sätt.

Denna typ av terapi fungerar bäst, dock, om roboten smidigt kan tolka barnets eget beteende - oavsett om han eller hon är intresserad och upphetsad eller uppmärksam - under behandlingen. Forskare vid MIT Media Lab har nu utvecklat en typ av personlig maskininlärning som hjälper robotar att uppskatta engagemanget och intresset för varje barn under dessa interaktioner, använder data som är unika för det barnet.

Beväpnad med detta personliga "deep learning"-nätverk, robotarnas uppfattning om barnens svar överensstämde med bedömningar av mänskliga experter, med en korrelationspoäng på 60 procent, forskarna rapporterar 27 juni in Science Robotics .

Det kan vara utmanande för mänskliga observatörer att nå höga nivåer av enighet om ett barns engagemang och beteende. Deras korrelationspoäng är vanligtvis mellan 50 och 55 procent. Rudovic och hans kollegor föreslår att robotar som är tränade på mänskliga observationer, som i denna studie, skulle en dag kunna ge mer konsekventa uppskattningar av dessa beteenden.

"Det långsiktiga målet är inte att skapa robotar som kommer att ersätta mänskliga terapeuter, men för att förstärka dem med nyckelinformation som terapeuterna kan använda för att anpassa terapiinnehållet och även skapa mer engagerande och naturalistiska interaktioner mellan robotarna och barn med autism, " förklarar Oggi Rudovic, postdoc vid Medialab och första författare till studien.

Rosalind Picard, en medförfattare på tidningen och professor vid MIT som leder forskning inom affektiv datorer, säger att personalisering är särskilt viktig i autismterapi:Ett känt ordspråk är, "Om du har träffat en person, med autism, du har träffat en person med autism."

"Utmaningen att skapa maskininlärning och AI [artificiell intelligens] som fungerar vid autism är särskilt irriterande, eftersom de vanliga AI-metoderna kräver mycket data som är liknande för varje kategori som lärs in. I autism där heterogenitet råder, de normala AI-metoderna misslyckas, säger Picard. Rudovic, Picard, och deras lagkamrater har också använt personlig djupinlärning på andra områden, upptäcker att det förbättrar resultaten för smärtövervakning och för att förutsäga Alzheimers sjukdomsprogression.

Möte NAO

Robotassisterad terapi för autism fungerar ofta ungefär så här:En mänsklig terapeut visar ett barn foton eller flashkort av olika ansikten som är avsedda att representera olika känslor, att lära dem hur man känner igen uttryck av rädsla, sorg, eller glädje. Terapeuten programmerar sedan roboten att visa samma känslor för barnet, och observerar barnet när hon eller han interagerar med roboten. Barnets beteende ger värdefull feedback som roboten och terapeuten behöver för att gå vidare med lektionen.

Forskarna använde SoftBank Robotics NAO humanoid robotar i denna studie. Nästan 2 fot lång och liknar en pansrad superhjälte eller en droid, NAO förmedlar olika känslor genom att ändra ögonfärg, dess lemmars rörelse, och tonen i dess röst.

De 35 barn med autism som deltog i denna studie, 17 från Japan och 18 från Serbien, varierade i ålder från 3 till 13. De reagerade på olika sätt mot robotarna under sina 35-minuterspass, från att se uttråkad och sömnig ut i vissa fall till att hoppa runt i rummet med spänning, klappar i händerna, och skrattar eller rör vid roboten.

De flesta barnen i studien reagerade på roboten "inte bara som en leksak utan relaterade till NAO respektfullt som om det var en riktig person, "särskilt under berättande, där terapeuterna frågade hur NAO skulle känna om barnen tog roboten på en glassgodis, enligt Rudovic.

En 4-årig flicka gömde sig bakom sin mamma när hon deltog i sessionen men blev mycket mer öppen för roboten och slutade med att skratta i slutet av terapin. Systern till ett av de serbiska barnen gav NAO en kram och sa "Robot, Jag älskar dig!" i slutet av en session, sa att hon var glad över att se hur mycket hennes bror tyckte om att leka med roboten.

"Terapeuter säger att det kan vara en stor utmaning för dem att engagera barnet i några sekunder. och robotar lockar barnets uppmärksamhet, säger Rudovic, förklara varför robotar har varit användbara i denna typ av terapi. "Också, människor ändrar sina uttryck på många olika sätt, men robotarna gör det alltid på samma sätt, och detta är mindre frustrerande för barnet eftersom barnet lär sig på ett mycket strukturerat sätt hur uttrycken kommer att visas."

Personligt maskininlärning

MIT-forskargruppen insåg att en sorts maskininlärning som kallas djupinlärning skulle vara användbar för terapirobotarna att ha, att uppfatta barnens beteende mer naturligt. Ett djupinlärningssystem använder hierarkiska, flera lager av databehandling för att förbättra sina uppgifter, med varje efterföljande lager som motsvarar en något mer abstrakt representation av den ursprungliga rådatan.

Även om begreppet djupinlärning har funnits sedan 1980 -talet, säger Rudovic, det är först nyligen att det har funnits tillräckligt med datorkraft för att implementera denna typ av artificiell intelligens. Deep learning har använts i automatiska tal- och objektigenkänningsprogram, vilket gör den väl lämpad för ett problem som att förstå de många funktionerna i ansiktet, kropp, och röst som går till att förstå ett mer abstrakt begrepp som ett barns engagemang.

"När det gäller ansiktsuttryck, till exempel, vilka delar av ansiktet är viktigast för uppskattning av engagemang?" säger Rudovic. "Djup inlärning gör att roboten kan extrahera den viktigaste informationen direkt från den datan utan att människor behöver skapa dessa funktioner manuellt." För terapirobotarna , Rudovic och hans kollegor tog idén om djupinlärning ett steg längre och byggde ett personligt ramverk som kunde lära sig av data som samlats in om varje enskilt barn. Forskarna filmade varje barns ansiktsuttryck, huvud- och kroppsrörelser, poser och gester, ljudinspelningar och data om hjärtfrekvens, kroppstemperatur, och hudsvettrespons från en monitor på barnets handled.

Robotarnas personliga nätverk för djupinlärning byggdes av lager av denna video, audio, och fysiologiska data, information om barnets autismdiagnos och förmågor, deras kultur och deras kön. Forskarna jämförde sedan sina uppskattningar av barnens beteende med uppskattningar från fem mänskliga experter, vem kodade barnens video- och ljudinspelningar i en kontinuerlig skala för att avgöra hur nöjda eller upprörda, hur intresserad, och hur engagerat barnet verkade under passet.

Utbildad på dessa personliga data kodade av människor, och testade på data som inte används vid träning eller justering av modellerna, nätverken förbättrade avsevärt robotens automatiska uppskattning av barnets beteende för de flesta av barnen i studien, utöver vad som skulle uppskattas om nätverket kombinerade alla barns data i en "one-size-fits-all"-metod, fann forskarna.

Rudovic och kollegor kunde också undersöka hur nätverket för djupinlärning gjorde sina uppskattningar, som avslöjade några intressanta kulturella skillnader mellan barnen. "Till exempel, barn från Japan visade fler kroppsrörelser under episoder av högt engagemang, medan stora kroppsrörelser hos serber var förknippade med episoder av frigörelse, säger Rudovic.