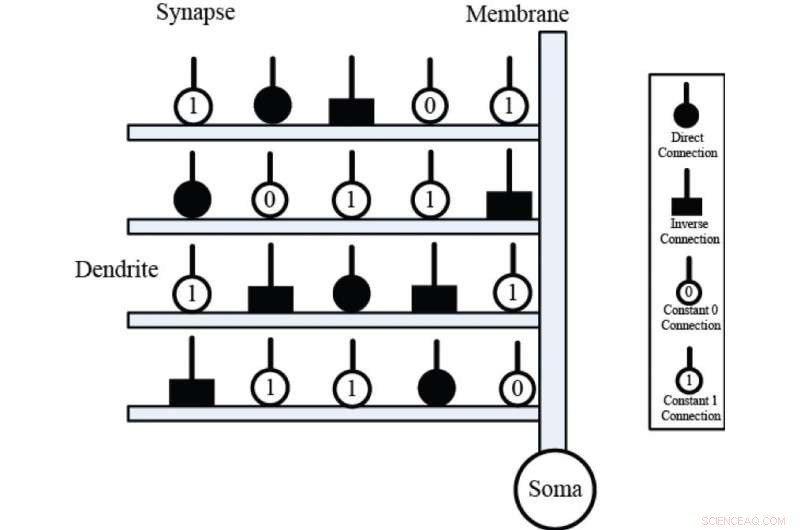

Axoner av presynaptiska neuroner (ingång X) ansluter till grenar av dendriter (horisontella rektanglar) genom synaptiska lager; membranskiktet (vertikala rektanglar) summerar de dendritiska aktiveringarna, och överför summan till somakroppen (svart sfär). Synaptiska lager har fyra olika anslutningsfall, nämligen, den direkta anslutningen, den omvända kopplingen, den konstanta 0-anslutningen och den konstanta 1-anslutningen. Kredit:Kanazawa University

Artificiella neurala nätverk är maskininlärningssystem som består av ett stort antal anslutna noder som kallas artificiella neuroner. I likhet med neuronerna i en biologisk hjärna, dessa artificiella neuroner är de primära grundläggande enheterna som används för att utföra neurala beräkningar och lösa problem. Framsteg inom neurobiologi har illustrerat den viktiga roll som dendritiska cellstrukturer spelar i neurala beräkningar, och detta har lett till utvecklingen av artificiella neuronmodeller baserade på dessa strukturer.

Den nyligen utvecklade approximativa logiska neuronmodellen (ALNM) är en enda neural modell som har en dynamisk dendritisk struktur. ALNM kan använda en neural beskärningsfunktion för att eliminera onödiga dendritgrenar och synapser under träning för att lösa ett specifikt problem. Den resulterande förenklade modellen kan sedan implementeras i form av en hårdvarulogikkrets.

Dock, den välkända backpropagation (BP)-algoritmen som användes för att träna ALMN begränsade faktiskt neuronmodellens beräkningskapacitet. "BP-algoritmen var känslig för initiala värden och kunde lätt fångas in i lokala minima, " säger motsvarande författare Yuki Todo vid Kanazawa Universitys fakultet för elektro- och datorteknik. "Vi utvärderade därför kapaciteten hos flera heuristiska optimeringsmetoder för utbildning av ALMN."

Efter en rad experiment, algoritmen för tillståndssökning (SMS) valdes ut som den lämpligaste träningsmetoden för ALMN. Sex benchmark-klassificeringsproblem användes sedan för att utvärdera ALNM:s optimeringsprestanda när den tränades med hjälp av SMS som en inlärningsalgoritm, och resultaten visade att SMS gav överlägsen träningsprestanda jämfört med BP och de andra heuristiska algoritmerna när det gäller både noggrannhet och konvergenshastighet.

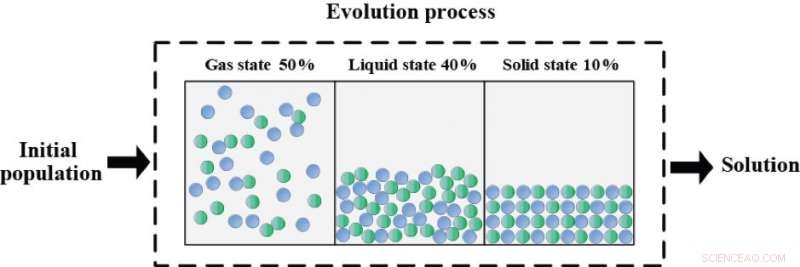

Evolutionsprocessen för sökning av materia tillstånd (SMS) är baserade på den fysiska principen om termisk-energirörelseförhållandet. Hela optimeringsprocessen är uppdelad i följande tre faser:gastillståndet (50 procent), det flytande tillståndet (40 procent) och det fasta tillståndet (10 procent). Varje stat har sin egen verksamhet med olika prospekterings-exploatering-förhållanden. Gastillståndet är en ren prospektering i början av optimeringsprocessen. Det flytande tillståndet besitter samtidigt prospekterings- och exploateringssökningen, och solid state fokuserar på exploateringen helt enkelt i den senare delen av optimeringsprocessen. Algoritmen som optimeras på detta sätt kan uppnå en lämplig balans mellan utforskning och exploatering. Kredit:Kanazawa University

"En klassificerare baserad på ALNM och SMS jämfördes också med flera andra populära klassificeringsmetoder, " säger docent Todo, "och de statistiska resultaten verifierade denna klassificerares överlägsenhet på dessa benchmarkproblem."

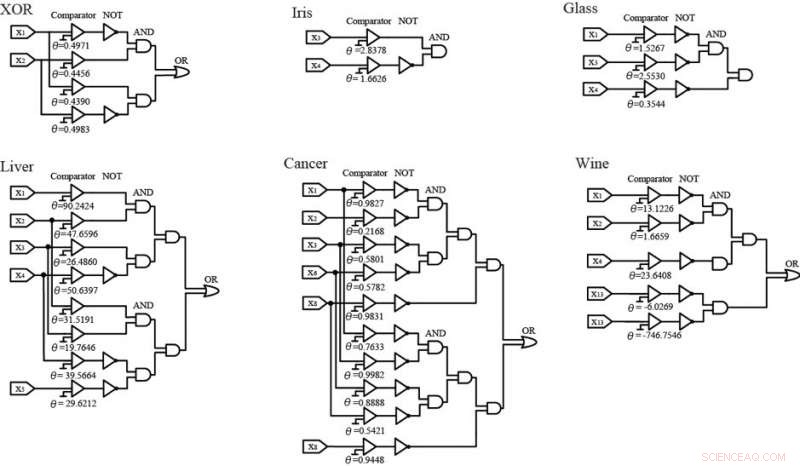

Under utbildningsprocessen, ALNM förenklade neurala modeller genom synaptisk beskärning och dendritiska beskärningsprocedurer, och de förenklade strukturerna ersattes sedan med hjälp av logiska kretsar. Dessa kretsar gav också tillfredsställande klassificeringsnoggrannhet för vart och ett av benchmarkproblemen. Den enkla hårdvaruimplementeringen av dessa logikkretsar tyder på att framtida forskning kommer att se ALNM och SMS användas för att lösa allt mer komplexa och högdimensionella verkliga problem.

ALNM kan förenkla de neurala modellerna genom synaptisk beskärning och dendritisk beskärning under träningsprocessen. Sedan, de förenklade strukturerna av ALNM kan ersättas av logiska kretsar, som bara består av "jämförarna" och logiken INTE, OCH- och ELLER-grindar. Bland dem, 'komparatorn' fungerar som en analog-till-digital-omvandlare som jämför ingången med tröskelvärdet θ. Om ingången X överskrider tröskeln θ, 'jämföraren' kommer att mata ut 1. Annars, den kommer att mata ut 0. När den är implementerad på hårdvara, dessa logiska kretsar kan användas som effektiva klassificerare för att lösa de sex benchmarkproblemen. Kredit:Kanazawa University