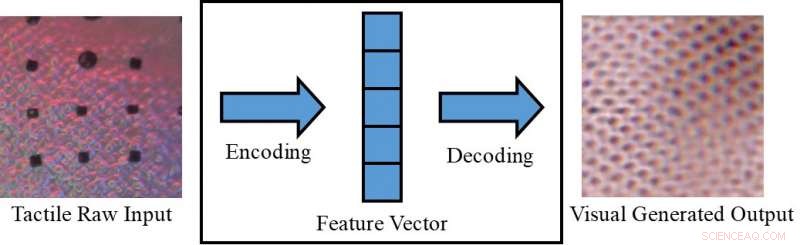

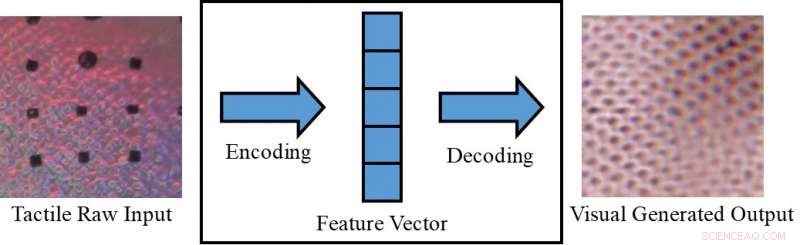

Konvertering av en taktil bild till en visuell bild. Kredit:Lee, Bollegala &Luo.

Att uppfatta ett objekt endast visuellt (t.ex. på en skärm) eller endast genom att röra vid det, kan ibland begränsa vad vi kan dra slutsatser om det. Människor, dock, har den medfödda förmågan att integrera visuella och taktila stimuli, utnyttja alla sensoriska data som finns tillgängliga för att slutföra sina dagliga uppgifter.

Forskare vid University of Liverpool har nyligen föreslagit ett nytt ramverk för att generera tvärmodala sensoriska data, som skulle kunna hjälpa till att replikera både visuell och taktil information i situationer där en av de två inte är direkt tillgänglig. Deras ramar skulle kunna, till exempel, tillåta människor att uppfatta föremål på en skärm (t.ex. klädesplagg på e-handelssajter) både visuellt och taktiskt.

"I vår dagliga erfarenhet, vi kan kognitivt skapa en visualisering av ett objekt baserat på en taktil respons, eller en taktil reaktion från att titta på en ytas struktur, "Dr Shan Luo, en av forskarna som genomförde studien, berättade för TechXplore. "Detta perceptuella fenomen, kallas synestesi, där stimulering av ett sinne orsakar en ofrivillig reaktion i ett eller flera av de andra sinnena, kan användas för att skapa en otillgänglig mening. Till exempel, när man tar tag i ett föremål, vår syn kommer att hindras av handen, men ett peksvar kommer att genereras för att "se" motsvarande funktioner."

Det perceptuella fenomenet som beskrivs av Dr. Luo uppstår vanligtvis när en perceptionskälla inte är tillgänglig (t.ex. när du rör vid föremål i en väska utan att kunna se dem). I sådana situationer, människor kan "röra för att se" eller "se för att känna, " tolka egenskaper relaterade till ett visst sinne baserat på information som samlats in med hjälp av deras andra sinnen. Om de replikeras i maskiner, denna visuellt-taktila mekanism kan ha flera intressanta tillämpningar, särskilt inom robotteknik och e-handel.

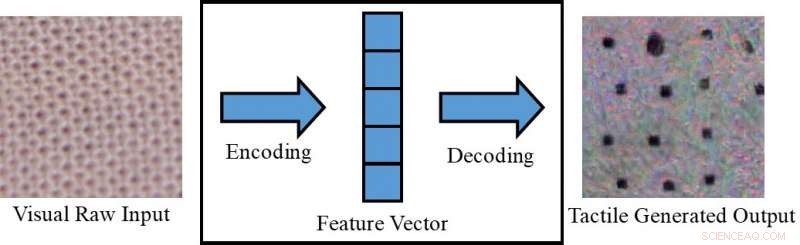

Konvertering av en visuell bild till en taktil bild. Kredit:Lee, Bollegala &Luo.

Om robotar kunde integrera visuell och taktil perception, de skulle kunna planera sina grepp- och manipulationsstrategier mer effektivt baserat på de visuella egenskaperna hos de föremål som de arbetar med (t.ex. form, storlek, etc.). Med andra ord, robotar skulle uppfatta objektens övergripande taktila egenskaper innan de greppade dem, med hjälp av visuell information som samlats in av kameror. När du tar tag i ett föremål utanför kamerans synfält, å andra sidan, de skulle använda taktila svar för att kompensera för bristen på tillgänglig visuell information.

Om den paras ihop med en taktil enhet, som ännu inte har utvecklats, det ramverk som Dr. Luo och hans kollegor föreslagit skulle också kunna användas inom e-handel, till exempel, låta kunderna känna på tyget innan de köper dem. Med denna applikation i åtanke, forskarna använde villkorliga generativa motstridiga nätverk för att generera pseudo-visuella bilder med taktil data och vice versa (dvs. för att generera taktila utdata med visuell data).

"På onlinemarknadsplatser, kunder handlar genom att se bilder på kläder eller andra föremål, " sa doktor Luo. "Men, de kan inte röra dessa föremål för att känna på deras material. Att känna en vara är ganska viktig när du handlar, speciellt när du köper ömtåliga föremål, såsom underkläder. Låter användarna känna saker hemma, använda en taktil enhet som ännu inte har utvecklats, det tvärmodala systemet för generering av sensorisk data som föreslås i vår artikel kan hjälpa e-handelskunder att göra mer välgrundade val."

Dr. Luo och hans kollegor utvärderade sin modell på VITac-dataset, som innehåller makrobilder och taktila avläsningar (fångade med en GelSight-sensor) av 100 olika typer av tyg. De fann att det effektivt kunde förutsäga sensoriska utsignaler för ett sinne (d.v.s. syn eller beröring) med hjälp av data som är relevanta för den andra.

GelSight sensor. Kredit:Lee, Bollegala &Luo.

"Vi tar texturuppfattning som ett exempel:visuella indatabilder av en tygtextur används för att generera en pseudotaktil läsning av samma tygstycke; omvänt, taktila avläsningar av ett tyg används för att förutsäga en visuell bild av samma tyg, Dr. Luo förklarade. "Tygernas struktur, dvs. garnfördelningsmönstren, visas på liknande sätt i en visuell bild och en tryckfördelning (dvs. taktil) avläsning. Dock, detta arbete kan också utökas för att åstadkomma tvärmodal visuell-taktil datagenerering för uppfattningen av andra objektegenskaper, genom att överväga skillnaderna mellan de två domänerna."

Studien utförd av Dr. Luo och hans kollegor gav anmärkningsvärda resultat i att generera realistiska taktila och visuella mönster för olika tyger i frånvaro av taktil eller visuell information, följaktligen. Med hjälp av deras ramverk, forskarna lyckades "replikera" taktila element av tyger med hjälp av visuella data, och vice versa.

"Såvitt vi vet, detta arbete är det första försöket att uppnå robotisk cross-modal visuell-taktil datagenerering, som också kan utvidgas till att generera gränsöverskridande data för andra modaliteter, "Dr Luo sa. "De praktiska konsekvenserna av vår studie är att vi kan använda andra sinnen för att hitta på en otillgänglig mening."

I framtiden, det ramverk som Dr. Luo och hans kollegor föreslagit skulle kunna användas för att förbättra grepp- och manipulationsstrategier i robotar, samt att förbättra online shoppingupplevelser. Deras metod kan också användas för att utöka datamängder för klassificeringsuppgifter, genom att generera sensoriska data som annars skulle vara otillgängliga.

Kredit:Lee, Bollegala &Luo.

"I framtida forskning, vi kommer att försöka tillämpa vår metod på ett antal olika uppgifter, såsom visuell och taktil klassificering i en verklig miljö, med föremål som varierar i utseende (t.ex. form, färg etc.), " sa Dr Luo. Dessutom, den föreslagna metoden för visuell-taktil datagenerering kommer att användas för att underlätta robotuppgifter, såsom grepp och manipulation."

Uppsatsen som beskriver denna senaste studie, förpublicerad på arXiv, kommer att presenteras vid 2019 års internationella konferens om robotik och automation (ICRA), som kommer att äga rum i Montreal, Kanada, mellan den 20:e och 24:e maj. På konferensen, Dr. Luo kommer också att hålla en workshop relaterad till ämnet för hans studie, kallad "ViTac:Integrating vision and touch for multimodal and cross-modal perception."

© 2019 Science X Network