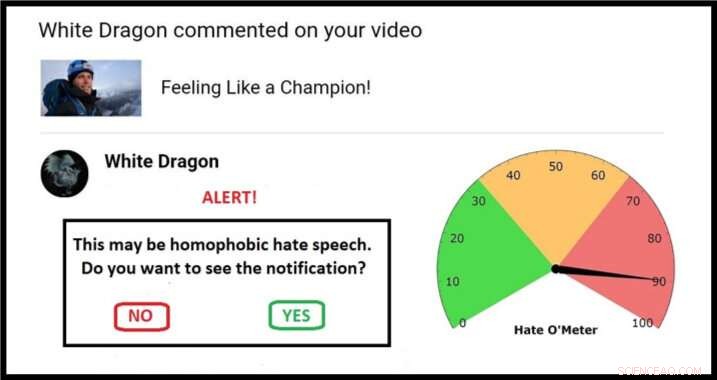

Exempel på en möjlig metod för en karantänskärm, komplett med Hate O'Meter. Upphovsman:Stefanie Ullman

Spridningen av hatprat via sociala medier kan hanteras med samma "karantän" -metod som används för att bekämpa skadlig programvara, enligt forskare från University of Cambridge.

Definitioner av hatprat varierar beroende på nation, lag och plattform, och att bara blockera nyckelord är ineffektivt:grafiska beskrivningar av våld behöver inte innehålla uppenbara etniska förtal för att utgöra rasistiska dödshot, till exempel.

Som sådan, hatprat är svårt att upptäcka automatiskt. Det måste rapporteras av dem som utsätts för det, efter att den avsedda "psykiska skadan" har orsakats, med styrkor av moderatorer som krävs för att bedöma varje fall.

Detta är den nya frontlinjen i en gammal debatt:yttrandefrihet kontra giftigt språk.

Nu, en ingenjör och en lingvist har publicerat ett förslag i tidskriften Etik och informationsteknik som utnyttjar cybersäkerhetstekniker för att ge kontroll till de riktade, utan att ta till censur.

Cambridge språk- och maskininlärningsexperter använder databaser över hot och våldsfulla förolämpningar för att bygga algoritmer som kan ge en poäng för sannolikheten för ett onlinemeddelande som innehåller former av hatprat.

När dessa algoritmer förfinas, potentiella hatuttalanden skulle kunna identifieras och "sättas i karantän". Användare skulle få en varningsvarning med "Hate O'Meter" - värdet av hatets uttalande - avsändarens namn, och ett alternativ för att se innehållet eller ta bort osynligt.

Detta tillvägagångssätt liknar filter för spam och skadlig kod, och forskare från projektet 'Giving Voice to Digital Democracies' tror att det dramatiskt kan minska mängden hatprat som människor tvingas uppleva. De siktar på att ha en prototyp klar i början av 2020.

"Hatprat är en form av avsiktlig skada på nätet, som malware, och kan därför hanteras med karantän, "sa medförfattare och språkforskare Dr Stefanie Ullman." Faktum är att mycket hatprat genereras faktiskt av programvara som Twitter -bots. "

"Företag som Facebook, Twitter och Google reagerar i allmänhet reaktivt på hatprat, "sa medförfattare och ingenjör Dr. Marcus Tomalin." Detta kan vara okej för dem som inte stöter på det ofta. För andra är det för lite, för sent."

"Många kvinnor och människor från minoritetsgrupper i allmänhetens ögon får anonymt hat -tal för att de vågar ha en närvaro online. Vi ser detta hindra människor från att gå in i eller fortsätta i det offentliga livet, ofta de från grupper som behöver större representation, " han sa.

USA:s tidigare utrikesminister Hillary Clinton sa nyligen till en brittisk publik att hatprat utgjorde ett "hot mot demokratier", i kölvattnet av många parlamentsledamöter som citerar övergrepp på nätet som en del av anledningen till att de inte längre kommer att ställa upp på val.

I en Georgetown University -adress, Facebooks VD Mark Zuckerberg talade om "breda meningsskiljaktigheter om vad som kvalificerar sig som hat" och hävdade:"vi borde ta fel på sidan av större uttryck".

Forskarna säger att deras förslag inte är en magisk kula, men det sitter mellan de "extrema libertariska och auktoritära tillvägagångssätten" att antingen helt tillåta eller förbjuda visst språk online.

Viktigt, användaren blir domare. "Många människor tycker inte om tanken på att ett ovalat företag eller mikromanagerande regering ska bestämma vad vi kan och inte kan säga till varandra, sa Tomalin.

"Vårt system kommer att flagga när du ska vara försiktig, men det är alltid ditt samtal. Det hindrar inte att folk publicerar eller ser vad de gillar, men det ger välbehövlig kontroll till dem som översvämmas av hat. "

I tidningen, forskarna hänvisar till detekteringsalgoritmer som uppnår 60% noggrannhet - inte mycket bättre än slumpen. Tomalins maskininlärningslaboratorium har nu upp till 80%, och han räknar med en fortsatt förbättring av den matematiska modelleringen.

Under tiden, Ullman samlar in fler "träningsdata":verifierade hatprat som algoritmerna kan lära sig av. Detta hjälper till att förfina "förtroendepoängen" som bestämmer en karantän och efterföljande avläsning av Hate O'Meter, som kan ställas in som en känslighetsratt beroende på användarens preferenser.

Ett grundläggande exempel kan innebära ett ord som "tik":en kvinnofientlig slurv, men också en legitim term i sammanhang som hunduppfödning. Det är den algoritmiska analysen av var ett sådant ord sitter syntaktiskt - typerna av omgivande ord och semantiska relationer mellan dem - som informerar hattalet.

"Det räcker inte med att identifiera enskilda sökord, vi tittar på hela meningsstrukturer och långt bortom. Sociolingvistisk information i användarprofiler och publiceringshistorik kan alla bidra till att förbättra klassificeringsprocessen, sa Ullman.

Tillade Tomalin:"Genom automatiserade karantäner som ger vägledning om styrkan i hatiskt innehåll, vi kan stärka dem i mottagaränden av hatytret som förgiftar våra onlinediskurser. "

Dock, forskarna, som arbetar i Cambridge's Center for Research in Arts, Humaniora och samhällsvetenskap (CRASSH), säg att - som med datavirus - kommer det alltid att finnas en vapenkapplöpning mellan hatprat och system för att begränsa det.

Projektet har också börjat titta på "mottal":hur människor reagerar på hatprat. Forskarna tänker föra in i debatter kring hur virtuella assistenter som "Siri" ska reagera på hot och hot.