En robot och människa interagerar. Kredit:Tommy Ton, tonnommy.com, CC BY-ND

Artificiell intelligens kommer in i våra liv på många sätt – på våra smartphones, i våra hem, i våra bilar. Dessa system kan hjälpa människor att boka möten, köra bil och till och med diagnostisera sjukdomar. Men eftersom AI-system fortsätter att fylla viktiga och samarbetande roller i människors liv, en naturlig fråga är:Kan jag lita på dem? Hur vet jag att de kommer att göra vad jag förväntar mig?

Explainable AI (XAI) är en gren av AI-forskning som undersöker hur artificiella medel kan göras mer transparenta och pålitliga för sina mänskliga användare. Pålitlighet är avgörande om robotar och människor ska kunna samarbeta. XAI strävar efter att utveckla AI-system som människor finner tillförlitliga – samtidigt som de presterar bra för att uppfylla designade uppgifter.

På Centrum för syn, kognition, Inlärning, och autonomi vid UCLA, vi och våra kollegor är intresserade av vilka faktorer som gör maskiner mer pålitliga, och hur väl olika inlärningsalgoritmer möjliggör tillit. Vårt labb använder en typ av kunskapsrepresentation – en modell av världen som en AI använder för att tolka sin omgivning och fatta beslut – som lättare kan förstås av människor. Detta bidrar naturligtvis till förklaring och transparens, vilket förbättrar förtroendet hos mänskliga användare.

I vår senaste forskning, vi experimenterade med olika sätt som en robot kunde förklara sina handlingar för en mänsklig observatör. Intressant, de former av förklaringar som främjade mest mänskligt förtroende motsvarade inte de inlärningsalgoritmer som gav den bästa uppgiftsprestanda. Detta tyder på att prestanda och förklaring inte i sig är beroende av varandra – att optimera för en ensam kanske inte leder till det bästa resultatet för den andra. Denna avvikelse kräver robotdesigner som tar hänsyn till både god uppgiftsprestanda och pålitliga förklaringar.

Lära robotar

Genom att genomföra denna studie, vår grupp var intresserad av två saker. Hur lär sig en robot bäst att utföra en viss uppgift? Sedan, hur reagerar människor på robotens förklaring av dess handlingar?

Vi lärde en robot att lära sig från mänskliga demonstrationer hur man öppnar en medicinflaska med säkerhetslås. En person bar en taktil handske som registrerade den mänskliga handens ställningar och krafter när den öppnade flaskan. Den informationen hjälpte roboten att lära sig vad människan gjorde på två sätt:symboliskt och haptiskt. Symbolisk hänvisar till meningsfulla representationer av dina handlingar:till exempel, ordet "greppa". Haptic hänvisar till de känslor som är förknippade med din kropps ställningar och rörelser:till exempel, känslan av att dina fingrar sluter sig samman.

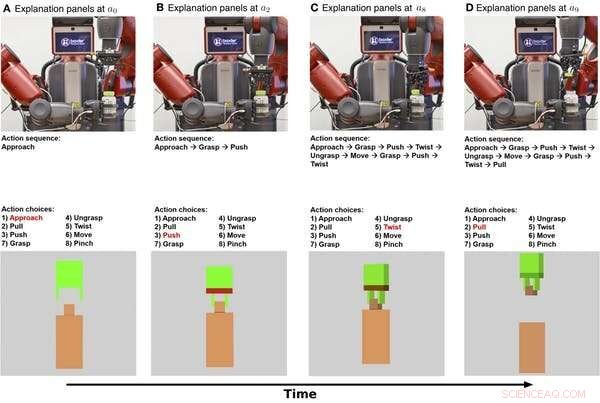

Symboliska och haptiska förklaringar av en robot som öppnar en medicinflaska som visas över tid. Den översta raden är stillbilder från en video av roboten som utför uppgiften. Den mittersta raden visar en symbolisk förklaring av uppgiften. Den nedre raden visar en haptisk förklaring. Kredit:Edmonds et al., Sci. Robot. 4, eaay4663 (2019)

Först, roboten lärde sig en symbolisk modell som kodar sekvensen av steg som behövs för att slutföra uppgiften att öppna flaskan. Andra, roboten lärde sig en haptisk modell som gör att roboten kan "föreställa sig" sig själv i rollen som den mänskliga demonstratorn och förutsäga vilken handling en person skulle vidta när han möter särskilda poser och krafter.

Det visade sig att roboten kunde uppnå sin bästa prestanda när den kombinerade de symboliska och haptiska komponenterna. Roboten klarade sig bättre genom att använda kunskap om stegen för att utföra uppgiften och avkänna i realtid från sin gripare än att använda endera ensam.

Att vinna mänskligt förtroende

Nu när roboten vet vad den ska göra, hur kan det förklara sitt beteende för en person? Och hur väl främjar den förklaringen mänskligt förtroende?

För att förklara dess handlingar, roboten kan utnyttja såväl sin interna beslutsprocess som sitt beteende. Den symboliska modellen ger steg-för-steg beskrivningar av robotens handlingar, och den haptiska modellen ger en känsla av vad robotgriparen "känner".

I vårt experiment, vi lade till en ytterligare förklaring för människor:en textskrivning som gav en sammanfattning efter att roboten försökt öppna medicinflaskan. Vi ville se om sammanfattande beskrivningar skulle vara lika effektiva som den steg-för-steg symboliska förklaringen för att vinna mänskligt förtroende.

Vi frågade 150 mänskliga deltagare, delas in i fyra grupper, för att observera roboten som försöker öppna medicinflaskan. Roboten gav sedan varje grupp en annan förklaring av uppgiften:symbolisk, steg för steg, haptisk – armpositioner och rörelser, textsammanfattning, eller symboliskt och haptiskt tillsammans. En baslinjegrupp observerade bara en video av roboten som försökte öppna flaskan, utan att ge några ytterligare förklaringar.

Vi fann att tillhandahållandet av både symboliska och haptiska förklaringar främjade mest förtroende, med den symboliska komponenten som bidrar mest. Intressant, förklaringen i form av en textsammanfattning skapade inte mer förtroende än att bara se roboten utföra uppgiften, vilket indikerar att människor föredrar robotar för att ge steg-för-steg förklaringar av vad de gör.

UCLA-forskare testar en robot efter att den har lärt sig hur man öppnar en medicinflaska genom att observera mänskliga demonstranter. Kredit:UCLA Samueli School of Engineering, CC BY-ND

Design för både prestanda och förtroende

Det mest intressanta resultatet av denna forskning är att det som får robotar att prestera bra inte är detsamma som det som gör att människor ser dem som pålitliga. Roboten behövde både de symboliska och haptiska komponenterna för att göra det bästa jobbet. Men det var den symboliska förklaringen som fick folk att lita mest på roboten.

Denna avvikelse belyser viktiga mål för framtida AI- och robotforskning:att fokusera på att eftersträva både uppgiftsutförande och förklarabarhet. Att bara fokusera på uppgiftsutförande kanske inte leder till en robot som förklarar sig väl. Vårt labb använder en hybridmodell för att ge både hög prestanda och pålitliga förklaringar.

Prestanda och förklaring kompletterar inte varandra naturligt, så båda målen måste vara prioriterade från början när man bygger AI-system. Detta arbete representerar ett viktigt steg i att systematiskt studera hur relationer mellan människa och maskin utvecklas, men mycket mer måste göras. Ett utmanande steg för framtida forskning kommer att vara att gå från "Jag litar på att roboten gör X" till "Jag litar på roboten."

För att robotar ska få en plats i människors dagliga liv, människor måste lita på sina robotmotsvarigheter. Att förstå hur robotar kan ge förklaringar som främjar mänskligt förtroende är ett viktigt steg mot att göra det möjligt för människor och robotar att arbeta tillsammans.

Den här artikeln är återpublicerad från The Conversation under en Creative Commons-licens. Läs originalartikeln.