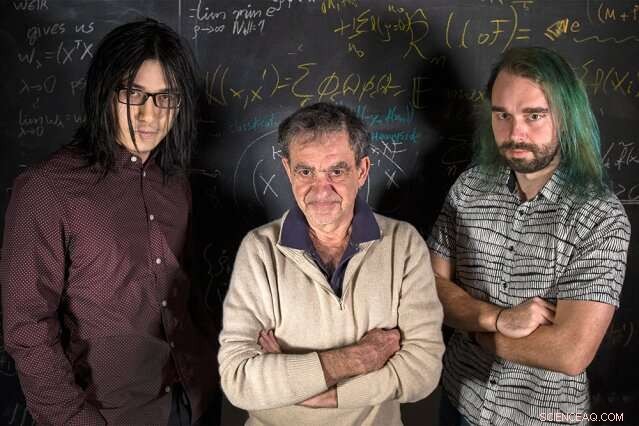

MIT -forskare (vänster till höger) Qianli Liao, Tomaso Poggio, och Andrzej Banburski står med sina ekvationer. Upphovsman:Kris Brewer

Inledande statistikkurser lär oss att när en modell anpassas till vissa data, vi borde ha mer data än lediga parametrar för att undvika risken för övermontering - för att passa bullriga data för nära, och därmed misslyckas med att passa nya data. Det är förvånande, sedan, att i modern djupinlärning är praktiken att ha storleksordningar fler parametrar än data. Trots detta, djupa nätverk visar god förutsägbar prestanda, och faktiskt göra det bättre ju fler parametrar de har. Varför skulle det vara så?

Det har varit känt sedan länge att bra prestanda inom maskininlärning kommer från att kontrollera komplexiteten i nätverk, vilket inte bara är en enkel funktion av antalet fria parametrar. Komplexiteten hos en klassificerare, som ett neuralt nätverk, beror på att mäta "storleken" på utrymmet för funktioner som detta nätverk representerar, med flera tekniska åtgärder som tidigare föreslagits:dimensionen Vapnik – Chervonenkis, täcker siffror, eller Rademacher -komplexitet, för att nämna några. Komplexitet, mätt med dessa föreställningar, kan kontrolleras under inlärningsprocessen genom att sätta en begränsning på normen för parametrarna - kort sagt, om hur "stora" de kan bli. Det överraskande faktum är att inga sådana uttryckliga begränsningar tycks behövas för att utbilda djupa nätverk. Ligger djupinlärning utanför den klassiska inlärningsteorin? Behöver vi tänka om grunderna?

I ett nytt Nature Communications -papper, "Komplexitetskontroll genom gradient nedstigning i djupa nätverk, "ett team från Center for Brains, Sinnen, och maskiner som leds av regissören Tomaso Poggio, Eugene McDermott -professorn vid MIT -avdelningen för hjärn- och kognitiv vetenskap, har kastat lite ljus på detta pussel genom att ta itu med de mest praktiska och framgångsrika tillämpningarna av modern djupinlärning:klassificeringsproblem.

"För klassificeringsproblem, vi observerar att parametrarna i modellen faktiskt inte verkar konvergera, utan växer snarare i storlek på obestämd tid under nedgång. Dock, i klassificeringsproblem spelar bara de normaliserade parametrarna - dvs. riktningen de definierar, inte deras storlek, "säger medförfattaren och MIT Ph.D.-kandidaten Qianli Liao." Det inte så uppenbara vi visade är att den vanliga gradientnedgången på de onormaliserade parametrarna inducerar önskad komplexitetskontroll på de normaliserade. "

"Vi har känt en tid när det gäller regression för grunda linjära nätverk, såsom kärnmaskiner, att iterationer av gradient härkomst ger en implicit, försvinnande reguleringseffekt, "Säger Poggio." Faktum är att i detta enkla fall vet vi förmodligen att vi får den bäst uppförande maxmarginalen, minimilösning. Frågan vi ställde oss själva, sedan, var:Kan något liknande hända för djupa nätverk? "

Forskarna fann att det gör det. Som medförfattare och MIT postdoc Andrzej Banburski förklarar, "Att förstå konvergens i djupa nätverk visar att det finns tydliga riktningar för att förbättra våra algoritmer. Faktum är att Vi har redan sett tips om att kontrollera hastigheten med vilken dessa onormaliserade parametrar avviker gör att vi kan hitta bättre lösningar och hitta dem snabbare. "

Vad betyder detta för maskininlärning? Det finns ingen magi bakom djupa nätverk. Samma teori bakom alla linjära modeller spelar också roll här. Detta arbete föreslår sätt att förbättra djupa nätverk, gör dem mer exakta och snabbare att träna.

Denna artikel publiceras på nytt med tillstånd av MIT News (web.mit.edu/newsoffice/), en populär webbplats som täcker nyheter om MIT -forskning, innovation och undervisning.