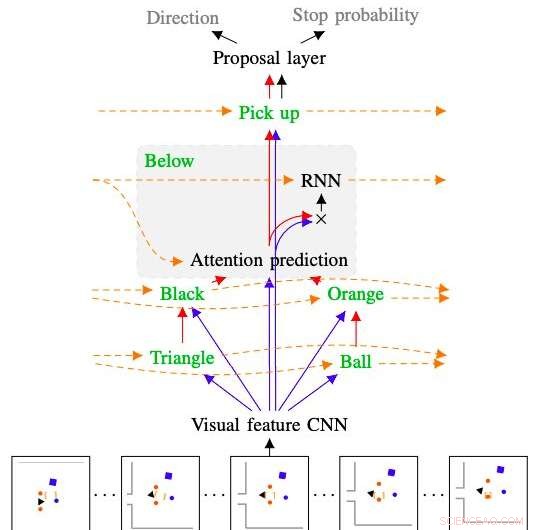

Bild som visar hur modellen utvecklat av forskarna tolkar och följer kommandot "plocka upp den orangea bollen under den svarta triangeln". Kredit:Kuo, Katz &Barbu.

Under de kommande åren, robotar kan hjälpa mänskliga användare på en mängd olika sätt, både när de är inne i sina hem och i andra miljöer. För att vara mer intuitiv, robotar ska kunna följa naturliga språkkommandon och instruktioner, eftersom detta tillåter användare att kommunicera med dem precis som de skulle med andra människor.

Med detta i åtanke, forskare vid MIT:s Center for Brains, Minds &Machines har nyligen utvecklat en samplingsbaserad robotplanerare som kan tränas för att förstå sekvenser av naturliga språkkommandon. Systemet de utvecklade, presenteras i en förpublicerad tidning på arXiv, kombinerar ett djupt neuralt nätverk med en samplingsbaserad planerare.

"Det är ganska viktigt att se till att framtida robotar i våra hem förstår oss, både av säkerhetsskäl och för att språket är det bekvämaste gränssnittet för att fråga efter det du vill ha, " Andrei Barbu, en av forskarna som genomförde studien, berättade för TechXplore. "Vårt arbete kombinerar tre forskningslinjer:robotplanering, djupa nätverk, och vårt eget arbete med hur maskiner kan förstå språk. Det övergripande målet är att ge en robot bara några få exempel på vad en mening betyder och få den att följa nya kommandon och nya meningar som den aldrig hört förut."

Det långtgående målet med forskningen som utförs av Barbu och hans kollegor är att bättre förstå kroppsspråkskommunikation. Faktiskt, medan funktionerna och mekanismerna bakom talad kommunikation nu är väl förstått, den mesta kommunikationen som sker mellan djur och människor är icke-verbal.

Att få en bättre förståelse för kroppsspråk kan leda till utvecklingen av mer effektiva strategier för robot-mänsklig kommunikation. Bland annat, forskarna vid MIT har därför undersökt möjligheten att översätta meningar till robotiska rörelser, och vice versa. Deras senaste studie är ett första steg i denna riktning.

Kredit:Kuo, Katz &Barbu.

"Robotiska planerare är fantastiska på att utforska vad roboten kan göra och sedan låta roboten utföra en åtgärd, "Yen-Ling Kuo, en annan forskare som utförde studien, berättade för TechXplore. "Vårt arbete tar en mening, bryter ner den i bitar, dessa bitar översätts till små nätverk, som sätts ihop igen."

Precis som språk är uppbyggt av ord som kan kombineras till meningar enligt grammatiska regler, nätverken utvecklade av Barbu, Kuo och deras kollega Boris Katz består av mindre nätverk som är utbildade för att förstå enskilda begrepp. När de kombineras, dessa nätverk kan avslöja och representera innebörden av hela meningar.

Den nya robotplaneraren som utvecklats av forskarna har två nyckelkomponenter. Den första är ett återkommande hierarkiskt djupt neuralt nätverk, som styr hur planeraren utforskar den omgivande miljön, samtidigt som man förutsäger när en planerad väg sannolikt kommer att uppnå ett givet mål och uppskattar effektiviteten av var och en av robotens möjliga rörelser individuellt. Den andra är en provtagningsbaserad planerare som ofta används i robotstudier, kallas snabbt utforskande slumpmässigt träd (RRT).

"Den stora fördelen med vår planerare är att den kräver lite träningsdata, Barbu förklarade. "Om du vill lära en robot, du kommer inte att ge det tusentals exempel hemma, men en handfull är ganska rimliga. Att träna en robot bör innebära liknande åtgärder som de du skulle kunna utföra om du tränade en hund."

Medan tidigare studier också utforskade sätt att styra robotar via verbala kommandon, de tekniker som presenteras i dem gäller ofta bara för diskreta miljöer, där robotar endast kan utföra en begränsad mängd åtgärder. Planeraren utvecklad av forskarna, å andra sidan, kan stödja en mängd olika interaktioner med den omgivande miljön, även om de involverar föremål som roboten aldrig har stött på tidigare.

"När vårt nätverk är förvirrat, planerare delen tar över, kommer på vad det ska göra och sedan kan nätverket ta över nästa gång det är övertygat om vad det ska göra, " Kuo förklarade. "Det faktum att vår modell är uppbyggd av delar ger den också en annan önskvärd egenskap:tolkningsbarhet."

När de inte kan slutföra en viss uppgift, många befintliga maskininlärningsmodeller kan inte ge information om vad som gick fel och de problem de stötte på. Detta gör det svårare för utvecklare att identifiera en modells brister och göra riktade förändringar i dess arkitektur. Den djupa inlärningskomponenten i robotplaneraren skapad av Barbu, Kuo och Katz, å andra sidan, visar sitt resonemang steg för steg, förtydliga vad varje ord den bearbetar förmedlar om världen och hur den kombinerade resultaten av sina analyser. Detta gör det möjligt för forskarna att lokalisera problem som hindrade den från att framgångsrikt slutföra en given åtgärd i det förflutna och göra förändringar i arkitekturen som kan säkerställa dess framgång i framtida försök.

"Vi är mycket glada över föreställningen att robotar snabbt kan lära sig språk och snabbt lära sig nya ord med väldigt lite hjälp från människor, sa Barbu. Normalt, djupinlärning anses vara mycket datahungrig; Det här arbetet förstärker tanken att när du bygger in rätt principer (kompositionalitet) och låter agenter utföra meningsfulla handlingar behöver de inte alls lika mycket data."

Forskarna utvärderade prestandan hos sin planerare i en serie experiment, samtidigt som man jämför dess prestanda med befintliga RRT-modeller. I dessa tester, planeraren lyckades skaffa sig betydelsen av ord och använde det den lärde sig för att representera sekvenser av meningar som den aldrig stött på tidigare, överträffade alla modeller den jämfördes med.

I framtiden, modellen som utvecklats av detta team av forskare skulle kunna informera utvecklingen av robotar som kan bearbeta och följa naturliga språkkommandon mer effektivt. Just nu, deras planerare tillåter robotar att bearbeta och utföra enkla instruktioner som "plocka upp tallriken på bordet", men kan fortfarande inte fånga innebörden av mer komplexa, som "plocka upp dockan när den faller på golvet och rengör den". Barbu, Kuo och Katz försöker alltså just nu utöka utbudet av meningar som roboten kan förstå.

"Vårt långsiktiga framtida mål är att utforska idén om omvänd planering, " sa Kuo. "Det betyder att om vi kan förvandla språk till robothandlingar, vi kunde då också titta på handlingar och fråga roboten "vad tänkte någon när de gjorde det här?" Vi hoppas att detta kommer att fungera som en nyckel till att låsa upp kroppsspråk i robotar."

© 2020 Science X Network