Upphovsman:Geralt/Pixabay

Artificiella neuroner för djupt intelligenta maskiner - det här är den nya artificiella intelligensen (AI) revolutionen, ledd av Geoffrey Hinton och hans team sedan 2012. Det året, Hinton, en expert på kognitiv vetenskap vid University of Toronto och en forskare vid Google Brain, visade den slående effektiviteten hos ett djupt neuralt nätverk (DNN) i en bildkategoriseringsuppgift.

I kölvattnet av dessa anmärkningsvärda resultat, universitet - och internationella företag - satsade massivt på det lovande och fascinerande AI -området. Trots DNN:s imponerande prestanda på en mängd olika områden (visuellt och röstigenkänning, översättning, medicinska bilder, etc.), frågor kvarstår om gränserna för djupinlärning för andra användningsområden, som antonyma fordon.

För att förstå gränserna för AI i dess nuvarande tillstånd, vi måste förstå var DNN kommer ifrån och, framför allt, vilka områden i den mänskliga hjärnan de är modellerade efter - lite är känt om detta inom industriteknik, och även i vissa forskningscentra. Sedan den nya revolutionens gryning, djup inlärning används ibland som ett slags "trollstav", med knapp uppmärksamhet på dess bakgrund eller begränsningar. "För en meningsfull artificiell intelligens", titeln på en ny rapport av den franske matematikern Cédric Villani, är ett bevis på den djupa ambivalensen kring detta ämne.

Var kom djupt lärande ifrån?

Början av artificiella neurala nätverk går tillbaka till 1940 -talet, med de banbrytande upptäckterna inom neurovetenskap och psykologi av Warren McCulloch och Walter H. Pitts (som gav den första matematiska modellen av ett neuron) och Donald Hebb (som beskrev mekanismerna för synaptiskt lärande). Dessa forskare ville förstå hur neuroner, hjärnans grundläggande byggstenar, kan generera psyket.

Deras banbrytande arbete ledde till skapandet av det första artificiella neuronala nätverket, Perceptron, designad 1958 av den amerikanske psykologen Frank Rosenblatt. Naturligtvis, inledande forskning följdes av betydande utveckling baserad, till exempel, om neurovetenskapliga studier av Alan L. Hodgkin och Andrew F. Huxley som beskriver den tidsmässiga dynamiken i neural integration, och om forskning inom datavetenskap och matematik av Bernard Widrow och Ted Hoff, som föreslog användning av stokastiska gradient -nedstigningsalgoritmer som ett mer effektivt sätt att modifiera de synaptiska anslutningarna i neurala nätverk.

Dessa matematiska optimeringar utvecklades vidare på 1980 -talet med forskning inom kognitiv vetenskap av David Rumelhart, Geoffrey Hinton och James McClelland, medlemmar i Parallel Distributed Processing Research Group. Deras arbete hjälpte till att optimera modifieringen av synaptiska anslutningar i djupa neuronala lager och ledde till skapandet av Multilayer Perceptron (MLP). DNN, utvecklat av forskare som Geoffrey Hinton, Yann LeCun och Yoshua Bengio, är dess direkta ättlingar.

Finns det en koppling mellan djupinlärning och hjärnan?

Även om DNN ursprungligen utvecklades genom tvärvetenskapligt arbete och inspirerades av hjärnans funktion, man kan undra i vilken utsträckning dessa algoritmer fortfarande utgör en simulering av den mänskliga hjärnan. De var utformade för att utföra uppgifter som bildigenkänning och kategorisering. För att göra detta, DNN använder olika konvolutions- och poollager före bildigenkänning.

När det gäller konvolutionella lager, verket av David Hubel och Torsten Wiesel på 1960 -talet, och Leonie Jones och Derecke Palmer på 1980 -talet, visa användbarheten av denna metod för att simulera det troliga svaret hos neuroner i den primära visuella cortexen. Flera studier inom kognitiv vetenskap, inklusive vårt eget arbete, använd denna process som ett neuroinspirerat system för att simulera responsen från perceptuella neuroner i den primära visuella cortexen till exempel.

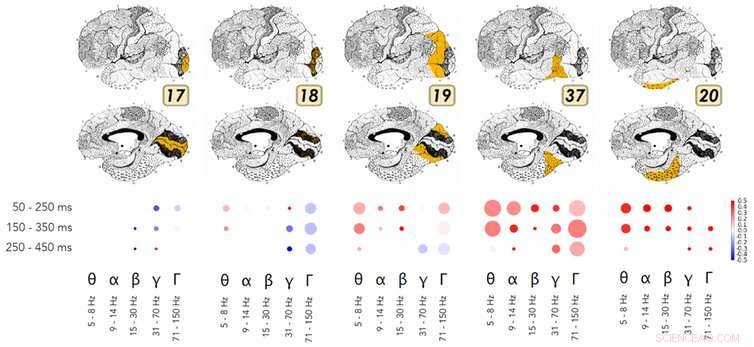

Ett exempel på forskningen som visar likheterna i hur djupa neurala nätverk och den ventrala strömmen i den visuella cortexen fungerar. Upphovsman:Kuzovkin, Vicente, Petton, Lachaux, Baciu, Kahane et Aru, 2018., Författare tillhandahålls

När det gäller poolning, olika studier inom neurovetenskap och kognitiv psykologi under de senaste trettio åren har visat hur hjärnan utför denna abstraktionsprocess i den ventrala visuella strömmen. Rufin Vogels och Keiji Tanakas arbete visar hur denna ström möjliggör visuell identifiering och kategorisering, oberoende av bildens ytegenskaper, som textur, Färg, distans, eller objektens position i bilden. Dessa hjärnområden är därför känsliga för samma information som de perceptuella skikten som en DNN lärde sig under poolningsprocessen.

Ännu mer överraskande, forskning av Rodrigo Quian Quiroga och hans kollegor visar att det finns specifika neuroner för begrepp eller identiteter (t.ex. en "Jennifer Aniston" neuron, eller en "Tower of Pisa" neuron). Dessa eldar som svar på direkt exponering för ett koncept, som att se namnet "Jennifer Aniston" på tryck. Vad som är mer spännande för AI:s framtid är att Quirogas arbete visar att denna neuronala aktivitet är korrelerad med medveten uppfattning om en stimulans i miljön.

För att sammanfatta, även om de är förenklade och matematiskt optimerade jämfört med en biologisk hjärna, DNN reproducerar mycket liknande processer som ett mycket specifikt område i cortex (nämligen occipito-temporal cortex). Med hjälp av MR eller elektroder implanterade i hjärnan, nya studier inom kognitiv neurovetenskap visar likheter i funktionen av DNN:er och dessa specifika hjärnområden.

Är AI mer tillförlitligt när det inspireras av hjärnan?

Grundläggande tvärvetenskaplig forskning om DNN har gett imponerande konkreta resultat inom ett brett spektrum av områden:visuell igenkänning och kategorisering, röstigenkänning, översättning, spelet go, musikalisk komposition, för att bara nämna några. Tyvärr, genom en brist på förståelse för den kognitiva vetenskap som ligger till grund för dem, DNN används fortfarande alltför ofta som ett slags trollstav för att lösa alla problem.

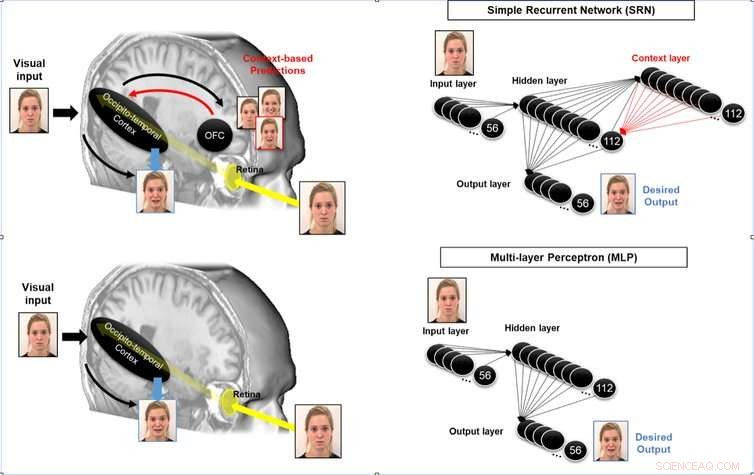

Det är möjligt att förbättra ett neuromorft systems förmåga att förutse genom att simulera återkommande slingor från associativa områden till perceptuella områden som arbetar i den mänskliga hjärnan. Upphovsman:Mermillod, Bourrier, David, Kauffmann, Chauvin, Guyader, Dutheil et Peyrin, 2018., Författare tillhandahålls

För att ta exemplet med förarlösa bilar, tanklöst att koppla DNN:er till fordonets kontrollsystem skulle vara mycket riskabelt:det skulle vara lika med att be en taxichaufför som förlorade över 80% av sin hjärnfunktion i en olycka (lämnar endast den visuella ventralströmmen) att köra bil. Att kräva att dessa system gör mer än vad de ursprungligen var avsedda för kan leda till katastrofala olyckor.

De mänskliga hjärnområdena som är involverade i förväntan (se nedan), rumslig orientering och de sensoriskt-motoriska funktioner som krävs för att köra i en komplex miljö skiljer sig mycket från de neurala processer som arbetar i den visuella ventralströmmen. Ligger i occipito-parietal cortex, de neuronala processer som är involverade i förståelsen och planeringen skiljer sig mycket från de som äger rum i den visuella ventralströmmen! Det här är väldigt olika neuroner, känslig för avstånd, position och hastighet - alla grundläggande parametrar för att bestämma hur vi beter oss i miljön.

Utan diskriminering av DNN (eller andra artificiella system) utan referens eller jämförelse med neuro-inspirationen bakom de olika kognitiva funktionerna är inte bara ineffektiv utan direkt farlig. Vi hävdar inte att neuro-inspiration är det enda effektiva sättet mot säkrare AI. Dock, med tanke på AI:s tumultiga förflutna, och med beaktande av den nu beprövade effektiviteten av neuroinspirerade system som DNN jämfört med tidigare tekniska metoder (för visuell igenkänning, till exempel), vi tror att det är viktigt att förstå hur hjärnan utför andra kognitiva funktioner (motorstyrning, multisensorisk integration, etc.) för att jämföra detta med nuvarande tekniska tekniker för att utföra dessa funktioner, och skapa en säkrare, effektivare AI.

AI -forskning som bedrivs i närmare samarbete med de kognitiva vetenskaperna skulle göra det möjligt för oss att:

Denna utmaning kräver tvärvetenskaplig forskning som involverar inte bara matematik och datavetenskap, men också neurovetenskap och kognitiv psykologi, samt forskning inom elektronik och fysik för att utveckla de neurala processorenheter (NPU) som för närvarande utformas. Vi har möjlighet att äntligen övervinna gränserna för Turing-Von Neumann-maskinerna som har dominerat elektronik och informationsteknik sedan andra världskriget.

Denna artikel publiceras från The Conversation under en Creative Commons -licens. Läs originalartikeln.