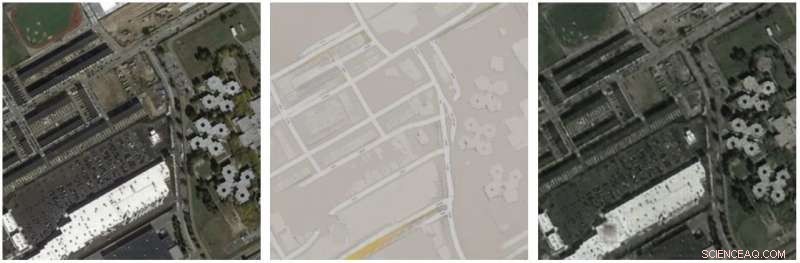

Detaljer i x är rekonstruerade i GF x, trots att den inte förekommer i mellankartan F x. Kredit:arXiv:1712.02950 [cs.CV]

Kalla det smart, stämpla det som en fuskare, men skäms inte för att tycka att det är fruktansvärt intressant. "det" är CycleGAN, och dess länk till steganografi – där meddelanden och information är gömda i icke-hemlig text eller data.

Så, 2019 kan det inte vara så chockerande för människor att lära sig att en maskin, inte en människa, kan fuska sig genom en uppgift. AI i det här fallet, som goda mänskliga spioner och nackdelar, lärt sig när man ska dölja viss information som kan användas senare.

I Packt , Bhagyashree R skrev att "Forskarna upptäckte att maskinen kodade in data från flygkartan till brusmönstren på gatukartan på den nedre delen. Koden var så subtil att den skulle vara osynlig för det mänskliga ögat. Men vid närmare inspektion, när detaljerna hade förstärkts, Det var tydligt att maskinen hade gjort tusentals små färgförändringar som indikerar visuella data som kunde användas som ett cheat sheet när man återskapade flygbilden – därav de magiskt återkommande takfönsterna."

Under tiden, en mycket citerad artikel om ämnet (forskningen täcktes av ett antal teknikbevakningswebbplatser, faktiskt) kapslade vad forskarna upptäckte. "En maskininlärningsagent avsedd att omvandla flygbilder till gatukartor och tillbaka visade sig vara fusk genom att dölja information som den skulle behöva senare i ett nästan omärkligt, högfrekvent signal, " sa TechCrunch .

Lily Hay Newman in Trådbunden 2017 påminde läsarna om att steganografi är en gammal praxis, inget född igår. Tänk att Da Vinci bäddar in hemlig mening i en målning; eller gårdagens spioner som skrev med osynligt bläck.

Om praktiken är gammal, fastän, det finns några samtida problem. Vi är, trots allt, i en digital värld där alla laster och dygder har tagit sig an nya processer online.

Steganografi kommer bara att bli svårare att upptäcka, sa BankInfoSecurity , och har "redan använts av dåliga skådespelare."

Mathew Schwartz sa att digital steganografi verkade göra livet svårare för brottsbekämpande myndigheter och citerade en universitetsprofessor som skickade en liknande kommentar. "Perfekt förnekbar steganografisk diskkryptering kommer att bli en mardröm när det gäller att samla in digitala bevis, sa Alan Woodward, professor i datavetenskap vid University of Surrey.

Spola framåt till rapporter som är inne nu, att en grupp Stanford- och Google-forskare genomförde en studie om hur ett neuralt nätverk, CycleGAN, lär sig fuska. Tidningen:CycleGAN, en Master of Steganography finns på arXiv och de tre författarna är Casey Chu (Stanford), Andrey Zhmoginov (Google) och Mark Sandler (Google).

De skrev, "CycleGAN lär sig att 'gömma' information om en källbild i bilderna som den genererar på ett nästan omärkligt, högfrekvent signal."

Som en del av deras diskussionssektion, författarna påpekar att "Genom att koda information på detta sätt, CycleGAN blir särskilt sårbart för motstridiga attacker; en angripare kan få en av de inlärda transformationerna att producera en bild efter eget val genom att störa valfri vald källbild."

Deras råd? De skrev att "närvaron av detta fenomen indikerar att försiktighet är nödvändig när man designar förlustfunktioner som involverar sammansättningar av neurala nätverk:sådana modeller kan bete sig på ointuitiva sätt om en komponent drar fördel av den andra komponentens förmåga att stödja motstridiga exempel."

Vanliga ramar, enligt författarna, såsom generativa kontradiktoriska nätverk och perceptuella förluster använder dessa kompositioner. De sa att "dessa ramverk bör analyseras noggrant för att säkerställa att motstridiga exempel inte är ett problem."

Men vänta. Ska vi springa för kullarna med skrikande rädsla för att robotar och AI kommer att göra slut på oss alla? Lyckligtvis, Devin Coldewey lugnade läsarna TechCrunch . Händelsen "avslöjar helt enkelt ett problem med datorer som har funnits sedan de uppfanns:de gör precis vad du säger åt dem att göra."

Vad menade Coldewey med det? "Forskarnas avsikt var, som du kanske gissar, att påskynda och förbättra processen att förvandla satellitbilder till Googles berömda korrekta kartor. För det ändamålet arbetade teamet med vad som kallas en CycleGAN – ett neuralt nätverk som lär sig att omvandla bilder av typ X och Y till varandra, så effektivt men exakt som möjligt, genom en hel del experiment."

Datorn kom fram till en lösning "som kastade ljus över en möjlig svaghet hos denna typ av neurala nätverk - att datorn, om det inte uttryckligen hindras från att göra det, kommer i huvudsak att hitta ett sätt att överföra detaljer till sig själv i syfte att lösa ett givet problem snabbt och enkelt."

© 2019 Science X Network