Kredit:lightcommands.com

Lysande lasrar på röstassistenter som Alexa och Siri, forskare från Michigan och Japan uppnådde ett hack där lasrar hade kraften i kommandon från den mänskliga rösten.

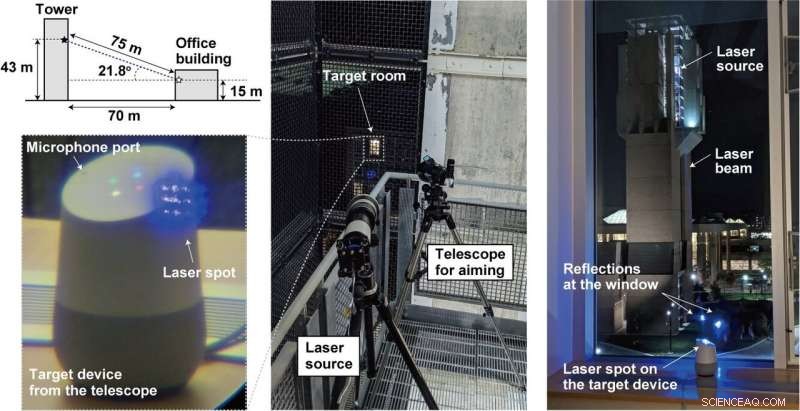

Genom att lysa lasern genom fönstret på mikrofoner inuti enheter som surfplattor, eller telefoner, en långt borta -angripare kan fjärrskicka ohörbara och potentiellt osynliga kommandon som ageras av Alexa, Portal, Google -assistent eller Siri.

Enkelt uttryckt, en angripare kan kapa röstassistenten och skicka kommandon.

Hur utförde laget ljus som ljud? En sårbarhet i mikrofoner som använder mikroelektromekaniska system (MEMS) utnyttjas. MEMS -komponenterna svarar oavsiktligt på ljus som om det vore ljud, sa Ars Technica .

Vad är det värsta som kan hända? Mycket. Ars Technica beskrev lasrarna som injicerade ohörbara kommandon i enheterna och smygande fick dem att "låsa upp dörrar, besöka webbplatser, och hitta, låsa upp, och starta fordon. "

Forskarna diskuterade sitt arbete i sin uppsats som publicerades på måndagen. "Light Commands:Laser-Based Audio Injection Attacks on Voice-Controllable Systems" är av fem författare med anknytning till University of Michigan (fyra) och från University of Electro-Communications, Japan (ett).

"I vårt papper, "sa de, "vi visar denna effekt, framgångsrikt att använda ljus för att injicera skadliga kommandon i flera röststyrda enheter som smarta högtalare, tabletter, och telefoner över stora avstånd och genom glasfönster. "

Hur lätt var det att genomföra?

För att motverka autentisering, ganska lätt.

"Röststyrda system kräver ofta inte att användarna autentiserar sig, "skrev Ars Technica är Dan Goodin. Attacken i dessa fall kan utföras ofta utan behov av lösenord eller PIN -koder. Ofta. "Även när systemen kräver autentisering för vissa åtgärder, " han lade till, "det kan vara möjligt att brutalt tvinga PIN -koden, eftersom många enheter inte begränsar antalet gissningar en användare kan göra. "

Också, attacken var inte dyr att genomföra. Ljuskommandon kan monteras billigt, sa en videopresentant, med vanliga laserpekare. Detta kan till och med göras mellan två byggnader.

Teamet sa att de försökte sin attack mot populära röstigenkänningssystem, nämligen Amazon Alexa, Apple Siri, Facebook -portalen, och Google Assistant. Faktiskt, fastän, "alla system som använder MEMS -mikrofoner och agerar på denna data utan ytterligare användarbekräftelse kan vara sårbara, "enligt deras egen ljuskommandosida.

Vad är faran med Light Commands?

Alexa, vad är det för väder? Det är ofarligt. Angriparen kan styra smart-home switchar. Öppna smarta garageportar. Starta fordon på distans. Faktiskt, du kan titta på en video som injicerar "OK Google, öppna garageporten "till ett Google Home bara genom att lysa en billig laserpekare.

Vad kan man göra för att skydda mot sårbarheten? Videopresentanten sa att den grundläggande sårbarheten inte kan åtgärdas utan dyr mikrofondesign.

"Vi samarbetar med Amazon, Google, Äpple, liksom andra leverantörer om defensiva åtgärder. "De har mer information och demonstrationer på lightcommands.com.

"Ett ytterligare lager av autentisering kan vara effektivt för att mildra attacken något. Alternativt kan om angriparen inte kan avlyssna enhetens svar, Att låta enheten ställa en enkel randomiserad fråga till användaren innan kommandot kan köras kan vara ett effektivt sätt att förhindra att angriparen får framgångsrik kommandoutförande.

"Tillverkare kan också försöka använda sensorfusionstekniker, som att skaffa ljud från flera mikrofoner. När angriparen använder en enda laser, bara en enda mikrofon tar emot en signal medan de andra inte får något ...

Ett annat tillvägagångssätt består i att minska mängden ljus som når mikrofonens membran med hjälp av en barriär som fysiskt blockerar raka ljusstrålar för att eliminera siktlinjen till membranet, eller implementera ett otransparent lock ovanpå mikrofonhålet för att dämpa mängden ljus som träffar mikrofonen. Dock, vi noterar att sådana fysiska hinder bara är effektiva till en viss punkt, som en angripare alltid kan öka lasereffekten i ett försök att kompensera för den täckinducerade dämpningen eller för att bränna sig genom barriärerna, skapa en ny ljusväg. "

Ovanstående dök upp på deras ljuskommandosida, medan tidningen också diskuterade metoder för begränsning och begränsningar.

Under tiden, Mariella Moon in Engadget påminde sina läsare om att detta inte skulle vara första gången forskare hittade sårbarheter hos digitala assistenter. "Forskare från Kinas Zheijiang -universitet fann att Siri, Alexa och andra röstassistenter kan manipuleras med kommandon som skickas i ultraljudsfrekvenser. "

© 2019 Science X Network