Kredit:Google

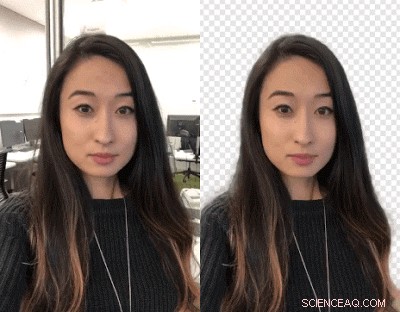

Videoskapare:Vill du byta bakgrund? Slå ut er. Google -forskare har arbetat med ett sätt att låta dig byta ut dina videobakgrunder med ett neuralt nätverk - ingen grön skärm krävs.

Det rullar ut till YouTube Stories på mobilen på ett begränsat sätt, sa TechCrunch .

John Anon, Android -rubriker , sa YouTube -skapare kan ändra bakgrunden för att skapa mer engagerande videor.

Valentin Bazarevsky och Andrei Tkachenka, programvaruingenjörer, Google Research, meddelade, med titeln "Mobile Real-time Videosegmentering."

Skapare av videoinnehåll vet att en scen bakgrund kan separeras från bakgrunden som behandlas som två olika lager. Manövern görs för att uppnå en stämning, eller infoga en rolig plats eller stansa effekten av meddelandet.

Operationen, sa de två på Google Research -webbplatsen, är "en tidskrävande manuell process (t.ex. en artist rotoskoperar varje bildruta) eller kräver en studiomiljö med en grön skärm för borttagning i realtid av bakgrund (en teknik som kallas chroma keying)."

Översättning:Hillary Grigonis in Digitala trender sa, "Att byta bakgrund på en video kräver vanligtvis avancerad skrivbordsprogramvara och gott om ledig tid, eller en fullvärdig studio med en grön skärm. "

Nu har de två tillkännagivit en ny teknik, och det kommer att fungera på mobiltelefoner.

Deras teknik gör det möjligt för skapare att ersätta och ändra bakgrunder utan specialutrustning.

De kallade det YouTubes nya lätta videoformat, speciellt utformad för YouTube -skapare.

De utfärdade ett meddelande den 1 mars om en "exakt, realtid, segmentering av mobilvideo på enheten till YouTube-appen genom att integrera denna teknik i berättelser. "

Hur gjorde de detta? Anon sa "kärnan i allt är maskininlärning."

Bazarevsky och Tkachenka sa att de utnyttjade "maskininlärning för att lösa en semantisk segmenteringsuppgift med hjälp av konvolutionella neurala nätverk."

Översättning:"Google utvecklar ett alternativ för artificiell intelligens som fungerar i realtid, från en smarttelefonkamera, "Skrev Grigonis.

De två ingenjörerna beskrev ett arkitektur- och utbildningsförfarande som är lämpligt för mobiltelefoner. De tänkte på att "En mobil lösning ska vara lätt och köra minst 10-30 gånger snabbare än befintliga toppmoderna fotosegmenteringsmodeller."

När det gäller en datamängd, de "kommenterade tiotusentals bilder". Dessa fångade ett brett spektrum av förgrundsställningar och bakgrundsinställningar.

"Med den datauppsättningen, gruppen utbildade programmet för att skilja bakgrunden från förgrunden, sa Grigonis.

Devin Coldewey in TechCrunch :"Nätverket lärde sig att plocka ut de gemensamma egenskaperna hos ett huvud och axlar, och en rad optimeringar sänkte mängden data som behövdes för att knäcka för att göra det. "

Digitala trender förklarade hur det fungerar:"När programvaran maskerar bakgrunden på den första bilden, programmet använder samma mask för att förutsäga bakgrunden i nästa bildruta. När den nästa ramen bara har mindre justeringar från den första ... kommer programmet att göra små justeringar av masken. När nästa ram är mycket annorlunda än den förra ... kommer programvaran att kasta den maskprognosen helt och skapa en ny mask. "

Ett slutresultat av deras arbete, som sagt på Google Research -bloggen, är att "vårt nätverk går anmärkningsvärt snabbt på mobila enheter, uppnå 100+ FPS på iPhone 7 och 40+ FPS på Pixel 2 med hög noggrannhet (inser 94,8% IOU på vår valideringsdataset), levererar en mängd smidiga och responsiva effekter i YouTube -berättelser. "

Vad kommer härnäst?

Det är i begränsad beta. "Vårt omedelbara mål är att använda den begränsade utrullningen i YouTube -berättelser för att testa vår teknik på denna första uppsättning effekter. När vi förbättrar och utökar vår segmenteringsteknik till fler etiketter, Vi planerar att integrera det i Googles bredare Augmented Reality -tjänster. "

© 2018 Tech Xplore