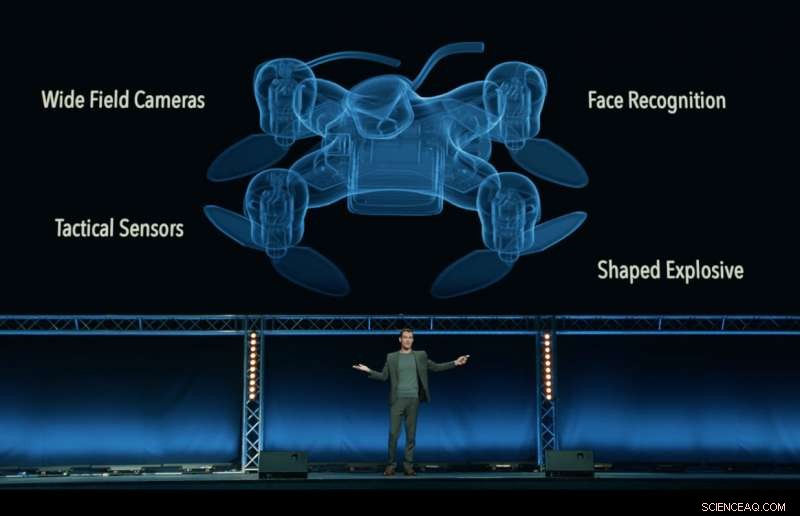

Stillbild från 'Slaughterbots'-videon, producerad av Future of Life Institute, som visar en fiktiv dystopisk framtid med mördardrönare som myllrar över världen. Kredit:Future of Life Institute

En vem är vem av VD:ar, ingenjörer och forskare från teknikindustrin – inklusive Google DeepMind, XPRIZE Foundation och Elon Musk – har undertecknat ett löfte om att "varken delta i eller stödja utvecklingen, tillverkning, handel, eller användning av dödliga autonoma vapen”.

Släppt i Stockholm vid 2018 års internationella gemensamma konferens om artificiell intelligens (IJCAI), världens ledande AI-forskningsmöte med över 5, 000 deltagare, löftet undertecknades av 150 företag och mer än 2, 400 individer från 90 länder som arbetar med artificiell intelligens (AI) och robotik.

Företagsundertecknare inkluderar Google DeepMind, University College London, XPRIZE Foundation, ClearPath Robotics/OTTO Motors, European Association for AI, och Svenska AI-sällskapet. Individer inkluderar forskningschefen på Google.ai Jeff Dean, AI-pionjärerna Stuart Russell, Yoshua Bengio, Anca Dragan och Toby Walsh, och brittiska Labour-parlamentarikern Alex Sobel.

Löftet, organiserad av Future of Life Institute, utmanar regeringar, akademi och industri att följa deras ledning, säger:"Vi, den undertecknade, uppmana regeringar och regeringsledare att skapa en framtid med starka internationella normer, föreskrifter och lagar mot dödliga autonoma vapen. ... Vi ber att teknikföretag och organisationer, såväl som ledare, beslutsfattare, och andra individer, gå med oss i detta löfte."

Max Tegmark, en fysikprofessor vid Massachusetts Institute of Technology och ordförande för Future of Life Institute, meddelade löftet.

"Jag är glad över att se AI-ledare gå från prat till handling, genomföra en politik som politiker hittills inte lyckats genomföra, ", sa Tegmark. "AI har enorm potential att hjälpa världen – om vi stigmatiserar och förhindrar missbruk av det. AI-vapen som självständigt bestämmer sig för att döda människor är lika äckliga och destabiliserande som biovapen, och bör hanteras på samma sätt."

Dödliga autonoma vapensystem (LAWS) - även kallade "mördarrobotar" - är vapen som kan identifiera, mål, och döda en person, utan en mänsklig "in-the-loop". Det är, ingen person fattar det slutgiltiga beslutet att tillåta dödlig våld:beslutet och godkännandet om huruvida någon ska dö eller inte överlåts till det autonoma vapensystemet. Detta inkluderar inte dagens drönare, som är under mänsklig kontroll; inte heller autonoma system som bara försvarar sig mot andra vapen.

Löftet börjar med uttalandet:"Artificiell intelligens är redo att spela en allt större roll i militära system. Det finns en brådskande möjlighet och nödvändighet för medborgarna, beslutsfattare, och ledare att skilja mellan acceptabel och oacceptabel användning av AI."

En annan nyckelorganisatör av löftet, Toby Walsh, en professor i artificiell intelligens vid Australiens University of New South Wales i Sydney, påpekar de svåra etiska frågorna kring LAGAR:"Vi kan inte lämna över beslutet om vem som lever och vem som dör till maskiner. De har inte etiken för att göra det. Jag uppmuntrar dig och dina organisationer att lova att se till att krig inte sker. bli mer fruktansvärd på det här sättet."

Ryan Gariepy, Grundare och CTO för både Clearpath Robotics och OTTO Motors, en stark motståndare till dödliga autonoma vapen, ekade uppmaningen:"Clearpath fortsätter att tro att spridningen av dödliga autonoma vapensystem förblir en tydlig och aktuell fara för medborgarna i alla länder i världen. Ingen nation kommer att vara säker, oavsett hur kraftfullt.

"Clearpaths oro delas av en mängd andra nyckelföretag och utvecklare för autonoma system, och vi hoppas att regeringar runt om i världen bestämmer sig för att investera sin tid och ansträngning i autonoma system som gör deras befolkning friskare, säkrare, och mer produktiva istället för system vars enda användning är utplacering av dödlig kraft, " han lade till.

Toby Walsh, professor i artificiell intelligens vid Australias University of New South Wales i Sydney, med en Baxter-robot. Kredit:Grant Turner/UNSW

Förutom de oroande etiska frågorna kring dödliga autonoma vapen, många förespråkare för ett internationellt förbud mot LAGAR är oroliga för att de kommer att vara svåra att kontrollera – lättare att hacka, mer sannolikt att hamna på den svarta marknaden, och lättare för terrorister och despoter att få tag på – vilket kan bli destabiliserande för alla länder. Ett sådant scenario spelas upp i den FLI-släppta videon Slaughterbots.

I december 2016 Förenta nationernas granskningskonferens av konventionen om konventionella vapen (CCW) inledde en formell diskussion om LAGS. 26 länder som deltar i konferensen har hittills meddelat stöd för någon typ av förbud, inklusive Kina.

Ett sådant förbud är inte utan prejudikat:biologiska vapen och kemiska vapen förbjöds också, inte bara av etiska och humanitära skäl, men också för det destabiliserande hot de utgjorde.

Nästa FN-möte om LAWS kommer att hållas i augusti 2018, och undertecknarna av löftet hoppas att deras löfte kommer att uppmuntra lagstiftare att utveckla ett åtagande för ett internationellt avtal mellan länder.

Som löftet säger:"Vi, den undertecknade, uppmana regeringar och regeringsledare att skapa en framtid med starka internationella normer, föreskrifter och lagar mot dödliga autonoma vapen. ... Vi ber att teknikföretag och organisationer, såväl som ledare, beslutsfattare, och andra individer, gå med oss i detta löfte."

Den fullständiga texten till löftet

Artificiell intelligens (AI) är redo att spela en allt större roll i militära system. Det finns en akut möjlighet och nödvändighet för medborgarna, beslutsfattare, och ledare att skilja mellan acceptabel och oacceptabel användning av AI.

I det här ljuset, vi undertecknade är överens om att beslutet att ta ett människoliv aldrig bör delegeras till en maskin. Det finns en moralisk komponent i denna position, att vi inte ska tillåta maskiner att fatta livsavgörande beslut som andra – eller ingen – kommer att vara skyldiga till.

Det finns också ett kraftfullt pragmatiskt argument:dödliga autonoma vapen, att välja och engagera mål utan mänsklig inblandning, skulle vara farligt destabiliserande för varje land och individ. Tusentals AI-forskare är överens om att genom att ta bort risken, hänförbarhet, och svårigheter att ta människoliv, dödliga autonoma vapen kan bli kraftfulla instrument för våld och förtryck, särskilt när det är kopplat till övervaknings- och datasystem.

Dessutom, dödliga autonoma vapen har egenskaper helt annorlunda än kärnvapen, kemiska och biologiska vapen, och en enskild grupps ensidiga handlingar kan alltför lätt utlösa en kapprustning som det internationella samfundet saknar tekniska verktyg och globala styrsystem för att hantera. Att stigmatisera och förhindra en sådan kapprustning borde ha hög prioritet för nationell och global säkerhet.

Vi, den undertecknade, uppmana regeringar och regeringsledare att skapa en framtid med starka internationella normer, föreskrifter och lagar mot dödliga autonoma vapen. Dessa är för närvarande frånvarande, vi väljer att hålla oss till en hög standard:vi kommer varken att delta i eller stödja utvecklingen, tillverkning, handel, eller användning av dödliga autonoma vapen. Vi ber att teknikföretag och organisationer, såväl som ledare, beslutsfattare, och andra individer, gå med oss i detta löfte.