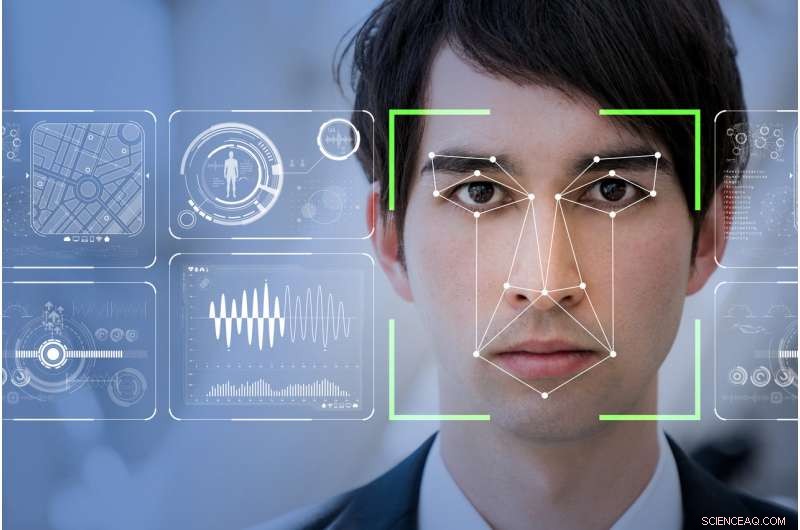

Kommer mjukvara för ansiktsigenkänning att göra världen till en säkrare plats, som teknikföretag hävdar, eller kommer det att göra de marginaliserade mer sårbara och övervakade? Kredit:Shutterstock

Min mamma sa alltid att jag hade ett ansikte för radio. Tack Gud, eftersom radio kan vara den sista platsen i denna teknikförbättrade värld där ditt ansikte inte kommer att avgöra din sociala status eller potential att begå ett brott.

RealNetworks, den globala ledaren av en teknik som möjliggör sömlös digital leverans av ljud- och videofiler över internet, har precis släppt sin senaste datorvision:Ett programpaket för maskininlärning. Förhoppningen är att denna nya programvara kommer att upptäcka, och potentiellt förutsäga, misstänkt beteende genom ansiktsigenkänning.

Kallas SAFR (Secure, Exakt ansiktsigenkänning), verktygsuppsättningen har marknadsförts som ett kostnadseffektivt sätt att smidigt smälta in i befintliga CCTV-videoövervakningssystem. Den kommer att kunna "upptäcka och matcha miljontals ansikten i realtid, " speciellt inom skolmiljöer.

Tydligen, RealNetworks ser sin teknik som något som kan göra världen säkrare. Det medryckande varumärket, dock, maskerar de verkliga etiska frågorna kring användningen av ansiktsdetektionssystem. Några av dessa problem inkluderar frågor om de inneboende fördomar som är inbäddade i koden och, i sista hand, hur den insamlade informationen används.

Den kinesiska modellen

Storebror tittar. Inget annat land i världen har mer videoövervakning än Kina. Med 170 miljoner CCTV-kameror och cirka 400 miljoner nya som installeras, det är ett land som har antagit och implementerat ansiktsigenkänning på ett orwellskt sätt.

Inom en snar framtid, dess medborgare, och de av oss som reser dit, kommer att exponeras för ett stort och integrerat nätverk av ansiktsigenkänningssystem som övervakar allt från användningen av kollektivtrafik, att fortköra till hur mycket toalettpapper man använder på den offentliga toaletten.

Det mest störande inslaget hittills är det nyligen införandet av ansiktsigenkänning för att övervaka skolbarns beteende i kinesiska offentliga skolor.

Som en del av Kinas fullständiga integration av deras lika orwellska sociala kreditsystem – ett incitamentsprogram som belönar varje medborgares engagemang för statens dikterade moral – kommer detta helt integrerade digitala system automatiskt att identifiera en person. Det kan sedan avgöra ens förmåga att göra framsteg i samhället – och i förlängningen den personens närmaste familjs ekonomiska och sociala status – genom att övervaka statens icke-sanktionerade beteende.

I huvudsak, ansiktsigenkänning gör det omöjligt för de som utsätts att ha lyxen att ha en dålig dag.

Ansiktsigenkänningssystem som nu används i kinesiska skolor övervakar allt från klassrumsdeltagande till om ett barn dagdrömmer eller uppmärksammar. Det är ett komplett övervakningssystem som bestämmer, i stor utsträckning, ett barns framtid utan att beakta att vissa egenskaper, som abstrakta tankar, kan inte lätt upptäckas eller i bästa fall, såg positivt på, med ansiktsigenkänning.

Det väcker också några mycket obekväma föreställningar om etik eller bristen på sådan, särskilt mot mer utsatta samhällsmedlemmar.

Behov av offentlig reglering

RealNetworks lansering av SAFR kommer varmt i hälarna på Microsofts president Brad Smiths passionerade manifest om behovet av offentlig reglering och företagsansvar i utvecklingen och implementeringen av ansiktsigenkänningsteknik.

Smith påpekade med rätta att ansiktsigenkänningsverktyg fortfarande är något skeva och har "större felfrekvenser för kvinnor och färgade". Detta problem är dubbelt, med ett erkännande av att människorna som kodar omedvetet kan inbädda kulturella fördomar.

De datauppsättningar som för närvarande är tillgängliga kan sakna den objektiva robusthet som krävs för att säkerställa att människors ansikten inte blir felidentifierade, eller ännu värre, förutbestämd genom kodad bias som nu börjar hända i det kinesiska skolsystemet.

I ett försök att ta itu med detta och många andra relaterade frågor, Microsoft inrättade en kommitté för AI och etik inom teknik och forskning (AETHER). Denna kommitté är också inrättad för att hjälpa dem att följa EU:s nyligen verkställda allmänna dataskyddsförordning (GDPR) och dess eventuella framtida antagande, i någon form, i Nordamerika.

Smiths ivriga vädjan ifrågasätter med rätta den nuvarande och framtida avsedda användningen och distributionen av system för ansiktsigenkänning, men misslyckas med att ta itu med hur Microsoft eller, i förlängningen, andra ledare inom AI-teknik, kan eliminera fördomar inom deras baskod eller datamängder från början.

Minoritetsrapport

Vårt ansiktsdrag är knappast mer än gester som vanans kraft har gjort permanent .—Marcel Proust, 1919

Liksom många tekniker, Pandora har redan lämnat lådan. Om du äger en smart telefon och använder internet, du har redan valt bort alla grundläggande föreställningar om personlig anonymitet inom det västerländska samhället.

Med GDPR nu fullt engagerat i Europa, ett besök på en webbplats kräver nu att du "väljar" till möjligheten att den webbplatsen kan samla in personuppgifter. Ansiktsigenkänningssystem har inga möjligheter att följa GDPR-reglerna, så som sådan, vi som samhälle är automatiskt "opted-in" och därmed helt utlämnade till hur våra ansikten registreras, behandlas och lagras av statliga, företags- eller till och med privata CCTV-system.

Ansiktsigenkänningsförsök som hålls i England av London Metropolitan Police har konsekvent gett 98 procent misslyckande. Liknande, i sydvästra Wales, tester har bara gjort något bättre med mindre än 10 procents framgång.

Omvänt, University of California, Berkeley, Forskare har kommit fram till att substantiell ansiktsvariation är en evolutionär egenskap som är unik för människor. Så var är frånkopplingen?

Om som Marcel Proust har föreslagit, våra liv och därmed våra personligheter är unikt identifierbara av våra ansikten, varför kan inte ansiktsigenkänningssystem inte lätt ge positiva resultat?

Svaret går tillbaka till hur datorprogrammering skrivs och de datamängder som används av den koden för att returnera en positiv matchning. Oundvikligen, kod är skriven för att stödja en idealiserad uppfattning om ansiktstyp.

Som sådan, yttre variationer som naturligt förekommande ansiktsdeformiteter eller ansiktsdrag påverkade av fysiska eller psykiska trauman representerar bara en liten bråkdel av de oändliga möjliga ansiktsvariationerna i världen. Datauppsättningarna antar att vi är homogena dubbelgängare av varandra, without addressing the micro-variations of peoples faces.

Om så är fallet, we are all subject to the possibility that our faces as interpreted by the ever-increasing deployment of immature facial recognition systems will betray the reality of who we are.

Denna artikel publicerades ursprungligen på The Conversation. Läs originalartikeln.