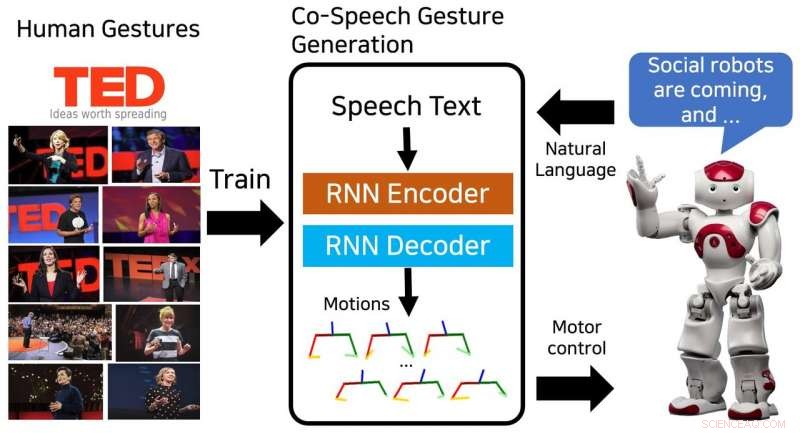

Den föreslagna modellen genererar en sekvens av överkroppsställningar och tränas i mänskliga gester från TED -samtal. Upphovsman:Yoon et al.

Forskare vid Electronics and Telecommunications Research Institute (ETRI) i Sydkorea har nyligen utvecklat en neural nätverksmodell som kan generera sekvenser av co-speech-gester. Deras modell, tränade på 52 timmars TED -samtal, framgångsrikt producerat mänskliga gester som matchade talinnehåll.

"Smarta enheter vi interagerar med har utvecklats från persondatorer till mobiltelefoner och smarta högtalare, "Youngwoo Yoon, en av forskarna som genomförde studien, berättade TechXplore. "Vi tror att sociala robotar kan vara nästa interaktionsplattform. Fysisk rörelse är en av de viktigaste skillnaderna mellan sociala robotar och andra smarta enheter, öppna nya möjligheter för att efterlikna mänskliga eller djurliknande beteenden, vilket kan öka intimiteten. "

Co-speech-gester kan avsevärt förbättra kvaliteten på interaktioner mellan människor och sociala robotar. De flesta befintliga robotar producerar gester med hjälp av regelbaserade metoder för tal-gest-associering. Dock, dessa tekniker kräver stora ansträngningar, eftersom de är baserade på mänsklig expertis och kunskap.

"Vi ville generera naturliga och mänskliga sociala beteenden, särskilt handgester när du talar, "Sa Yoon." Att observera andra är ett mycket naturligt sätt att lära sig ett nytt beteende, så vi föreslog en inlärningsbaserad gestgenereringsmodell som utbildades i en dataset med TED-samtal. "

Modellen som utformades av Yoon och hans kollegor utbildades i en datamängd som innehåller 52 timmars videofilmer från TED -samtal. Efter träning, modellen kan generera sekvenser av mänskliga gester och överkroppsställningar för att matcha skriven taltext.

"Att utforma robotarnas sociala beteenden är svårt och tidskrävande eftersom vi måste överväga sammanhang, naturlighet, rörelsens estetik, robotens kontrollutrymme, och ett antal andra faktorer, "Yoon förklarade." De senaste end-to-end inlärningsstudierna har belyst potentialen för artificiell intelligens att generera så komplexa beteenden. Efter att ha sett framgångsrika tillämpningar inom autonom körning och ansiktsrörelsegenerering, vi bestämde oss för att tillämpa end-to-end inlärning på generering av co-speech gest. "

Den neurala nätverksmodellen som utvecklats av Yoon och hans kollegor genererade framgångsrikt flera typer av gester, inklusive ikoniska, metaforisk, deiktisk, och slå gester. Dessutom, den kunde generera kontinuerliga sekvenser av gester för taltexter av valfri längd.

Forskarna fann att deras metod överträffade baslinjemetoder för att skapa gester som liknar människors. I en subjektiv utvärdering, 46 personer som rekryterades på Amazon Mechanical Turk kände att gesterna det genererade var mänskliga och passade nära talinnehållet.

"Vi fann att robotar kan lära sig sociala färdigheter, "Sa Yoon." För med-tal-gestgenerationen, modellen som är utbildad på den stora datauppsättningen är tillräckligt generell, så att roboten kan göra människoliknande gester för alla tal. Vi tror att detta tillvägagångssätt kan tillämpas på andra sociala färdigheter, såväl som karaktärer i videospel och VR -världar. "

Studien som utfördes av Yoon och hans kollegor belyste potentialen i end-to-end-lärande för generering av co-speech gest. I framtiden, den kan användas för att förbättra människa-robot-interaktioner och kan också inspirera till liknande forskning, eftersom TED -taldatasatsen de använde är allmänt tillgänglig. Forskarna planerar nu att ta sin studie ett steg framåt, genom att generera personliga gester för olika robotar.

"Robotar kan ha sin egen personlighet, som människor, "Sa Yoon." En personlig gestgenereringsmetod kan säkerställa att olika robotar uttrycker sig med olika geststilar, enligt deras personlighet. "

© 2018 Science X Network