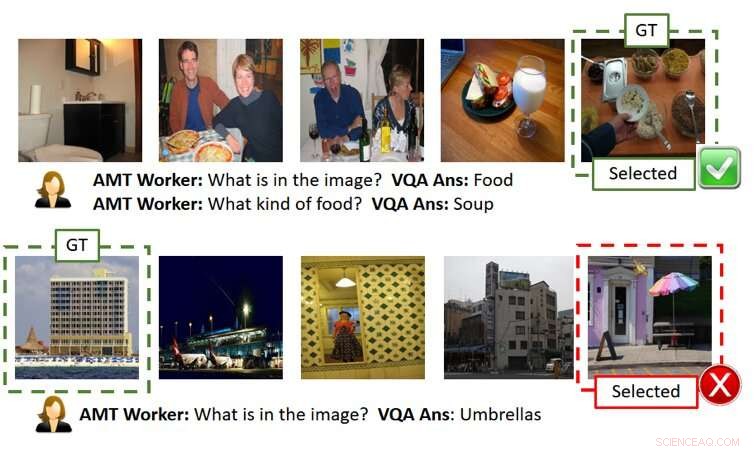

Bilden ovan visar två spel utan förklaringar (varje rad är ett spelexempel). Som visas i den översta raden, användaren (dvs. AMT Worker sedan vi har använt Amazon Mechanical Turk för storskalig publikbaserad utvärdering) kan ta reda på den hemliga bilden korrekt givet korrekta AI-svar. Dock, som visas i den nedre raden, användaren kan misslyckas även när AI-svaren är rimliga men något fel (dvs. det finns en paraplyliknande struktur bredvid byggnaden även om den inte är i fokus för bilden av grunden). GT betyder Ground Truth (dvs den hemliga bilden), Vald är bilden som valts av användaren efter att ha ställt frågorna och fått svaren och/eller förklaringarna. Kredit:Ray et al.

På senare år har Forskare har försökt göra artificiell intelligens (AI) mer transparent genom att utveckla algoritmer som kan förklara deras handlingar och beteende, eftersom detta kan uppmuntra större förtroende för maskiner och förbättra interaktioner mellan människa och AI. Trots deras ansträngningar, Hittills har väldigt få studier på ett konkret sätt utvärderat effekten av AI-förklaringar på prestanda som uppnås i uppgifter som involverar samarbete mellan människa och AI.

För att komma till rätta med denna lucka i den befintliga litteraturen, ett team av forskare vid SRI International har skapat ett gissningsspel för mänsklig AI-bild inspirerat av det populära spelet 20 Questions (20Q), som kan användas för att utvärdera användbarheten av maskinförklaringar. Deras papper, nyligen publicerad på arXiv, är bland de första att utforska effekterna av att utveckla mer "förklarlig" AI.

"Idén kom till när vi arbetade med ett DARPA-projekt, "Arijit Ray, en datavetare vid SRI International som utförde studien, berättade för TechXolore. "I detta projekt, vi utvecklar förklarliga AI-system, som inte bara genererar det önskade resultatet (t.ex. objektdetektering, svar på frågor, etc.) men också förklaringar av hur de kom fram till den utgången. Vi behövde en mekanism för att utvärdera om de ytterligare förklaringarna från AI var användbara för att användaren skulle få en bättre förståelse av AI-systemen. För detta ändamål, vi skapade en interaktiv människa-AI-samarbetsuppgift, Förklaringsassisterad GuessWhich (ExAG), som är en anpassning av det berömda 20Q-spelet, för att visa effektiviteten hos de olika maskinförklaringstekniker som vi utvecklar."

Bildgissningsspelet utvecklat av Ray och hans kollegor liknar det populära spelet 20 Questions, som vanligtvis involverar två spelare. Under 20Q, en spelare tänker på något och den andra spelaren försöker gissa vad det är genom att ställa 20 slutna frågor (dvs. frågor som endast kan besvaras med "ja" eller "nej").

I ExAG, anpassningen av spelet skapat av Ray och hans kollegor, en användare visas fem bilder, varav en har valts av AI-systemet som den "hemliga bilden". Väsentligen, användaren måste ta reda på vilken av bilderna han/hon såg är den "hemliga bilden, genom att ställa frågor om det naturliga språket.

I motsats till det traditionella 20Q-spelet, i ExAG kan mänskliga användare ställa både slutna och öppna frågor. Till exempel, de skulle kunna fråga 'vad finns på bilden?, ' 'var är bilden tagen?' och så vidare. AI-systemet svarar på en användares frågor en i taget och kan valfritt förklara sina svar.

Baserat på dessa svar, Användaren kommer sedan att försöka gissa bilden som AI:n ursprungligen hade valt. Det övergripande målet med spelet är att korrekt identifiera den "hemliga bilden" genom att ställa så få frågor som möjligt.

"AI-systemet ger två förklaringssätt, visuella och textuella, "Ray förklarade. "För visuella förklaringar, AI-systemet genererar värmekartor som framhäver de regioner som stöder dess svar. Till exempel, om en användare frågar vad som finns på bilden, och det ser ut som en hund, AI kommer att lyfta fram hundregionen och säga att detta är vad som leder till svaret "det är en hund." För textförklaringar, å andra sidan, AI-systemet ger svar på relaterade frågor för var och en av bilderna. Så, om du frågar vad en person gör och svaret är att surfa, till exempel, det kommer också att svara på relaterade frågor som 'vad ser jag på bilden? En surfare.' 'Var är bilden tagen? En strand.'

På grund av bildgissningsspelets natur, kvaliteten på svaren och förklaringarna som tillhandahålls av AI kan avsevärt påverka en mänsklig användares framgång och prestanda. Det är värt att notera att nuvarande toppmoderna prestanda inom visuell frågesvar är cirka 65 procent, vilket innebär att AI-systemet genererar korrekta svar 65 procent av tiden.

Ray och hans kollegor observerade att användare vanligtvis lyckades med ExAG genom att dra fördel av AI:s förklaringar, speciellt när svaren i sig var felaktiga. Till exempel, om den "hemliga bilden" porträtterar en hund, men AI svarar "det är en surfare, ' en visuell förklaring kan hjälpa en mänsklig användare att inse AI:s misstag. Enligt forskarna, detta bevisar att deras spel är ett lämpligt verktyg för att utvärdera användbarheten av AI-förklaringar.

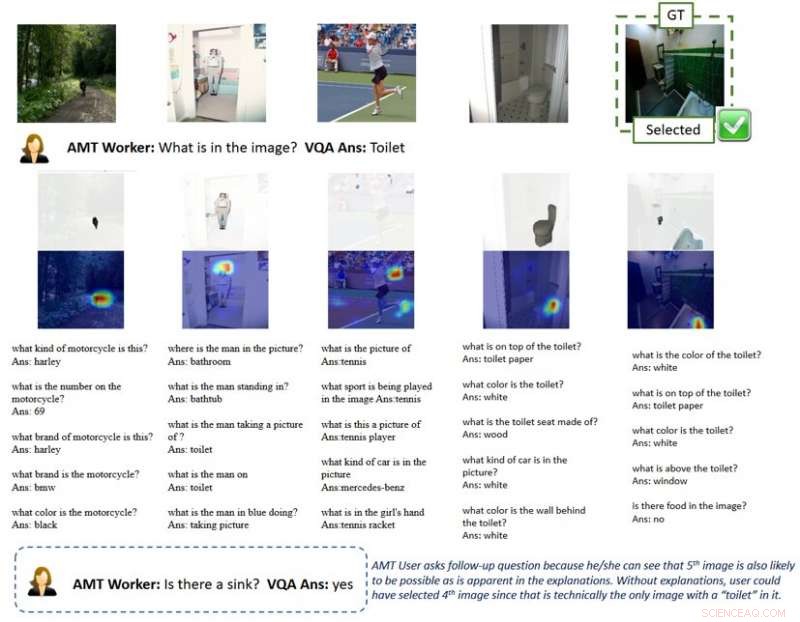

Bilden ovan visar ett spel med förklaringar. Värmekartans visuella förklaring framhäver regionerna i bilderna som leder till AI-svar. Med en sådan förklaring, användare får förståelse för att AI-system kan plocka upp objekt som inte är bildens huvudfokus i människans perspektiv när de svarar på en allmän fråga som "vad finns i bilden". Detta tipsar användaren om att ställa uppföljningsfrågor och slutligen välja den hemliga bilden korrekt. GT betyder Ground Truth (dvs den hemliga bilden), Vald är bilden som valts av användaren efter att ha ställt frågorna och fått svaren och/eller förklaringarna. Kredit:Ray et al.

"Enligt min åsikt, det mest intressanta resultatet av vår studie är att användare kan använda bara några bra förklaringar för att vinna spel när AI-svaren oftast är fel, " sa Ray. "Däremot, för spel med liknande svarsnoggrannhet men utan förklaringar, användare litar blint på AI-genererade svar och förlorar spelet. Detta stöder vikten av till och med ett fåtal bra förklaringar till ett samarbetssystem mellan människa och AI, speciellt när AI-systemet är ofullkomligt, vilket det är i de flesta fall nuförtiden."

För att förklara denna idé bättre, Ray erbjuder exemplet med självkörande fordon. Under de senaste åren, det har varit mycket debatt om deras säkerhet, även på grund av olyckor som inträffade medan fordonen testades. Enligt Ray, effektiva AI-förklaringar skulle kunna uppmuntra till större förtroende för säkerheten hos självkörande fordon, eftersom de skulle göra det möjligt för mänskliga förare att identifiera problem i förväg och förhindra olyckor.

"Till exempel, låt oss anta att AI-systemet har problem med att upptäcka körfälten på ett tillförlitligt sätt, " sa Ray. "Eftersom vägen för närvarande är rak, utan ytterligare information, Användaren skulle inte kunna säga om AI:n misslyckas. Även om han/hon hade vissa tvivel, han/hon skulle förmodligen inte göra något förrän i sista stund, när bilen måste ta en sväng, gör det inte, och kraschar, vilket skulle vara för sent. I kontrast, om en skärm i bilen visade förklaringar av hur AI uppfattar miljön, som värmekartor, användaren skulle kunna berätta för AI:s latenta fel och ta kontroll över hjulet i förväg."

Forskarna fann att användbara förklaringar positivt påverkade mänskliga användares prestanda i bildgissningsspelet. Deras resultat tyder på att det var till stor hjälp att ha åtminstone en "korrekt" förklaring, särskilt i fall där AI:s svar på användarfrågor var "bullriga" eller dåligt definierade. Intressant, spelare utvecklade en preferens för förklaringar framför svar och bedömde ofta AI-förklaringarna som "hjälpsamma".

"Jag tror att medan flera arbetslinjer försökte ge förklaringar till ett AI-systems resultat eller handlingar, vår är den första studien som introducerar en samarbetsuppgift mellan människor och maskiner för att utvärdera effektiviteten av AI-förklaringar; Således, det gav en hel del insikt i hur AI-förklaringar kan förbättra interaktioner mellan människa och robot, "Yi Yao, en senior teknisk chef på SRI International som var involverad i studien, berättade för TechXplore.

Studien utförd av Ray och hans kollegor är en av de första som ger konkreta bevis på användbarheten av AI-förklaringar. Forskarna hoppas att deras forskning i slutändan kommer att informera om utvecklingen av AI-system som kan agera rationellt i samhället, på så sätt ansluta och relatera bättre till människor.

Enligt Ray, AI-system som tydligt kan förklara resonemanget och processerna bakom deras handlingar skulle vara ett betydande steg framåt i utvecklingen av intelligenta maskiner. Genom att effektivt svara på frågor och rationalisera sina beslut, dessa system skulle kunna främja en större känsla av förtroende för AI, samt en djupare relation till den.

"Många andra företag, grupper och forskargrupper har behandlat förklarlig AI, och det har funnits många förslag på hur man kan utöka befintliga AI-modeller och system för att ge förklaringar till användarna, sade Giedrius Burachas, en senior datavetare vid SRI International och huvudutredare bakom DARPA-studien som ledde till utvecklingen av spelet Guess Which. "Medan det genererades massor av idéer, bevis på att dessa idéer saknades, så en av de starka sidorna av vår forskning är att den ger obestridliga bevis för att vissa typer av förklaringar verkligen är mycket effektiva för att förbättra samarbetet med AI-systemen, men också för att bygga förtroende för dem."

Ända tills nu, Rays och hans kollegors arbete fokuserade främst på visuella frågor svarande (VQA) uppgifter, där användare ställer frågor om bilder och en AI svarar. De planerar nu att fortsätta sin forskning om AI-förklaringstekniker, att tillämpa dessa tekniker på ett bredare spektrum av AI-uppgifter.

"Vi kommer också att fortsätta utveckla protokoll för att utvärdera effektiviteten av de AI-genererade förklaringarna med finare granularitet (t.ex. vilken förklaring är mer effektiv under vilka scenarier?) och från olika perspektiv (t.ex. hjälper förklaringar användare att bygga den mentala modellen?), " sa Ray. "För att stänga slingan, vi kommer att använda lärdomar från dessa utvärderingar för att utveckla effektivare förklaringsmetoder. Vi tror att den heliga gralen med förklarlig AI är att skapa förklaringar som inte bara informerar användare utan också förbättrar maskinens prestanda genom att förbättra dess resonemangsförmåga."

Förutom att utforska effekterna av AI-förklaringar på prestanda och uppfattningar hos mänskliga användare, därför, forskarna skulle vilja undersöka deras inverkan på själva AI-systemen. De anser att AI-förklaringar också kan göra AI-system bättre, eftersom de gradvis skulle förvärva resonemang och rationaliseringsförmåga.

© 2019 Science X Network