Kredit:Ji Lin

Smartphones, säkerhetskameror, och högtalare är bara några av de enheter som snart kommer att köra mer artificiell intelligens för att påskynda bild- och talbearbetningsuppgifter. En komprimeringsteknik som kallas kvantisering är att jämna ut vägen genom att göra modeller för djupinlärning mindre för att minska beräknings- och energikostnader. Men mindre modeller, det visar sig, göra det lättare för illvilliga angripare att lura ett AI-system att missköta sig – ett problem eftersom mer komplext beslutsfattande överlämnas till maskiner.

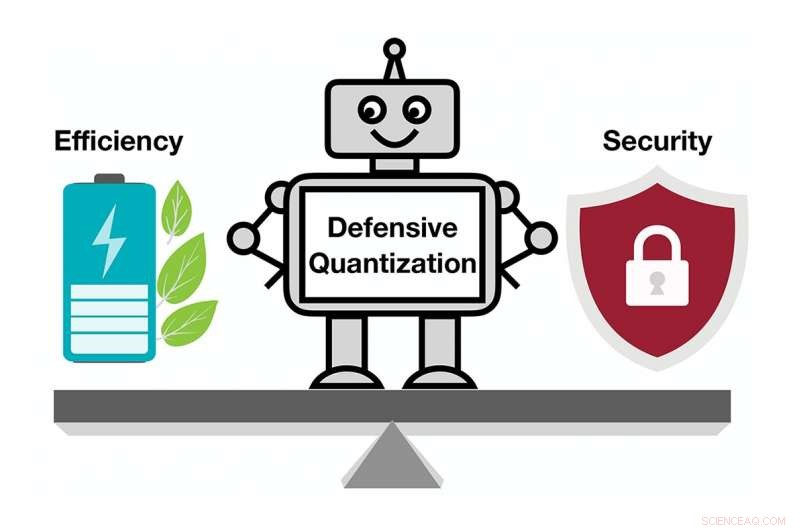

I en ny studie, MIT- och IBM-forskare visar hur sårbara komprimerade AI-modeller är för motståndsangrepp, och de erbjuder en lösning:lägg till en matematisk begränsning under kvantiseringsprocessen för att minska oddsen för att en AI kommer att falla offer för en något modifierad bild och felklassificera det de ser.

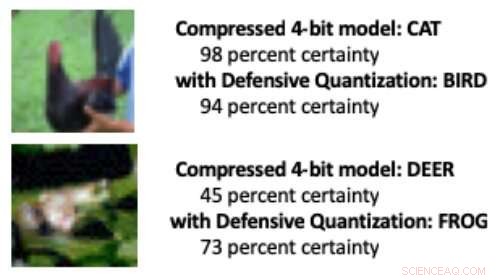

När en djupinlärningsmodell reduceras från standard 32 bitar till en lägre bitlängd, det är mer sannolikt att ändrade bilder felklassificeras på grund av en felförstärkningseffekt:Den manipulerade bilden blir mer förvrängd för varje extra lager av bearbetning. I slutet, modellen är mer benägen att missta en fågel för en katt, till exempel, eller en groda för ett rådjur.

Modeller kvantiserade till 8 bitar eller färre är mer mottagliga för motståndsangrepp, forskarna visar, med noggrannhet som faller från redan låga 30-40 procent till mindre än 10 procent när bitbredden minskar. Men att kontrollera Lipschitz-begränsningen under kvantisering återställer en viss motståndskraft. När forskarna lade till begränsningen, de såg små prestandavinster i en attack, med de mindre modellerna som i vissa fall överträffar 32-bitarsmodellen.

När några pixlar manipulerades i ovanstående bilder för att simulera en motståndskraftig attack, en standard komprimerad modell felklassificerade kycklingen som "katt" och grodan som "hjort". Men när forskare lade till en begränsning under komprimering, modellen klassificerade djuren korrekt, presterar till och med bättre än en 32-bitarsmodell med full precision. Kredit:Massachusetts Institute of Technology

"Vår teknik begränsar felförstärkning och kan till och med göra komprimerade djupinlärningsmodeller mer robusta än modeller med full precision, säger Song Han, en biträdande professor vid MIT:s institution för elektroteknik och datavetenskap och medlem av MIT:s Microsystems Technology Laboratories. "Med korrekt kvantisering, vi kan begränsa felet."

Teamet planerar att ytterligare förbättra tekniken genom att träna den på större datamängder och tillämpa den på ett bredare utbud av modeller. "Deep learning-modeller måste vara snabba och säkra när de flyttar in i en värld av internetanslutna enheter, " säger studiemedförfattare Chuang Gan, en forskare vid MIT-IBM Watson AI Lab. "Vår defensiva kvantiseringsteknik hjälper på båda fronterna."

Forskarna, som inkluderar MIT-studenten Ji Lin, presentera sina resultat vid den internationella konferensen om läranderepresentationer i maj.

Genom att göra AI-modeller mindre så att de går snabbare och använder mindre energi, Han använder AI själv för att tänja på gränserna för modellkompressionsteknik. I besläktat senaste arbete, Han och hans kollegor visar hur förstärkningsinlärning kan användas för att automatiskt hitta den minsta bitlängden för varje lager i en kvantifierad modell baserat på hur snabbt enheten som kör modellen kan bearbeta bilder. Denna flexibla bitbreddsmetod minskar latens och energianvändning med så mycket som 200 procent jämfört med en fast, 8-bitars modell, säger Han. Forskarna kommer att presentera sina resultat vid konferensen Computer Vision and Pattern Recognition i juni.

Den här historien återpubliceras med tillstånd av MIT News (web.mit.edu/newsoffice/), en populär webbplats som täcker nyheter om MIT-forskning, innovation och undervisning.