Den ursprungliga inmatningsbilden. Upphovsman:Lee et al.

Forskare vid IBM Research UK, U.S.Military Academy och Cardiff University har nyligen föreslagit en ny metod för att förbättra känsligheten för LIME (Local Interpretable Model Agnostic Explanations), en teknik för att uppnå en bättre förståelse av slutsatserna som nås av maskininlärningsalgoritmer. Deras papper, publicerad på SPIE digitala bibliotek, kan informera utvecklingen av artificiell intelligens (AI) -verktyg som ger uttömmande förklaringar om hur de nått ett visst resultat eller slutsats.

"Vi tror att AI och maskininlärning kan stödja och förstärka mänskligt beslutsfattande, men att det också finns ett behov av förklarlig AI, "Eunjin Lee, medförfattare till det ursprungliga forskningsdokumentet och Emerging Technology Specialist och Senior Inventor vid IBM Research U.K., berättade TechXplore. "I dag, beslut som tas av många maskininlärningssystem är oförklarliga, dvs. det finns inget sätt för oss människor att veta hur systemen kom till dessa beslut. Vår forskning tar itu med detta problem genom att undersöka hur man kan förbättra förklaringstekniker som syftar till att belysa den "svarta lådan" i maskininlärningsprocesser."

LIME är en särskilt populär förklaringsteknik som kan tillämpas på många maskininlärningsmodeller. Trots sin mångsidighet, det ses ofta som opålitligt och därmed ineffektivt att ge förklaringar, också på grund av variationen i resultaten det ger. Istället för att utveckla en helt ny förklaringsteknik, Lee och hennes kollegor försökte identifiera mekanismer som kan förbättra LIME -förklaringar.

"Vi ville först titta djupare på den instabilitet som andra forskare har observerat för att avgöra om LIME verkligen var instabil, "Förklarade Lee." För att göra detta, vi testade LIME mot vår datamängd och maskininlärningsmodell utan att ändra den underliggande koden. Vi fann omedelbart att de resulterande förklaringsbilderna varierade avsevärt och inte verkade konsekventa. Detta är kanske den punkt där många helt enkelt skulle sluta använda tekniken. "

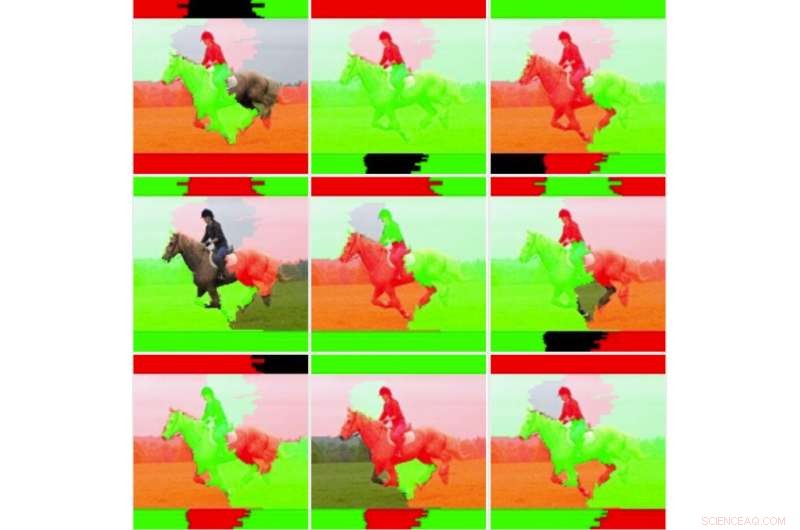

Nio bildutmatningar för den omodifierade LIME -tekniken. Kredit:Lee et al.

När Lee och hennes kollegor grävde djupare i LIME:s underliggande statistik, de upptäckte att även om bilderna det genererade verkade vara "visuellt instabila, " standardförklaringen tog inte hänsyn till all statistisk information. Till exempel, färgläggningen av förklaringsbilder var för enkel och tog inte hänsyn till hela underliggande data (t.ex. tog inte hänsyn till tekniker som skuggning eller transparens). Detta fynd förklarar delvis varför förklaringar som genereras av LIME ibland misslyckas med att förmedla säkerheten om klassificering till mänskliga användare.

"Det är ofta fallet för dynamiska system, som de vi undersökte i denna studie, att köra många tester och undersöka medelvärden kan visa sig vara fördelaktigt, "Sade Lee." När jag tog detta tillvägagångssätt, vi insåg att stabiliteten hos förklaringarna förbättrades när man övervägde medelvärden och standardavvikelser över flera körningar snarare än att bara köra förklaringen en gång."

I deras studie, Lee och hennes kollegor tränade en CNN-modell (convolutional neural network) med hjälp av två klasser av bilder, nämligen "vapendragare" och "icke-svingare". De fann att LIME:s känslighet förbättrades när flera utdatavikter för individuella bilder beräknades och visualiserades.

Forskarna jämförde sedan dessa genomsnittliga bilder med individuella bilder för att utvärdera variabiliteten och tillförlitligheten hos de två LIME-metoderna (dvs. den traditionella metoden och den de föreslog). De fann att traditionella LIME -tekniker, utan de justeringar de gjorde, verkade vara instabil på grund av den enkla binära färgningen de använde och den lätthet med vilken färgade områden flippade när man jämför olika analyser. Lee och hennes kollegor observerade också att de betydligt viktade bildområdena var konsekventa, medan de lägre viktade regionerna vände tillstånd, på grund av den inneboende instabiliteten hos LIME -tekniker.

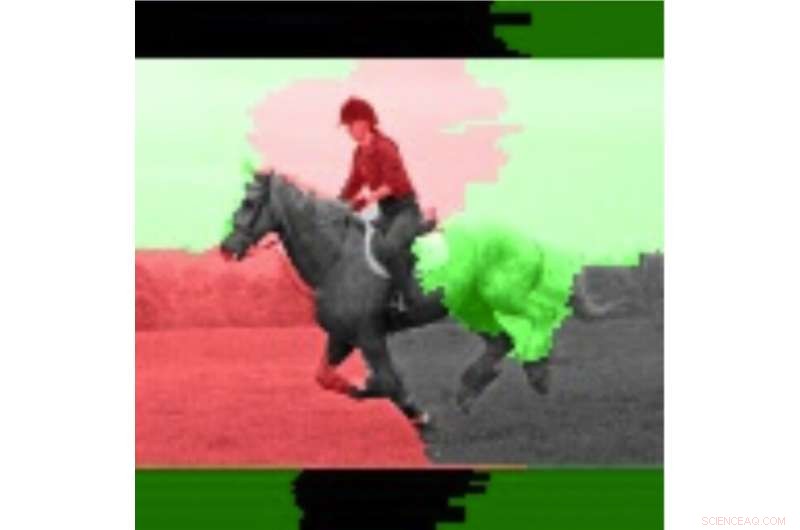

Bilden markerad med hjälp av den genomsnittliga informationen. Upphovsman:Lee et al.

"Tekniker som LIME visar ett stort löfte för AI -förklaring, speciellt i en tid då det inte är lätt, lättillgängliga förklaringsmöjligheter för maskininlärningssystem, "Sade Lee." Även om den upplevda instabiliteten är motiverad, det finns tekniker som kan hjälpa till att lindra detta problem. Dessa tekniker har ytterligare beräkningskostnader, t.ex. att köra förklaringen flera gånger vilket innebär att användaren kommer att ha en större fördröjning när det gäller att generera förklaringen."

Studien Lee och hennes kollegor genomförde ger en värdefull förklaring av några av faktorerna bakom LIME:s instabilitet, som observerats i tidigare forskning. Deras resultat tyder på att förbättrade viktningsmetoder för förklaringstekniker kan öka deras stabilitet och leda till mer tillförlitliga förklaringar, i slutändan främja ett större förtroende för AI. Framtida forskning skulle kunna identifiera mer avancerade numeriska tekniker för att ytterligare förbättra stabiliteten hos LIME och andra förklaringsmetoder och samtidigt minska den extra omkostnaden.

"Vi har ett pågående intresse för ansvarsfulla AI -system som innehåller förklaringar men också mildrar partiskhet och förbättrar robusthet och transparens, "Sa Lee. "Att förbättra förmågan för utvecklare att enklare bädda in förklaringstekniker i sina AI-lösningar är ett nyckelmål för oss. Nyligen, IBM lanserade en mjukvarutjänst som automatiskt upptäcker bias och förklarar hur AI fattar beslut."

© 2019 Science X Network