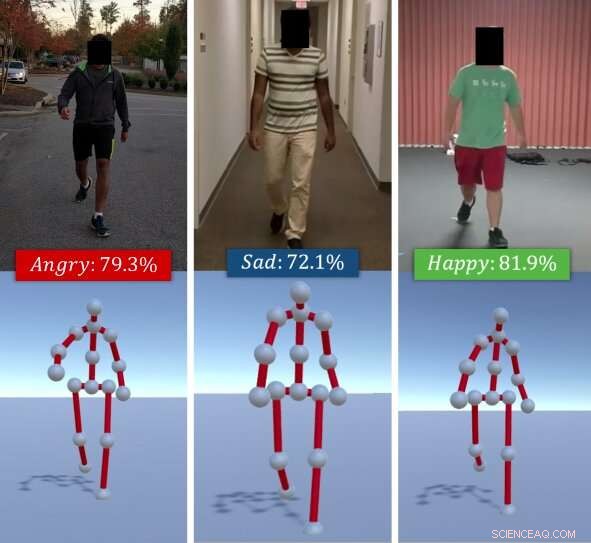

Algoritmen identifierar de upplevda känslorna hos individer utifrån deras gångstilar. Med tanke på en RGB -video av en individuell promenad (överst), forskarnas metod extraherar hans/hennes gångart som en serie av 3D -poser (botten). Den använder sedan en kombination av djupa funktioner som lärt sig via en LSTM och affektiva funktioner som beräknas med hjälp av hållning och rörelsekoder och klassificerar dessa i grundläggande känslor (t.ex. Lycklig, ledsen, etc.), med hjälp av en Random Forest Classifier. Upphovsman:Randhavane et al.

Ett team av forskare vid University of North Carolina i Chapel Hill och University of Maryland på College Park har nyligen utvecklat en ny modell för djupinlärning som kan identifiera människors känslor utifrån deras vandringsstilar. Deras tillvägagångssätt, beskrivs i ett papper som för publicerats på arXiv, fungerar genom att extrahera en individs gång från en RGB -video av honom/henne som går, sedan analysera det och klassificera det som en av fyra känslor:glad, ledsen, arg eller neutral.

"Känslor spelar en viktig roll i våra liv, definiera våra erfarenheter, och utforma hur vi ser på världen och interagerar med andra människor, "Tanmay Randhavane, en av de primära forskarna och en doktorand vid UNC, berättade TechXplore. "Att uppfatta andra människors känslor hjälper oss att förstå deras beteende och bestämma våra handlingar gentemot dem. Till exempel, människor kommunicerar väldigt annorlunda med någon som de uppfattar som arga och fientliga än de gör med någon som de uppfattar som lugna och nöjda. "

De flesta befintliga verktyg för känseligenkänning och identifiering fungerar genom att analysera ansiktsuttryck eller röstinspelningar. Dock, tidigare studier tyder på att kroppsspråk (t.ex. hållning, rörelser, etc.) kan också säga mycket om hur någon mår. Inspirerad av dessa observationer, forskarna bestämde sig för att utveckla ett verktyg som automatiskt kan identifiera den upplevda känslan hos individer utifrån deras gångstil.

"Den största fördelen med vårt upplevda känslomässiga igenkänningssätt är att det kombinerar två olika tekniker, "Randhavane sa." Förutom att använda djupinlärning, vårt tillvägagångssätt utnyttjar också resultaten av psykologiska studier. En kombination av båda dessa tekniker ger oss en fördel framför de andra metoderna. "

Tillvägagångssättet extraherar först en persons gånggång från en RGB -video av dem som går, representerar det som en serie av 3D-poser. Senare, forskarna använde ett återkommande neuralt nätverk med korttidsminne (LSTM) och en slumpmässig skogsklassificerare (RF) för att analysera dessa poser och identifiera den mest framträdande känslan som personen känner i videon, välja mellan lycka, sorg, ilska eller neutral.

LSTM är inledningsvis utbildad i en serie djupa funktioner, men dessa kombineras senare med affektiva funktioner som beräknas från gångarterna med hjälp av hållning och rörelsekoder. Alla dessa funktioner klassificeras slutligen med RF -klassificeraren.

Randhavane och hans kollegor genomförde en serie preliminära tester på en datamängd som innehåller videor av människor som gick och fann att deras modell kunde identifiera de upplevda känslorna hos individer med 80 procents noggrannhet. Dessutom, deras tillvägagångssätt ledde till en förbättring med cirka 14 procent jämfört med andra upplevda känslomässiga igenkänningsmetoder som fokuserar på människors gångstil.

"Även om vi inte gör några påståenden om de faktiska känslor en person upplever, vårt tillvägagångssätt kan ge en uppskattning av den upplevda känslan av den vandringsstilen, "Aniket Bera, en forskningsprofessor vid datavetenskapliga avdelningen, övervakar forskningen, berättade TechXplore. "Det finns många applikationer för denna forskning, allt från bättre mänsklig uppfattning för robotar och autonoma fordon till förbättrad övervakning till att skapa mer engagerande upplevelser inom förstärkt och virtuell verklighet. "

Tillsammans med Tanmay Randhavane och Aniket Bera, forskargruppen bakom denna studie inkluderar Dinesh Manocha och Uttaran Bhattacharya vid University of Maryland i College Park, liksom Kurt Gray och Kyra Kapsaskis från psykologiska avdelningen vid University of North Carolina i Chapel Hill.

För att träna deras djupinlärningsmodell, forskarna har också sammanställt en ny dataset som heter Emotion Walk (EWalk), som innehåller videor av individer som går i både inomhus och utomhus inställningar märkta med upplevda känslor. I framtiden, denna datauppsättning kan användas av andra team för att utveckla och träna nya verktyg för att känna igen känslor som är utformade för att analysera rörelse, hållning, och/eller gångart.

"Vår forskning befinner sig i ett mycket primitivt skede, "Sa Bera." Vi vill utforska olika aspekter av kroppsspråket och titta på fler ledtrådar som ansiktsuttryck, Tal, sångmönster, etc., och använd en multimodal metod för att kombinera alla dessa signaler med gångarter. För närvarande, vi antar att gångrörelsen är naturlig och inte innehåller några tillbehör (t.ex. resväska, mobiltelefoner, etc.). Som en del av framtida arbete, vi skulle vilja samla in mer data och utbilda vår djupinlärningsmodell bättre. Vi kommer också att försöka utöka vår metod för att överväga fler aktiviteter som löpning, gester, etc."

Enligt Bera, upplevda verktyg för att känna igen känslor kan snart hjälpa till att utveckla robotar med mer avancerad navigering, planera, och interaktionskunskaper. Dessutom, modeller som deras kan användas för att upptäcka avvikande beteenden eller gångmönster från videor eller övervakningsfilmer, till exempel identifiera personer som riskerar att begå självmord och varna myndigheter eller vårdgivare. Deras modell kan också tillämpas i VFX- och animationsindustrin, där det kan hjälpa designers och animatörer att skapa virtuella karaktärer som effektivt uttrycker särskilda känslor.

© 2019 Science X Network