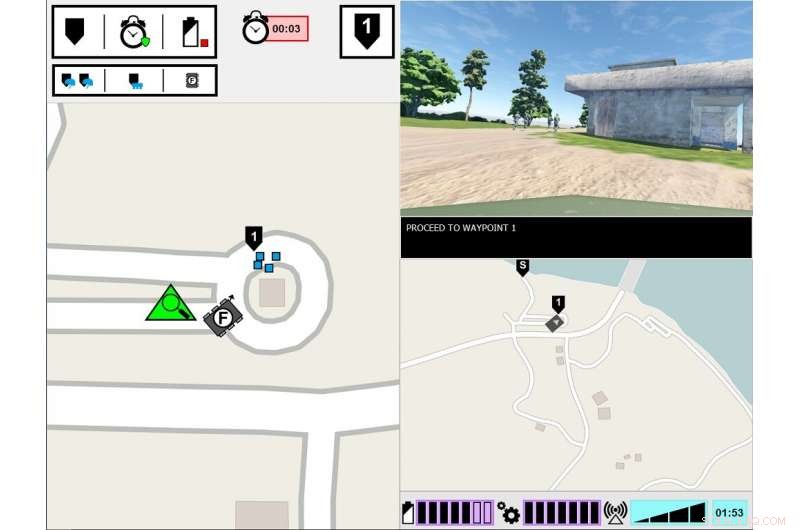

ASM experimentellt gränssnitt. Den vänstra monitorn visar den ledande soldatens synvinkel på uppgiftsmiljön. Den högra monitorn visar ASM:s kommunikationsgränssnitt. Kredit:US Army

Vad krävs för att en människa ska lita på en robot? Det är vad arméns forskare avslöjar i en ny studie om hur människor och robotar samarbetar.

Forskning om teaming mellan människor och agenter, eller HAT, har undersökt hur transparensen hos agenter – som robotar, obemannade fordon eller mjukvaruagenter – påverkar mänskligt förtroende, uppgift prestanda, arbetsbelastning och uppfattningar om agenten. Agenttransparens hänvisar till dess förmåga att förmedla sin avsikt till människor, resonemangsprocessen och framtidsplaner.

Ny arméledd forskning visar att människans förtroende för robotar minskar efter att roboten gör ett misstag, även när det är transparent med sin resonemangsprocess. Pappret, "Agenttransparens och tillförlitlighet i interaktion mellan människa och robot:Inflytandet på användarförtroende och upplevd tillförlitlighet, " har publicerats i augusti numret av IEEE-Transaktioner på människa-maskin-system .

Hittills, forskning har till stor del fokuserat på HAT med perfekt pålitliga intelligenta agenter – vilket innebär att agenterna inte gör misstag – men detta är en av få studier som har utforskat hur agenttransparens interagerar med agentens tillförlitlighet. I denna senaste studie, människor såg en robot som gjorde ett misstag, och forskare fokuserade på om människorna uppfattade roboten som mindre pålitlig, även när människan fick insikt i robotens resonemangsprocess.

"Att förstå hur robotens beteende påverkar deras mänskliga lagkamrater är avgörande för utvecklingen av effektiva människa-robot-team, samt design av gränssnitt och kommunikationsmetoder mellan teammedlemmar, " sa Dr Julia Wright, huvudutredare för detta projekt och forskare vid U.S. Army Combat Capabilities Development Command's Army Research Laboratory, även känd som ARL. "Denna forskning bidrar till arméns flerdomänoperationsansträngningar för att säkerställa övermatchning av artificiell intelligens-aktiverade kapacitet. Men den är också tvärvetenskaplig, eftersom dess resultat kommer att informera psykologernas arbete, robotiker, ingenjörer, och systemdesigners som arbetar för att underlätta bättre förståelse mellan människor och autonoma agenter i strävan att skapa autonoma lagkamrater snarare än bara verktyg.

Denna forskning var en gemensam ansträngning mellan ARL och University of Central Florida Institute for Simulations and Training, och är den tredje och sista studien i projektet Autonomous Squad Member (ASM), sponsrad av försvarsministerns kontor för pilotprojekt för autonomiforskning. ASM är en liten markrobot som interagerar med och kommunicerar med en infanterigrupp.

Tidigare ASM-studier undersökte hur en robot skulle kommunicera med en mänsklig lagkamrat. Genom att använda den situationsmedvetandebaserade agenttransparensmodellen som vägledning, olika visualiseringsmetoder för att förmedla agentens mål, avsikter, resonemang, begränsningar, och projicerade resultat undersöktes och testades. En översiktlig ikonografisk modul utvecklades baserat på dessa tidiga studieresultat, och användes sedan i efterföljande studier för att utforska effektiviteten av agenttransparens i HAT.

Forskare genomförde denna studie i en simulerad miljö, där deltagarna observerade ett soldatteam med mänsklig agent, som inkluderade ASM, genomgå en utbildning. Deltagarnas uppgift var att övervaka teamet och utvärdera roboten. Soldat-robotteamet stötte på olika händelser längs banan och reagerade därefter. Medan soldaterna alltid svarade korrekt på händelsen, ibland missförstod roboten situationen, leder till felaktiga handlingar. Mängden information som roboten delade varierade mellan försöken. Medan roboten alltid förklarade sina handlingar, skälen bakom dess handlingar och det förväntade resultatet av dess handlingar, i vissa försök delade roboten också resonemanget bakom sina beslut, dess underliggande logik. Deltagarna såg flera soldat-robotteam, och deras bedömningar av robotarna jämfördes.

Studien fann att oavsett robotens transparens när det gäller att förklara dess resonemang, robotens tillförlitlighet var den yttersta avgörande faktorn för att påverka deltagarnas prognoser av robotens framtida tillförlitlighet, tillit till roboten och uppfattningar om roboten. Det är, efter att deltagarna bevittnat ett fel, de fortsatte att betygsätta robotens tillförlitlighet lägre, även när roboten inte gjorde några efterföljande fel. Även om dessa utvärderingar långsamt förbättrades med tiden så länge roboten inte begick några ytterligare fel, deltagarnas förtroende för sina egna bedömningar av robotens tillförlitlighet förblev sänkt under resten av försöken, jämfört med deltagare som aldrig såg ett fel. Vidare, deltagare som bevittnade ett robotfel rapporterade lägre förtroende för roboten, jämfört med de som aldrig sett ett robotfel.

Ökad agenttransparens visade sig förbättra deltagarnas förtroende för roboten, men bara när roboten samlade in eller filtrerade information. Detta kan tyda på att delning av djupgående information kan mildra några av effekterna av opålitlig automatisering för specifika uppgifter, sa Wright. Dessutom, deltagarna bedömde den opålitliga roboten som mindre livlig, sympatisk, intelligent, och säker än den pålitliga roboten.

"Tidigare studier tyder på att sammanhanget har betydelse för att avgöra användbarheten av information om öppenhet, " sa Wright. "Vi måste bättre förstå vilka uppgifter som kräver mer djupgående förståelse för agentens resonemang, och hur man kan urskilja vad det djupet skulle innebära. Framtida forskning bör undersöka sätt att leverera transparensinformation baserat på uppdragskraven."