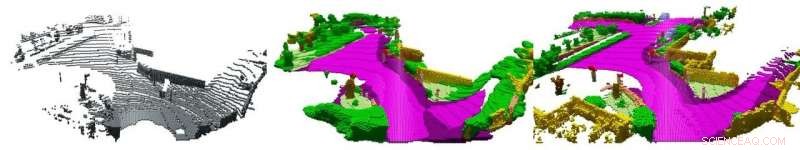

Enkel LiDAR-skanning (vänster), de överlagrade data (höger) med beskrivningar (färger) tillhandahållna av en mänsklig observatör och resultatet av programvaran (mitten). Kredit:AG Computer Vision der Universität Bonn

Bra förare förutser farliga situationer och anpassar sin körning innan det blir knepigt. Forskare vid universitetet i Bonn vill nu också lära ut denna färdighet till självkörande bilar. De kommer att presentera en motsvarande algoritm vid den internationella konferensen om datorseende som hålls på fredag, 1 november, i Seoul. De kommer också att presentera en datamängd som de använde för att träna och testa sitt tillvägagångssätt. Det kommer att göra det mycket lättare att utveckla och förbättra sådana processer i framtiden.

En tom gata, en rad parkerade bilar vid sidan av:inget som tyder på att du ska vara försiktig. Men vänta:finns det inte en sidogata längre fram, halvt täckt av de parkerade bilarna? Jag kanske borde ta bort foten från gasen – vem vet om någon kommer från sidan. Vi stöter ständigt på situationer som dessa när vi kör. Att tolka dem rätt och dra rätt slutsatser kräver mycket erfarenhet. I kontrast, självkörande bilar beter sig ibland som en elevförare på sin första lektion. "Vårt mål är att lära dem en mer förväntansfull körstil, " förklarar datavetaren prof. Dr. Jürgen Gall. "Detta skulle göra det möjligt för dem att reagera mycket snabbare på farliga situationer."

Gall är ordförande för arbetsgruppen "Computer Vision" vid universitetet i Bonn, som, i samarbete med sina universitetskollegor från Institutet för fotogrammetri och arbetsgruppen "Autonomous Intelligent Systems", undersöker en lösning på detta problem. Forskarna presenterar nu ett första steg på vägen mot detta mål vid det ledande symposiet för Galls disciplin, den internationella konferensen om datorseende i Seoul. "Vi har förfinat en algoritm som kompletterar och tolkar så kallade LiDAR-data, " förklarar han. "Detta gör att bilen kan förutse potentiella faror i ett tidigt skede."

Problem:för lite data

LiDAR är en roterande laser som är monterad på taket på de flesta självkörande bilar. Laserstrålen reflekteras av omgivningen. LiDAR-systemet mäter när det reflekterade ljuset faller på sensorn och använder denna tid för att beräkna avståndet. "Systemet känner av avståndet till cirka 120, 000 punkter runt fordonet per varv, säger Gall.

Problemet med detta:Mätpunkterna blir "utspädda" när avståndet ökar - gapet mellan dem vidgas. Det här är som att måla ett ansikte på en ballong:När du blåser upp den, ögonen rör sig längre och längre isär. Även för en människa är det därför nästan omöjligt att få en korrekt förståelse av omgivningen från en enda LiDAR-skanning (dvs. avståndsmätningarna för ett enda varv). "Några år sedan, universitetet i Karlsruhe (KIT) registrerade stora mängder LiDAR-data, totalt 43, 000 skanningar, " förklarar Dr Jens Behley från Institute of Photogrammetry. "Vi har nu tagit sekvenser från flera dussin skanningar och överlagrat dem." Data som erhållits på detta sätt innehåller också punkter som sensorn bara hade registrerat när bilen redan hade kört några få dussin meter längre ner på vägen. Enkelt uttryckt, de visar inte bara nuet, men också framtiden.

"Dessa överlagrade punktmoln innehåller viktig information som scenens geometri och de rumsliga dimensionerna av objekten den innehåller, som inte är tillgängliga i en enda skanning, " betonar Martin Garbade, som för närvarande doktorerar vid Institutet för datavetenskap. "Dessutom, vi har märkt varenda punkt i dem, till exempel:Det finns en trottoar, det är en fotgängare och tillbaka är det en motorcyklist." Forskarna matade sin programvara med ett datapar:en enda LiDAR-skanning som indata och tillhörande överlagringsdata inklusive semantisk information som önskad utdata. De upprepade denna process för flera tusen sådana par.

"Under denna utbildningsfas, Algoritmen lärde sig att slutföra och tolka individuella skanningar, " förklarar Prof. Gall. "Detta innebar att det troligtvis kunde lägga till saknade mätningar och tolka vad som sågs i skanningarna." Scenkompletteringen fungerar redan relativt bra:Processen kan slutföra ungefär hälften av den saknade data korrekt. Den semantiska tolkningen, d.v.s. härleda vilka föremål som är gömda bakom mätpunkterna, fungerar inte lika bra:Här, datorn uppnår en maximal noggrannhet på 18 procent.

Dock, forskarna anser att denna forskningsgren fortfarande är i sin linda. "Tills nu, det har helt enkelt saknats omfattande datamängder för att träna motsvarande artificiell intelligensmetoder, " betonar Gall. "Vi stänger ett gap här med vårt arbete. Jag är optimistisk att vi kommer att avsevärt kunna öka noggrannheten i semantisk tolkning under de kommande åren." Han anser att 50 procent är ganska realistiskt, vilket kan ha en enorm inverkan på kvaliteten på autonom körning.