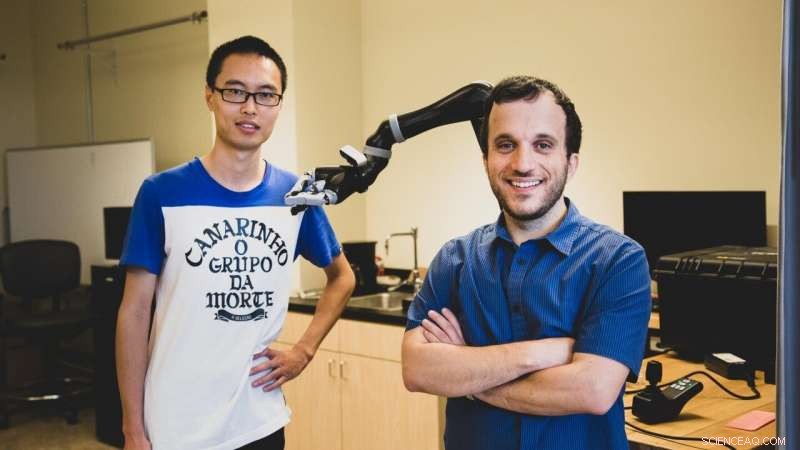

USC doktorand Jiali Duan (till vänster) och Stefanos Nikolaidis, en biträdande professor i datavetenskap, använda förstärkningslärande, en teknik där artificiell intelligens-program "lär sig" av upprepade experiment. Kredit:Haotian Mai.

Enligt en ny studie från USC datavetare, för att hjälpa en robot att lyckas, du kanske behöver visa det lite hård kärlek.

I en datorsimulerad manipulationsuppgift, forskarna fann att träning av en robot med en mänsklig motståndare avsevärt förbättrade greppet om föremål.

"Detta är den första robotinlärningsinsatsen som använder motståndskraftiga mänskliga användare, " sa studiens medförfattare Stefanos Nikolaidis, en biträdande professor i datavetenskap.

"Föreställ dig det som att spela en sport:om du spelar tennis med någon som alltid låter dig vinna, du kommer inte bli bättre. Samma sak med robotar. Om vi vill att de ska lära sig en manipulationsuppgift, som att greppa, så att de kan hjälpa människor, vi måste utmana dem. "

Studien, "Robotinlärning via mänskliga motspel, " presenterades den 4 november vid den internationella konferensen om intelligenta robotar och system. USC doktorander Jiali Duan och Qian Wang är huvudförfattare, råd av professor C. C. Jay Kuo, med ytterligare medförfattare Lerrel Pinto från Carnegie Mellon University.

Att lära av praktiken

Nikolaidis, som gick med i USC Viterbi School of Engineering 2018, och hans team använder förstärkningslärande, en teknik där program för artificiell intelligens "lär sig" av upprepade experiment.

Istället för att vara begränsad till att utföra ett litet antal repetitiva uppgifter, såsom industrirobotar, robotsystemet "lär sig" baserat på tidigare exempel, i teorin ökar utbudet av uppgifter som den kan utföra.

Men att skapa generella robotar är notoriskt utmanande, delvis på grund av mängden utbildning som krävs. Robotsystem behöver se ett stort antal exempel för att lära sig hur man manipulerar ett objekt på ett mänskligt sätt.

Till exempel, OpenAI:s imponerande robotsystem lärde sig att lösa en Rubiks kub med en humanoid hand, men krävde motsvarande 10, 000 år med simulerad utbildning för att lära sig att manipulera kuben.

Mer viktigt, robotens skicklighet är mycket specifik. Utan omfattande utbildning, det kan inte plocka upp ett föremål, manipulera det med ett annat grepp, eller ta tag i och hantera ett annat föremål.

"Som människa, även om jag känner till objektets plats, Jag vet inte exakt hur mycket den väger eller hur den kommer att röra sig eller bete sig när jag tar upp den, ändå gör vi detta framgångsrikt nästan hela tiden, sa Nikolaidis.

"Det beror på att människor är väldigt intuitiva om hur världen beter sig, men roboten är som ett nyfött barn. "

Med andra ord, Robotsystem har svårt att generalisera, en färdighet som människor tar för givet. Det här kan verka trivialt, men det kan få allvarliga konsekvenser. Om robothjälpmedel, som att gripa robotar, ska uppfylla sitt löfte om att hjälpa människor med funktionsnedsättning, Robotsystem måste kunna fungera pålitligt i verkliga miljöer.

Människan i slingan

En forskningslinje som har varit ganska framgångsrik för att övervinna detta problem är att ha en "människa i slingan." Med andra ord, människan ger feedback till robotsystemet genom att visa förmågan att slutföra uppgiften.

Men, tills nu, Dessa algoritmer har gjort ett starkt antagande om att en samarbetande mänsklig handledare hjälper roboten.

"Jag har alltid arbetat med människa-robotsamarbete, men i verkligheten, människor kommer inte alltid att vara kollaboratörer med robotar i det vilda, sa Nikolaidis.

Som ett exempel, han pekar på en studie av japanska forskare, som släppte loss en robot i ett offentligt shoppingkomplex och såg barn "agera våldsamt" mot den vid flera tillfällen.

Så, tänkte Nikolaidis, tänk om vi utnyttjade vår mänskliga böjelse för att göra det svårare för roboten istället? Istället för att visa hur man bättre fattar ett föremål, tänk om vi försökte dra bort det? Genom att lägga till utmaning, tanken går, systemet skulle lära sig att vara mer robust mot verklighetens komplexitet.

Element av utmaning

Experimentet gick ungefär så här:i en datasimulering, roboten försöker greppa ett föremål. Människan, vid datorn, observerar den simulerade robotens grepp. Om greppet lyckas, människan försöker rycka objektet ur robotens grepp, med tangentbordet för att signalera riktning.

Att lägga till detta element av utmaning hjälper roboten att lära sig skillnaden mellan ett svagt grepp (säg, håller en flaska överst), kontra ett fast grepp (håller det i mitten), vilket gör det mycket svårare för den mänskliga motståndaren att rycka undan.

Det var en lite galen idé, erkänner Nikolaidis, men det fungerade.

Forskarna fann att systemet tränat med den mänskliga motståndaren avvisade instabila grepp, och lärde sig snabbt robusta grepp för dessa föremål. I ett experiment, modellen uppnådde en framgångsgrad på 52 procent med en mänsklig motståndare mot en 26,5 procent som lyckades med en mänsklig samarbetspartner.

"Roboten lärde sig inte bara hur man greppade objekt mer robust, men också att lyckas oftare med nya objekt i en annan inriktning, eftersom den har lärt sig ett mer stabilt grepp, sa Nikolaidis.

De fann också att modellen som utbildats med en mänsklig motståndare presterade bättre än en simulerad motståndare, som hade 28 procent greppande framgång. Så, robotsystem lär sig bäst av motståndare av kött och blod.

"Det beror på att människor kan förstå stabilitet och robusthet bättre än lärda motståndare, "förklarade Nikolaidis.

"Roboten försöker plocka upp saker och om människan försöker störa, det leder till stabilare grepp. Och eftersom den har lärt sig ett mer stabilt grepp, det kommer att lyckas oftare, även om objektet är i en annan position. Med andra ord, det har lärt sig att generalisera. Det är en stor grej. "

Att hitta en balans

Nikolaidis hoppas kunna få systemet att fungera på en riktig robotarm inom ett år. Detta kommer att innebära en ny utmaning - i den verkliga världen, minsta lilla friktion eller oljud i en robots leder kan kasta av sig saker. Men Nikolaidis är hoppfull om framtiden för kontradiktoriskt lärande för robotik.

"Jag tror att vi precis har skrapat på ytan av potentiella tillämpningar av lärande via motstridiga mänskliga spel, sa Nikolaidis.

"Vi är glada över att utforska mänskligt-i-slingan motståndskraftigt lärande även i andra uppgifter, som att undvika hinder för robotarmar och mobila robotar, som självkörande bilar. "

Detta väcker frågan:hur långt är vi villiga att ta kontradiktoriskt lärande? Skulle vi vara villiga att sparka och slå robotar till underkastelse? Svaret, sa Nikolaidis, ligger i att hitta en balans mellan hård kärlek och uppmuntran med våra robottekniker.

"Jag känner att tuff kärlek - inom ramen för den algoritm som vi föreslår - återigen är som en sport:den faller inom specifika regler och begränsningar, sa Nikolaidis.

"Om människan bara bryter robotens gripare, roboten kommer ständigt att misslyckas och aldrig lära sig. Med andra ord, roboten måste utmanas men ändå få lov att lyckas för att lära sig. "