CMU-forskare har utvecklat en metod för att automatiskt identifiera memes och använda förskrivna mallar för att lägga till beskrivande alt-text, gör dem begripliga via hjälpmedel som skärmläsare. Kredit:Carnegie Mellon University

Personer med synnedsättning använder sociala medier som alla andra, ofta med hjälp av skärmläsarprogram. Men den tekniken kommer till korta när den stöter på memes, som inte innehåller alternativ text, eller alternativ text, för att beskriva vad som avbildas på bilden.

För att motverka detta, forskare vid Carnegie Mellon University har utvecklat en metod för att automatiskt identifiera memes och använda förskrivna mallar för att lägga till beskrivande alt-text, göra dem begripliga via befintliga hjälpmedelstekniker.

Memes är bilder som kopieras och sedan överlagras med små variationer av text. De är ofta humoristiska och förmedlar en gemensam upplevelse, men "om du är blind, du missar den delen av konversationen, sa Cole Gleason, en Ph.D. student vid CMU:s Human-Computer Interaction Institute (HCII.)

"Memes kanske inte verkar vara det viktigaste problemet, men en viktig del av tillgängligheten är inte att välja för människor det som förtjänar deras uppmärksamhet, sa Jeff Bigham, docent i HCII. "Många människor använder memes, och därför bör de göras tillgängliga."

Memes lever till stor del inom sociala medieplattformar som har hinder för att lägga till alt-text. Twitter, till exempel, låter människor lägga till alternativ text till sina bilder, men den funktionen är inte alltid lätt att hitta. Av 9 miljoner tweets som CMU-forskarna undersökte, en miljon inkluderade bilder och, av dem, bara 0,1 procent inkluderade alt-text.

Gleason sa att grundläggande datorseendetekniker gör det möjligt att beskriva bilderna som ligger bakom varje meme, oavsett om det är en kändis, en gråtande bebis, en seriefigur eller en scen som en buss som välte upp i ett slukhål. Tekniker för optisk teckenigenkänning används för att dechiffrera den överlagrade texten, som kan ändras med varje iteration av meme. För varje memetyp, det är bara nödvändigt att göra en mall som beskriver bilden, och den överlagrade texten kan läggas till för varje iteration av det meme.

Men att skriva ut vad memen är tänkt att förmedla visade sig vara svårt.

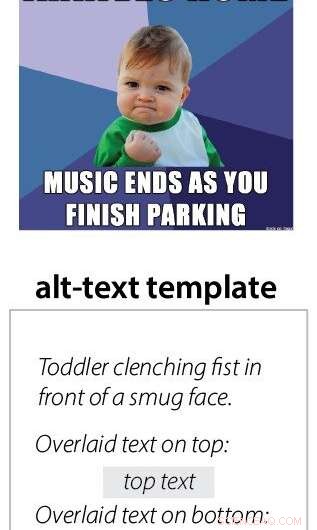

"Det berodde på meme om humorn översattes. Vissa av bilderna är mer nyanserade, " Gleason sa. "Och ibland är det explicit och du kan bara beskriva det." Till exempel, den kompletta alt-texten för det så kallade "success kid"-memet säger "Småbarn knyter näven framför självbelåtet ansikte. Överlagd text på toppen:Var en bad boy hela året. Överlagd text på botten:Fick fortfarande fantastiska presenter från tomten."

Teamet skapade också en plattform för att översätta memes till ljud snarare än text. Användare söker igenom ett ljudbibliotek och drar och släpper element i en mall. Detta system gjordes för att översätta befintliga memes och förmedla känslan genom musik och ljudeffekter.

"En av anledningarna till att vi provade ljudmemes var för att vi trodde att alt-text skulle döda skämtet, men folk föredrog ändå texten eftersom de är så vana vid det, " sa Gleason.

Att implementera tekniken kommer att bli en utmaning. Även om det var integrerat i en meme-generatorwebbplats, att alt-text inte skulle kopieras automatiskt när bilden delades på sociala medier.

"Vi måste övertyga Twitter att lägga till en ny funktion, " sa Gleason. Det kan vara något som lagts till i en personlig smartphone, men han noterade att det skulle lägga bördan på användaren. CMU-forskare arbetar för närvarande med relaterade projekt, inklusive ett webbläsartillägg för Twitter som försöker lägga till alt-text för varje bild och kan inkludera ett meme-system. Ett annat projekt strävar efter att integrera alt-text i metadata för bilder som skulle stanna med bilden var den än postades.

Detta arbete presenterades tidigare i år på ACCESS-konferensen i Pittsburgh. Andra forskare som är involverade i projektet inkluderar HCII postdoktor Amy Pavel, CMU grundexamen Xingyu Liu, HCII biträdande professor Patrick Carrington, och Lydia Chilton från Columbia University.