Enligt Världshälsoorganisationen är jordskred mer utbredda än någon annan geologisk händelse. Kredit:NASA

University of British Columbia doktorander har tränat datorer att "läsa" nyhetsartiklar om jordskred på Reddit för att stärka en NASA-databas, vilket kan förbättra förutsägelser om när och var dessa naturkatastrofer kommer att inträffa.

För deras Master of Data Science in Computational Linguistics capstone-projekt, tränade Badr Jaidi och hans team, Social Landslides-gruppen, datorer för att automatiskt extrahera användbar information från relevanta nyhetsartiklar om jordskred som lades upp på Reddit. I denna Q&A diskuterar han hur det här verktyget skulle kunna rädda liv.

Varför behöver vi det här verktyget?

Enligt Världshälsoorganisationen är jordskred mer utbredda än någon annan geologisk händelse. De är så destruktiva och vi har inte så mycket data om dem. Ju mer exakta jordskreddata du har, desto mer är det möjligt att exakt förutsäga vilka platser som har högre risk, vilket i slutändan kan rädda liv.

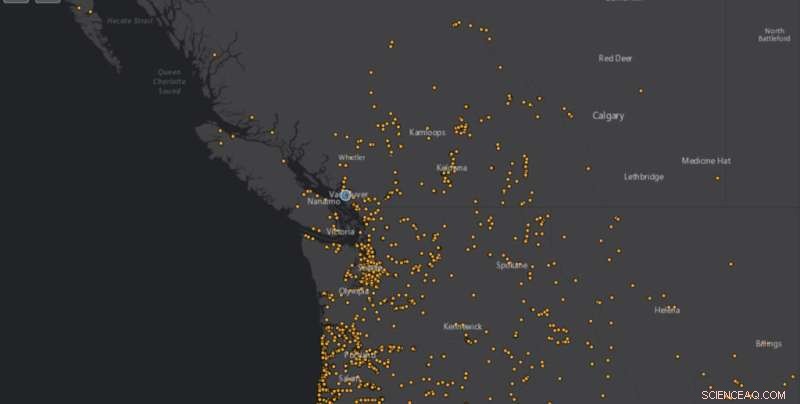

NASA samlar in sådan information i en offentlig databas som kallas Cooperative Open Online Repository, eller COOLR, och använder denna för att förutsäga när och var jordskred kommer att inträffa. Men folk har varit tvungna att manuellt skicka in jordskredinformation eller söka efter nyhetsartiklar och data en efter en, vilket är ganska tråkigt. Vårt verktyg automatiserar den processen och slutför på några minuter vad som tidigare kan ha tagit månader.

Det skulle frigöra resurser för viktigare forskning, och skulle också innebära att vi får mer data, snabbare, potentiellt förbättra forskningen om jordskred i allmänhet, såväl som NASA:s jordskredprognoser.

Hur fungerar det?

Med vägledning av BGC Engineering Inc. och NASA för vårt slutstensprojekt designade vårt team ett verktyg som söker igenom Reddit efter nyhetsartiklar om jordskred inom en given tidsperiod och sedan extraherar relevant information.

Först utreder en datormodell om artikeln verkligen handlar om jordskred, snarare än att säga, ett val där någon vinner "med ett jordskred", eller som vi också fann, artiklar om Pokémon med jordtekniker som "bergskred."

Sedan tränade vi en naturlig språkbearbetningsmodell på jordskreddata, och lärde den att känna igen informationen vi ville ha från en artikel. Denna typ av modell kan förstå språk, inklusive att analysera meningar. Så vi skulle ge det en nyhetsartikel och fråga var ett jordskred kan ha hänt. Modellen skulle förutsäga svaret baserat på språket inblandat, till exempel "Skredet hände troligen här, enligt den här meningen", och vi skulle meddela om det var korrekt eller inte.

På så sätt lär sig datorn vilken information som ska extraheras automatiskt och korrekt, inklusive när ett jordskred inträffade och var, vad som orsakade det och hur många dödsfall som var inblandade.

Allt detta händer ganska snabbt:Det returnerar en månads artiklar på cirka 15 minuter, jämfört med att gå igenom dem manuellt för att hitta dessa informationsbitar. Data kan sedan matas in i COOLR. Det tog oss ungefär två månader att bygga. NASA utvärderar för närvarande om verktyget kan köras som det är eller behöver några justeringar för att använda.

Kan verktyget användas på andra sociala medier?

Vi använde Reddit eftersom det är gratis att komma åt deras applikationsprogrammeringsgränssnitt (API). Till exempel har Twitters API många begränsningar, och det är ganska dyrt att komma åt. Dessutom skulle mängden data vara enorm.

Vi ville börja i det små och bevisa att det fungerar med Reddit. Men det skulle kunna utökas till större plattformar och källor, förutsatt att de har nyhetsartiklar. Du kan till och med utöka verktyget för att använda det för andra katastrofer som jordbävningar, med samma metodik genom att träna modellerna med liknande datauppsättningar.

Att förbättra modellen och lägga till fler källor som andra jordskred kan extraheras från än Reddit skulle i slutändan hjälpa NASA att ha fler datapunkter, snabbare. Jag ska hålla koll på det. + Utforska vidare