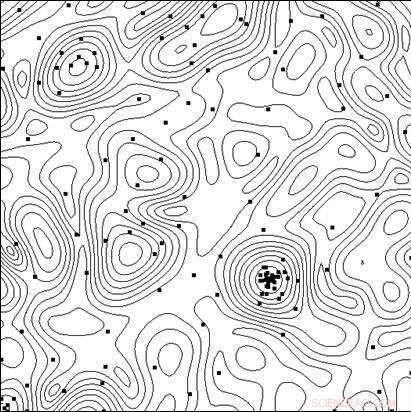

Linjer för den objektiva funktionsnivån och punkterna för testerna som utförs av algoritmen i processen att hitta minimum. Upphovsman:Lobachevsky University

Att skapa mycket effektiva tekniska system och tekniska processer, förutom användningen av nya principer, nya material, nya fysiska effekter och andra lösningar som bestämmer den övergripande strukturen för objektet som skapas, forskare måste välja den bästa kombinationen av objektets parametrar (geometriska dimensioner, Elektriska egenskaper, etc.), eftersom alla ändringar i parametrarna med en fast övergripande objektstruktur kan påverka effektivitetsindikatorerna avsevärt.

I datorstödd design, testning av alternativ kan utföras genom att analysera dess matematiska modell för olika parametervärden. I takt med att modellerna blir allt mer komplexa, behovet uppstår av ett riktat val av alternativ i sökandet efter den optimala (mest effektiva) lösningen.

Ett team av forskare från Lobachevsky State University of Nizhny Novgorod (UNN) ledd av professor Roman Strongin har studerat de riktade valen när de letar efter den optimala lösningen. Det innebär en analys av en delmängd av de möjliga alternativen i syfte att utesluta uppenbart föga lovande fall och koncentrera sökningen på den delmängd som innehåller det bästa alternativet.

"När matematiska modeller av de processer som sker i ett objekt blir mer komplicerade, effektivitetsegenskaperna kommer inte att ha egenskapen monotonitet, det är därför lokala sökmetoder är otillräckliga för att utvärdera det bästa alternativet, säger professor Roman Strongin.

De globala sökprocedurerna som används i sådana problem (även kallade multiextrema optimeringsproblem) säkerställer att sökningen är målinriktad genom att ta hänsyn till den begränsade karaktären av förändringen i objektets egenskaper när förändringarna i dess parametrar är begränsade. Den resulterande matematiska formuleringen kan ta formen av Lipschitz-tillståndet, det enhetliga Hölderskicket, etc.

Multi-extrema optimeringsproblem erbjuder en smal omfattning av analytiska forskningsmöjligheter, och de blir beräkningsmässigt dyra när man söker numeriska lösningar, eftersom beräkningskostnaderna växer exponentiellt med problemets ökande dimension.

Enligt Konstantin Barkalov, Docent vid UNN-avdelningen för programvara och superdatorteknik, Användningen av moderna parallella datorsystem utökar omfattningen av globala optimeringsmetoder. Dock, på samma gång, det innebär utmaningen att effektivt parallellisera sökprocessen.

"Det är därför som huvudinsatserna på detta område bör koncentreras på att utveckla effektiva parallella metoder för att numeriskt lösa multiextrema optimeringsproblem och skapa lämplig programvara för moderna datorsystem på basis av sådana metoder, säger Barkalov.

Vanligtvis, metoderna för global optimering (både sekventiell och parallell) är avsedda att lösa ett enda optimeringsproblem. För att lösa en serie q -problem, problemen i serien löses sekventiellt, en efter en. Därför, den optimala uppskattningen i det i:te problemet i serien förblir odefinierat tills alla föregående problem i serien (med indexen 1, 2, . . . , jag? 1) har lösts helt. Vid begränsade beräkningsresurser, optima -uppskattningarna i problemen i + 1, . . . , q kommer inte att erhållas om beräkningsresurserna är uttömda medan det i:te problemet löses.

Situationer när en serie q-problem måste lösas är inte extraordinära. Till exempel, en serie skalära problem uppstår när man söker en Pareto-uppsättning för att lösa multi-objektiva optimeringsproblem. I detta fall, lösningen av ett enskilt skalärt problem motsvarar en av Pareto-optimalpunkterna i ett multiobjektivt problem. En rad optimeringsproblem uppstår också när man använder måttreduceringsmetoder för att lösa flerdimensionella optimeringsproblem. Till sist, en serie testproblem kan också erhållas med hjälp av en speciell testproblemgenerator.

Forskare tror att när man löser en uppsättning problem, det är nödvändigt att ha initiala uppskattningar av lösningar för alla problem samtidigt, så att det när som helst är möjligt att utvärdera lämpligheten av att fortsätta sökningen. I detta fall, det är önskvärt att ha de optimala uppskattningarna för alla problem med samma noggrannhet.

Köra många oberoende processer i ett parallellt datorsystem, var och en av processerna som löser ett problem från en serie, har ett antal nackdelar. Först, en obalans i arbetsbelastningen mellan processorerna kommer att uppstå. Om lösning av det i:e problemet kräver betydligt färre iterationer av metoden än att lösa det j:e problemet, processorn med uppgift att hantera det i-te problemet skulle förbli inaktiv efter att ha slutfört uppgiften. Andra, uppskattningarna av optima kommer att erhållas med olika precision i olika problem. Enklare problem kommer att lösas med högre precision, medan precisionen blir lägre för mer komplexa problem.

Syftet med forskningen vid Lobachevsky -universitetet var att utveckla en ny metod för att lösa en rad globala optimeringsproblem som skulle säkerställa:(i) en enhetlig laddning av alla kärnor/processorer som används; (ii) en enhetlig konvergens till lösningarna av alla problem i serien.

I den teoretiska delen av deras uppsats, UNN-forskare bevisade också teoremet om enhetlig konvergens av den nya algoritmen. Den experimentella delen av arbetet bestod i att lösa en serie på flera hundra testproblem av olika dimensioner, och resultaten har övertygande visat närvaron av enhetlig konvergens.

Även UNN -forskare anser beräkningsintensiva globala optimeringsproblem, för att lösa vilka superdatorsystem med exaflops-prestanda kan krävas. För att övervinna sådan beräkningskomplexitet, forskarna föreslår generaliserade parallella beräkningsscheman, som kan involvera många effektiva parallella algoritmer för global optimering. De föreslagna scheman inkluderar metoder för flernivånedbrytning av parallella beräkningar för att garantera beräkningseffektiviteten hos superdatorer med delade och distribuerade minnesmultiprocessorer som använder tusentals processorer för att möta globala optimeringsutmaningar.