Klar spelare ett? Kredit:Wikimedia

Spel har länge använts som testbäddar och riktmärken för artificiell intelligens, och det har inte funnits brist på prestationer de senaste månaderna. Google DeepMinds AlphaGo och pokerboten Libratus från Carnegie Mellon University har båda slagit mänskliga experter i spel som traditionellt har varit svåra för AI – cirka 20 år efter att IBM:s DeepBlue uppnådde samma bedrift i schack.

Spel som dessa har attraktionen av tydligt definierade regler; de är relativt enkla och billiga för AI-forskare att arbeta med, och de ger en mängd olika kognitiva utmaningar på vilken svårighetsgrad som helst. Genom att uppfinna algoritmer som spelar dem bra, forskare hoppas få insikter i de mekanismer som behövs för att fungera autonomt.

Med ankomsten av de senaste teknikerna inom AI och maskininlärning, uppmärksamheten flyttas nu till visuellt detaljerade datorspel-inklusive 3D-skjutaren Doom, olika 2-D Atari-spel som Pong och Space Invaders, och strategispelet StarCraft i realtid.

Det här är verkligen framsteg, men en viktig del av den större AI -bilden förbises. Forskning har prioriterat spel där alla åtgärder som kan utföras är kända i förväg, vare sig det rör sig om en riddare eller skjuter ett vapen. Datorn får alla möjligheter redan från början och fokus ligger på hur väl den väljer mellan dem. Problemet är att detta kopplar bort AI-forskning från uppgiften att göra datorer genuint autonoma.

Bananskal

Att få datorer att avgöra vilka handlingar som ens existerar i ett givet sammanhang innebär konceptuella och praktiska utmaningar som spelforskare knappt har försökt lösa hittills. Problemet med "apa och bananer" är ett exempel på en långvarig AI-gåta där inga framsteg nyligen har gjorts.

Problemet ställdes ursprungligen av John McCarthy, en av grundarna till AI, 1963:det finns ett rum med en stol, en pinne, en apa och ett gäng bananer hängande på en takkrok. Uppgiften är att en dator kommer med en följd av åtgärder för att göra det möjligt för apan att skaffa bananer.

McCarthy gjorde en viktig skillnad mellan två aspekter av denna uppgift när det gäller artificiell intelligens. Fysisk genomförbarhet – avgöra om en viss sekvens av åtgärder är fysiskt realiserbar; och epistemisk eller kunskapsrelaterad genomförbarhet – att avgöra vilka möjliga handlingar för apan som faktiskt existerar.

Att bestämma vad som är fysiskt genomförbart för apan är mycket enkelt för en dator om den får veta alla möjliga åtgärder i förväg - "klättra på stolen", "vågpinne" och så vidare. Ett enkelt program som instruerar datorn att gå igenom alla möjliga sekvenser av åtgärder en efter en kommer snabbt fram till den bästa lösningen.

Om datorn först måste avgöra vilka åtgärder som ens är möjliga, dock, det är en mycket tuffare utmaning. Det väcker frågor om hur vi representerar kunskap, de nödvändiga och tillräckliga förutsättningarna för att veta något, och hur vi vet när tillräckligt med kunskap har förvärvats. Genom att belysa dessa problem, McCarthy sa:"Vårt yttersta mål är att göra program som lär sig av sina erfarenheter lika effektivt som människor gör."

Tills datorer kan hantera problem utan någon förutbestämd beskrivning av möjliga åtgärder, detta mål kan inte uppnås. Det är olyckligt att AI-forskare försummar detta:inte bara är dessa problem svårare och mer intressanta, de ser ut som en förutsättning för att göra ytterligare meningsfulla framsteg på området.

Textöverklagan

Att arbeta självständigt i en komplex miljö, det är omöjligt att på förhand beskriva hur man bäst manipulerar – eller ens karaktäriserar – föremålen där. Att lära datorer att komma runt dessa svårigheter leder omedelbart till djupa frågor om att lära sig av tidigare erfarenheter.

Istället för att fokusera på spel som Doom eller StarCraft, där det är möjligt att undvika detta problem, ett mer lovande test för modern AI kan vara det ödmjuka textäventyret från 1970- och 1980-talen.

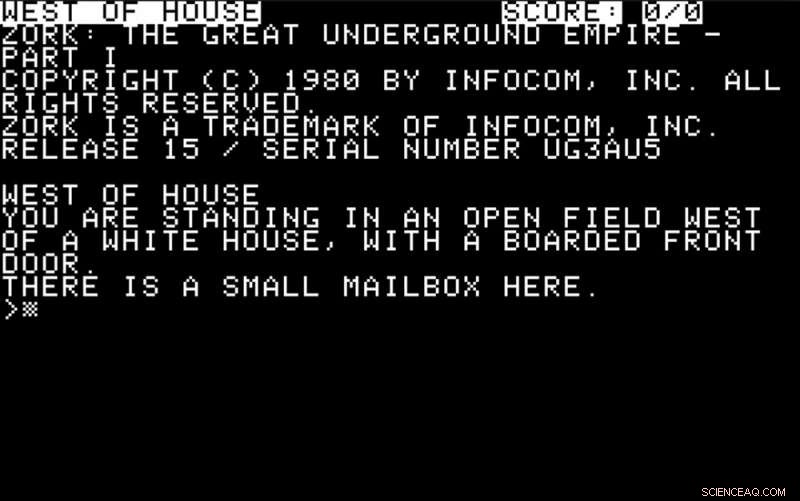

Under dagarna innan datorer hade sofistikerade grafikfunktioner, spel som Colossal Cave och Zork var populära. Spelarna fick veta om sin miljö genom meddelanden på skärmen:

De var tvungna att svara med enkla instruktioner, vanligtvis i form av ett verb eller ett verb plus ett substantiv – "titta", "ta box" och så vidare. En del av utmaningen var att ta reda på vilka åtgärder som var möjliga och användbara och att svara därefter.

En bra utmaning för modern AI skulle vara att ta rollen som en spelare i ett sådant äventyr. Datorn måste förstå textbeskrivningarna på skärmen och svara på dem med åtgärder, använda någon prediktiv mekanism för att bestämma deras sannolika effekt.

Mer sofistikerade beteenden på en del av datorn skulle innebära att utforska miljön, definiera mål, göra målorienterade handlingsval och lösa de olika intellektuella utmaningar som vanligtvis krävs för att komma vidare.

Hur väl moderna AI-metoder av det slag som främjas av teknikjättar som IBM, Google, Facebook eller Microsoft skulle klara sig i dessa textäventyr är en öppen fråga – liksom hur mycket specialistkunskap de skulle kräva för varje nytt scenario.

För att mäta framsteg inom detta område, under de senaste två åren har vi kört en tävling på IEEE Conference on Computational Intelligence and Games, som i år äger rum i Maastricht i Nederländerna i augusti. Tävlande skickar in bidrag i förväg, och kan använda den AI-teknik de väljer för att bygga program som kan spela dessa spel genom att göra en textbeskrivning och mata ut lämpliga textkommandon i gengäld.

Kortfattat, forskare måste ompröva sina prioriteringar om AI ska fortsätta utvecklas. Om det visar sig vara fruktbart att gräva fram disciplinens försummade rötter, the monkey may finally gets his bananas after all.

Denna artikel publicerades ursprungligen på The Conversation. Läs originalartikeln.