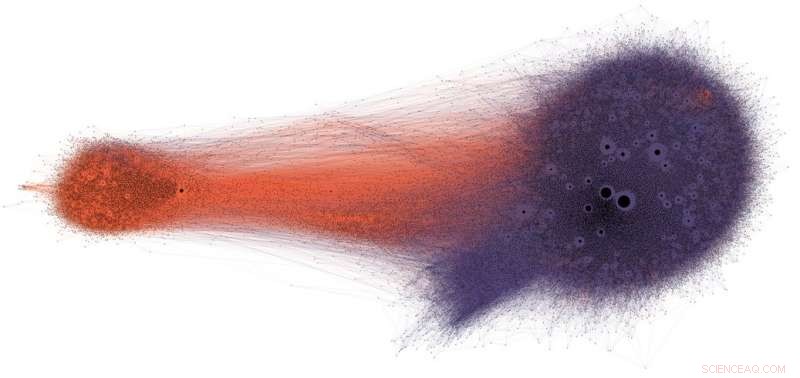

Människor som delar potentiell desinformation på Twitter (i lila) får sällan se korrigeringar eller faktagranskning (i orange). Kredit:Shao et al., CC BY-ND

Sociala medier är bland de primära nyhetskällorna i USA och över hela världen. Ändå utsätts användare för innehåll av tveksam noggrannhet, inklusive konspirationsteorier, clickbait, hyperpartiskt innehåll, pseudovetenskap och till och med tillverkade "falska nyheter" -rapporter.

Det är inte förvånande att det finns så mycket desinformation publicerad:Spam och onlinebedrägerier är lukrativa för brottslingar, och regerings- och politisk propaganda ger både partipolitiska och ekonomiska fördelar. Men det faktum att innehåll med låg trovärdighet sprids så snabbt och enkelt tyder på att människor och algoritmerna bakom sociala medieplattformar är sårbara för manipulation.

Vår forskning har identifierat tre typer av bias som gör sociala mediers ekosystem sårbart för både avsiktlig och oavsiktlig desinformation. Det är därför vårt observatorium på sociala medier vid Indiana University bygger verktyg för att hjälpa människor att bli medvetna om dessa fördomar och skydda sig från yttre påverkan som är utformade för att utnyttja dem.

Bias i hjärnan

Kognitiva fördomar har sitt ursprung i hur hjärnan behandlar informationen som varje person möter varje dag. Hjärnan kan bara hantera en begränsad mängd information, och för många inkommande stimuli kan orsaka informationsöverbelastning. Det i sig har allvarliga konsekvenser för kvaliteten på informationen på sociala medier. Vi har upptäckt att hård konkurrens om användarnas begränsade uppmärksamhet gör att vissa idéer blir virala trots deras låga kvalitet – även när människor föredrar att dela innehåll av hög kvalitet.

För att undvika att bli överväldigad, hjärnan använder ett antal knep. Dessa metoder är vanligtvis effektiva, men kan också bli fördomar när de tillämpas i fel sammanhang.

En kognitiv genväg händer när en person bestämmer sig för om han vill dela en berättelse som visas på deras sociala medier. Människor är mycket påverkade av de känslomässiga konnotationerna av en rubrik, även om det inte är en bra indikator på en artikels riktighet. Mycket viktigare är vem som skrev stycket.

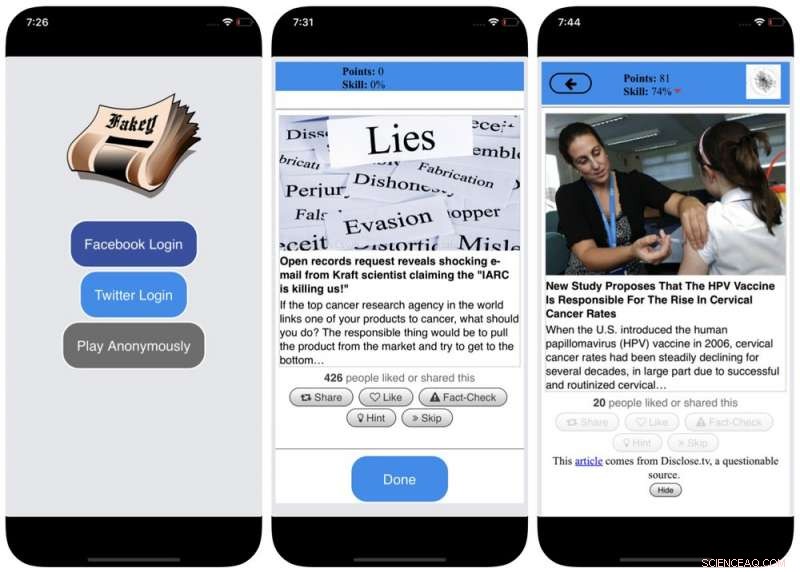

För att motverka denna partiskhet, och hjälpa människor att vara mer uppmärksamma på källan till ett anspråk innan de delar det, vi utvecklade Fakey, ett mobilt nyhetsläsande spel (gratis på Android och iOS) som simulerar ett typiskt nyhetsflöde för sociala medier, med en blandning av nyhetsartiklar från vanliga källor och källor med låg trovärdighet. Spelare får fler poäng för att dela nyheter från pålitliga källor och flagga misstänkt innehåll för faktakontroll. I processen, de lär sig känna igen signaler om källans trovärdighet, såsom hyperpartiska påståenden och känsloladdade rubriker.

Bias i samhället

En annan källa till partiskhet kommer från samhället. När människor ansluter direkt till sina kamrater, de sociala fördomar som styr deras val av vänner kommer att påverka den information de ser.

Faktiskt, i vår forskning har vi funnit att det är möjligt att avgöra en Twitter-användares politiska inriktning genom att helt enkelt titta på deras vänners partipolitiska preferenser. Vår analys av strukturen hos dessa partiska kommunikationsnätverk fann att sociala nätverk är särskilt effektiva för att sprida information – korrekt eller inte – när de är nära sammankopplade och frånkopplade från andra delar av samhället.

Tendensen att utvärdera information mer fördelaktigt om den kommer från deras egna sociala kretsar skapar "ekokammare" som är mogna för manipulation, antingen medvetet eller oavsiktligt. Detta hjälper till att förklara varför så många onlinekonversationer övergår till "vi mot dem"-konfrontationer.

Skärmdumpar av Fakey-spelet. Kredit:Mihai Avram och Filippo Menczer

För att studera hur strukturen för sociala nätverk online gör användare sårbara för desinformation, vi byggde Hoaxy, ett system som spårar och visualiserar spridningen av innehåll från källor med låg trovärdighet, och hur det konkurrerar med faktakontrollerande innehåll. Vår analys av uppgifterna som samlades in av Hoaxy under det amerikanska presidentvalet 2016 visar att Twitter-konton som delade felaktig information nästan helt var avskurna från de korrigeringar som gjorts av faktagranskare.

När vi gick igenom kontona som sprider desinformation, vi hittade en mycket tät kärngrupp av konton som nästan uteslutande retweetade varandra – inklusive flera bots. De enda gångerna som faktakontrollerande organisationer någonsin citerades eller nämndes av användarna i den felinformerade gruppen var när de ifrågasatte deras legitimitet eller hävdade motsatsen till vad de skrev.

Bias i maskinen

Den tredje gruppen av fördomar uppstår direkt från de algoritmer som används för att bestämma vad människor ser online. Både sociala medieplattformar och sökmotorer använder dem. Dessa personaliseringstekniker är utformade för att endast välja det mest engagerande och relevanta innehållet för varje enskild användare. Men när man gör det, det kan i slutändan förstärka användarnas kognitiva och sociala fördomar, vilket gör dem ännu mer sårbara för manipulation.

Till exempel, De detaljerade reklamverktygen som är inbyggda i många sociala medieplattformar låter desinformationskampanjare utnyttja bekräftelsebias genom att skräddarsy meddelanden till människor som redan är benägna att tro på dem.

Också, om en användare ofta klickar på Facebook-länkar från en viss nyhetskälla, Facebook kommer att tendera att visa den personen mer av webbplatsens innehåll. Denna så kallade "filterbubbla"-effekt kan isolera människor från olika perspektiv, stärka bekräftelsebias.

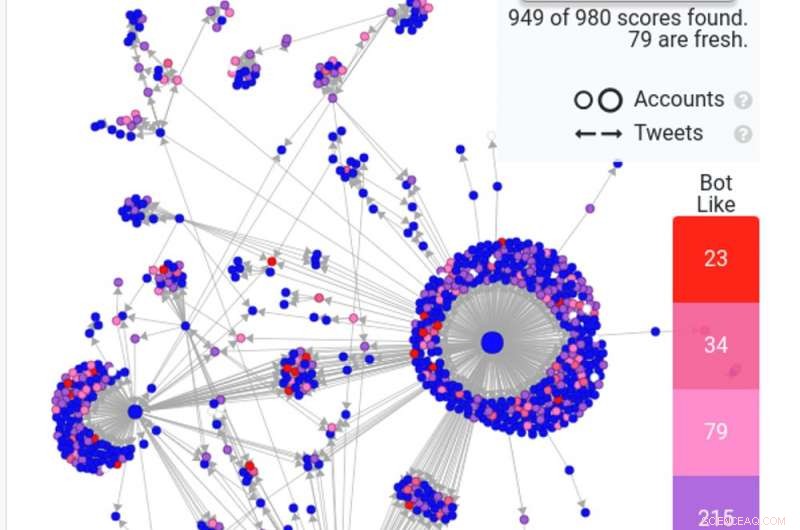

En skärmdump av en Hoaxy -sökning visar hur vanliga robotar - i rött och mörkrosa - sprider en falsk historia på Twitter. Kredit:Hoaxy

Vår egen forskning visar att sociala medieplattformar utsätter användare för en mindre mängd olika källor än icke-sociala mediesajter som Wikipedia. Eftersom detta är på nivån av en hel plattform, inte av en enda användare, vi kallar detta homogenitetsfördom.

En annan viktig ingrediens i sociala medier är information som trendar på plattformen, beroende på vad som får flest klick. Vi kallar detta popularitetsbias, eftersom vi har funnit att en algoritm utformad för att marknadsföra populärt innehåll kan negativt påverka den övergripande kvaliteten på informationen på plattformen. Detta matar också in i befintlig kognitiv fördom, förstärker det som verkar vara populärt oavsett dess kvalitet.

Alla dessa algoritmiska fördomar kan manipuleras av sociala bots, datorprogram som interagerar med människor via sociala medier. De flesta sociala bots, som Twitters Big Ben, är ofarliga. Dock, vissa döljer sin verkliga natur och används i illvilliga syften, som att öka desinformation eller felaktigt skapa utseendet på en gräsrotsrörelse, kallas även "astroturfing". Vi hittade bevis på denna typ av manipulation inför valet i USA 2010.

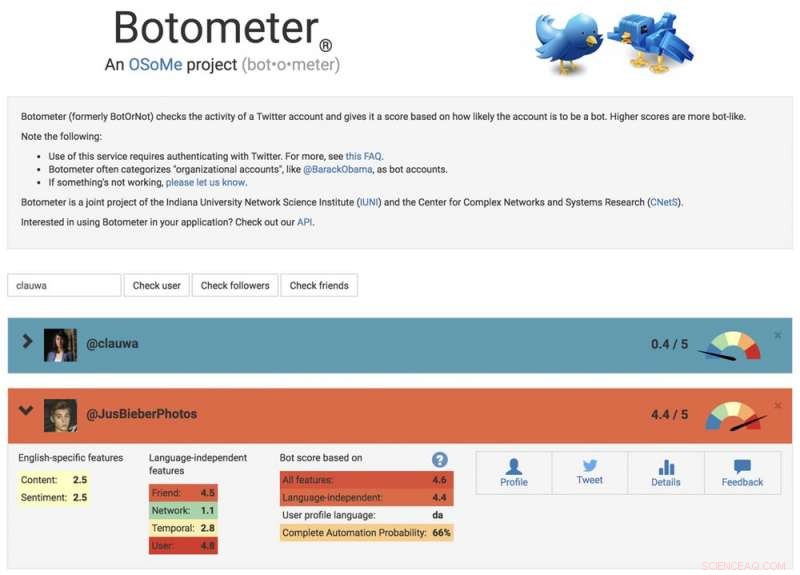

För att studera dessa manipulationsstrategier, vi utvecklade ett verktyg för att upptäcka sociala bots som heter Botometer. Botometer använder maskininlärning för att upptäcka botkonton, genom att inspektera tusentals olika funktioner i Twitter-konton, som tiden för sina inlägg, hur ofta den twittrar, och kontona den följer och retweetsar. Det är inte perfekt, men det har avslöjat att så många som 15 procent av Twitter-konton visar tecken på att vara bots.

Använda Botometer i kombination med Hoaxy, vi analyserade kärnan i desinformationsnätverket under 2016 års amerikanska presidentkampanj. Vi hittade många bots som utnyttjade både det kognitiva, bekräftelse och popularitetsfördomar hos deras offer och Twitters algoritmiska fördomar.

Dessa bots kan konstruera filterbubblor runt sårbara användare, matar dem med falska påståenden och felaktig information. Först, de kan locka uppmärksamhet från mänskliga användare som stöder en viss kandidat genom att twittra kandidatens hashtaggar eller genom att nämna och retweeta personen. Sedan kan botarna förstärka falska påståenden som smutsar ner motståndare genom att retweeta artiklar från källor med låg trovärdighet som matchar vissa sökord. Denna aktivitet gör också att algoritmen framhäver falska historier som delas brett för andra användare.

En skärmdump av Botometers webbplats, visar ett mänskligt och ett botkonto. Kredit:Botometer

Förstå komplexa sårbarheter

Även som vår forskning, och andra', visar hur individer, institutioner och till och med hela samhällen kan manipuleras på sociala medier, det finns många frågor kvar att besvara. Det är särskilt viktigt att upptäcka hur dessa olika fördomar interagerar med varandra, potentiellt skapar mer komplexa sårbarheter.

Verktyg som vårt erbjuder internetanvändare mer information om desinformation, och därför en viss grad av skydd mot dess skador. Lösningarna kommer sannolikt inte bara att vara tekniska, även om det förmodligen kommer att finnas några tekniska aspekter på dem. Men de måste ta hänsyn till de kognitiva och sociala aspekterna av problemet.

Redaktörens anmärkning:Den här artikeln uppdaterades den 10 januari, 2019, för att ta bort en länk till en studie som har dragits tillbaka. Texten i artikeln är fortfarande korrekt, och förblir oförändrad.

Denna artikel publicerades ursprungligen på The Conversation. Läs originalartikeln.